NVIDIA esitteli 20. syyskuuta uudet Ada Lovelace -grafiikka-arkkitehtuuriin pohjautuvat GeForce RTX 40 -sarjan näytönohjaimet ja ensimmäisenä myyntiin saapuu suorituskykyisin GeForce RTX 4090 -malli. Kaksi muuta ensimmäisessä aallossa julkaistua näytönohjainta ovat 12 ja 16 gigatavun näyttömuistilla varustetut RTX 4080 -mallit, jotka saapuvat myyntiin myöhemmin marraskuussa.

Saimme NVIDIAlta testiin yhtiön oman Founders Edition -mallin, jolla testitulokset saa julkaista tänään 11. lokakuuta eli päivää aiemmin kuin näytönohjainvalmistajien omilla 4090-malleilla. Kaikkien GeForce RTX 4090 -näytönohjaimien myynti alkaa kuitenkin testitulosten porrastamisesta huolimatta 12. lokakuuta klo 16. Tutustumme tässä artikkelissa NVIDIAn oman GeForce RTX 4090 Founders Edition -näytönohjaimen ominaisuuksiin ja suorituskykytestit on ajettu pääasiassa 3840×2160-resoluutioilla ilman säteenseurantaa ja säteenseuranta käytössä sekä kokeilussa on myös uusi DLSS 3 -ominaisuus. Mukana on myös tehonkulutus-, lämpötila- ja melumittaukset sekä ylikellotustestit.

Näytönohjaimen esittely

NVIDIAn oma Founders Edition -versio GeForce RTX 4090:stä ei valitettavasti tule Suomessa lainkaan myyntiin. Näytönohjain on hinnoiteltu yhtiön kotisivuilla 1999 euroon, mutta Suomessa myyntiin saapuvat ainoastaan näytönohjainvalmistajien omat mallit jälleenmyyjien kautta.

4090 Founders Edition perustuu hyvin pitkälle samaan suunnitteluun kuin RTX 30 -sarjan Founders Editionit. Näkyvimmät ulkoiset muutokset ovat hieman kuperat kyljet, pykälän isommat tuulettimet ja NVLink SLI -liittimen puuttuminen.

Näytönohjain on kolmen korttipaikan korkuinen ja 30,4 cm pitkä. Painoa on 2,19 kg ja rakenne on todella jämäkän ja laadukkaan tuntuinen metallinen kokonaisuus. Jäähdytysratkaisun molemmilla puolilla on 115 mm:n tuulettimet, jotka eivät pyöri lepotilassa.

Alapuolen tuuletin imee ilmaa näytönohjaimen etuosasta ja puhaltaa lämpimää ilmaa kotelosta ulos näyttöliittimien yläpuolelta. Takaosan tuuletin imee ilmaa näytönohjaimen läpi alhaalta ylöspäin jäähdyttäen matkalla grafiikkapiiriin kontaktissa olevasta höyrykammiosta lähteviä lämpöputkia. Takaosan tuuletin imee ilman suoraan kohti keskusmuistia ja prosessoria, mutta kotelon takaosaan sijoitetun tuulettimen pitäisi huolehtia lämpimän ilman puhaltamisesta ulos kotelosta.

Näytönohjain on varustettu yhdellä HDMI 2.1 -liittimellä ja kolmella DisplayPort 1.4a -liittimellä. Jostain syystä tuettuna ei ole jo muutama vuosi sitten esitelty DisplayPort 2.0 -standardi, joka on tuettuna Intelin Arc- ja tulee olemaan tuettuna myös AMD:n RDNA 3 -näytönohjaimissa.

4090:n TBP- eli Total Board Power -tehonkulutus on 450 wattia eli sama kuin 3090 Ti:llä. Näytönohjain on varustettu yhdellä ATX 3.0 -standardin mukaisella 16-pinnisellä PCI Express 5.0 12VHPWR-lisävirtaliittimellä. Uusimmista virtalähteistä kyseinen liitin saattaa löytyy jo vakiona, mutta vanhempien virtalähteiden omistajille mukana toimitetaan adapteri, johon liitetään neljä 8-pinnistä PCI Express -lisävirtaliitintä. Päädyn GeForce RTX -teksti on valaistu.

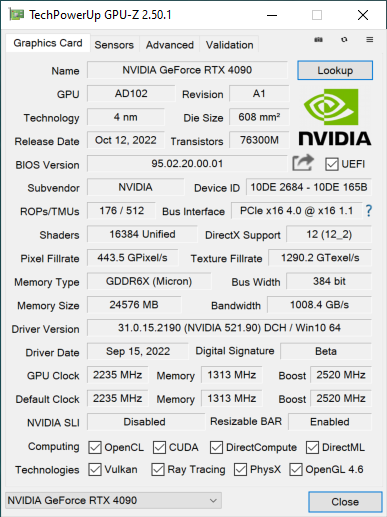

GeForce RTX 4090:ssä on käytössä ominaisuuksiltaan hieman karsittu AD102-grafiikkapiiri, joka valmistetaan TSMC:n optimoidulla 4 nanometrin eli N4-prosessilla. Käytössä on 16384 CUDA-ydintä, 512 teksturointiyksikköä, 512 tensoriydintä, 128 RT-ydintä ja 128 ROP-yksikköä. Grafiikkapiiri rakentuu 76,3 miljardista transistorista ja sen pinta-ala on 608 neliömillimetriä.

Muistiväylä on edelleen 384-bittinen ja sen jatkeena on 24 gigatavua 21,2 Gbps:n nopeudella toimivaa GDDR6X-muistia, jonka myötä muistikaistaa on käytettävissä 1018 Gt/s.

GeForce RTX 3090 Ti:hin ja Samsungin 8 nanometrin prosessilla valmistettuun GA102-grafiikkapiiriin verrattuna AD102:ssä on jopa 48 miljardia transistoria enemmän, mutta piisirun pinta-ala on 20 neliömilliä pienempi. 4090:n karsitussa grafiikkapiirissä CUDA-ytimiä, RT-ytimiä ja Tensor-ytimiä on käytössä 52 % enemmän kuin 3090 Ti:ssä. L2-välimuistin koko on kasvanut 6 megatavusta jopa 72 megatavuun, mutta näyttömuistin määrä ja kaistanleveys on pysynyt samana.

NVIDIA on asettanut Founders Edition -mallissaan grafiikkapiirin toimimaan 3D-rasituksessa 2520 MHz:n Boost-taajuudella. Todellisuudessa grafiikkapiirin kellotaajuus oli 3D-rasituksessa Cyberpunk 2077 -pelissä 4k-resoluutiolla noin 2700 MHz.

Testikokoonpano

Suorituskykytesteissä GeForce RTX 3090 -näytönohjainta verrattiin edellisen GeForce RTX 30 -sarjan suorituskykyisimpiin näytönohjaimiin eli 3090- ja 3090 TI -malleihin sekä 2080 Ti:hin. Mukana on testitulokset myös AMD:n leiristä suorituskykyisimmillä Radeon RX 6900 XT- ja 6950 XT -näytönohjaimilla.

Hintataso Suomessa 11.10.2022

- Radeon RX 6900 XT: alkaen n. 800 €

- Radeon RX 6950 XT: alkaen n. 1220 €

- GeForce RTX 3090: alkaen n. 1270 €

- GeForce RTX 3090 Ti: alkaen n. 1350 €

- GeForce RTX 4090: alkaen 1999 €

Näytönohjainten testikokoonpano on kasattu Cooler Masterin Cosmos C700P -kotelon sisälle, jonka etupaneelissa kaksi 140 mm:n kotelotuuletinta imee viileää ilmaa kotelon sisuksiin ja takapaneelissa yksi 140 mm:n tuuletin puhaltaa lämmintä ilmaa ulos. Testikokoonpanona toimi NZXT:n Kraken Z63 AIO -nestekierrolla jäähdytetty AMD:n 12-ytiminen Ryzen 9 5900X -prosessori asennettuna Asuksen ROG Crosshair VIII Hero -emolevylle ja 32 gigatavua DDR4-3600-nopeudella toimivaa keskusmuistia. Käyttöjärjestelmänä on käytössä 64-bittinen Windows 10 Pro asennettuna Corsairin 2 teratavun MP600 M.2 SSD:lle. Kokoonpanon virransyötöstä vastaa Asuksen 1200 watin ROG Thor -virtalähde.

- AMD Ryzen 9 5900X (12/24 ydintä/säiettä, boost 4,8 GHz)

- Asus ROG Crosshair VIII Hero Wi-Fi (AMD X570)

- 32 Gt Corsair Dominator Platinum RGB 3600 MHz (16-18-18-36)

- Corsair MP600 2 Tt M.2 SSD (PCI Express 4.0)

- Cooler Master COSMOS C700P -kotelo

- NZXT Kraken Z63 AIO -nestekierto

- Asus ROG Thor 1200W -virtalähde

- Microsoft Windows 10 Pro 64-bit

Näytönohjainten testimetodit

io-techin näytönohjaintesteissä suorituskykyä mitataan pelaamalla peliä 60 sekunnin ajan ja OCAT-sovelluksen avulla mitataan keskimääräinen ruudunpäivitysnopeus ja minimi, kun 1 % huonoimpia ruutuja jätetään huomioimatta. Kyseessä on tarkemmin ottaen 1. persentiili, kun ruutujen renderöintiajat on muutettu ruudunpäivitysnopeudeksi eli ruutua sekunnissa (FPS, Frame Per Second) ja järjestetty paremmuusjärjestykseen. Tavoitteena on jättää huomioimatta muutama yksittäinen muita hitaammin renderöity ruutu, joka on mahdollisesti poikkeustapaus.

Suorituskykytestit 3840×2160-resoluutiolla ilman säteenseurantaa

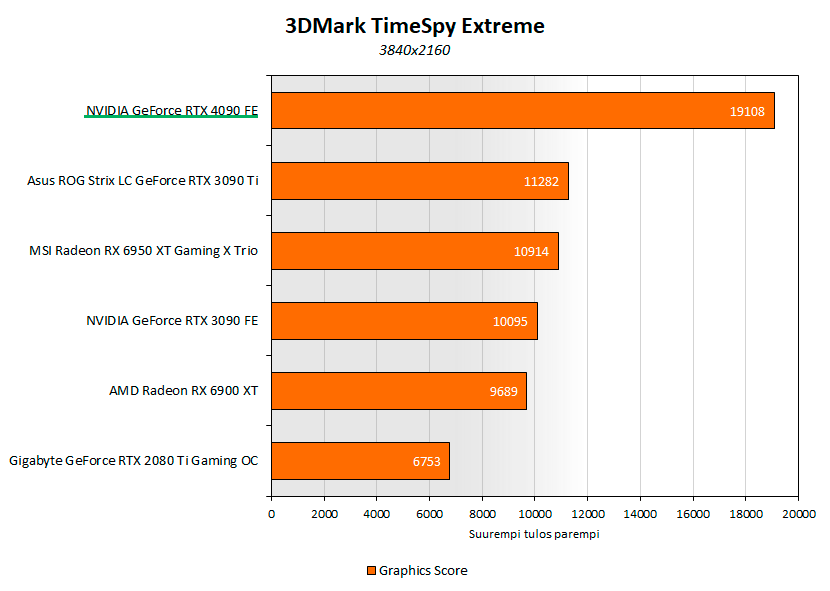

3DMark TimeSpy Extreme -testissä 4090:n grafiikkatulos oli 69 % parempi kuin 3090 Ti:llä.

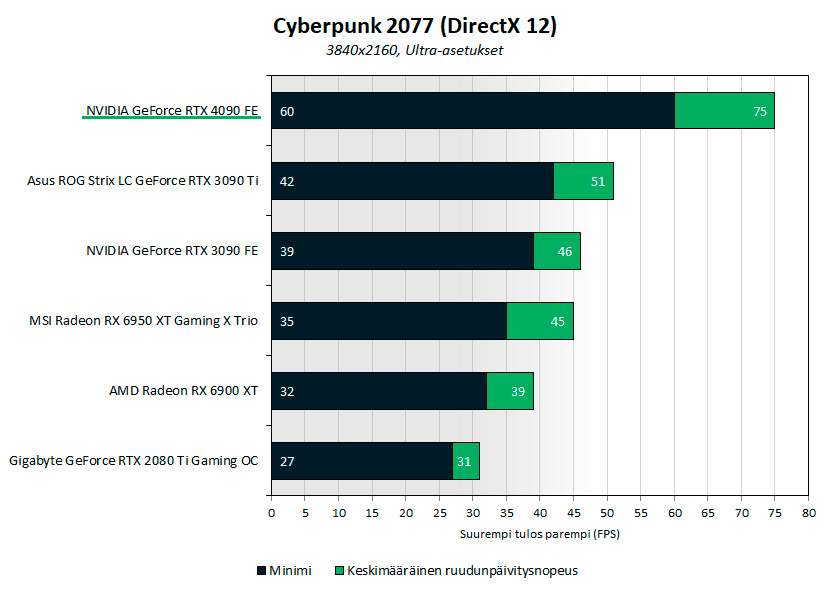

Cyberpunk 2077:ssä parhailla Ultra-kuvanlaatuasetuksilla 4090:n keskimääräinen ruudunpäivitysnopeus oli 47 % parempi kuin 3090 Ti:llä.

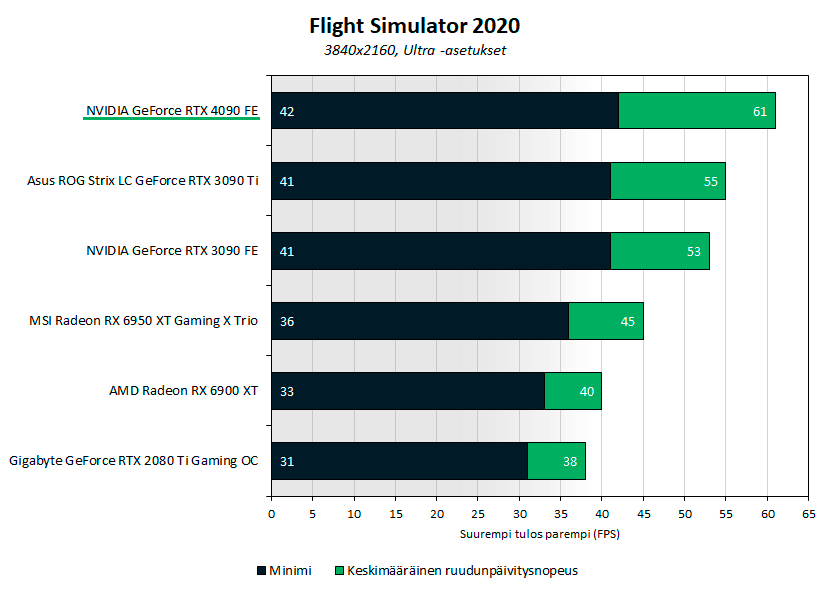

Flight Simulatorissa parhailla Ultra-kuvanlaatuasetuksilla 4090 oli 11 % suorituskykyisempi kuin 3090.

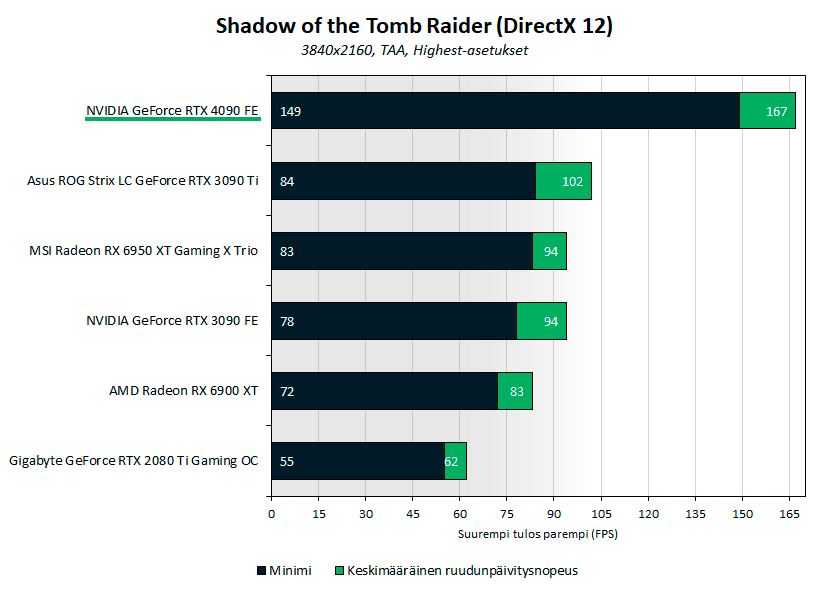

Shadow of the Tomb Raiderissa Highest-kuvanlaatuasetuksilla 4090 oli 64 % suorituskykyisempi kuin 3090 Ti.

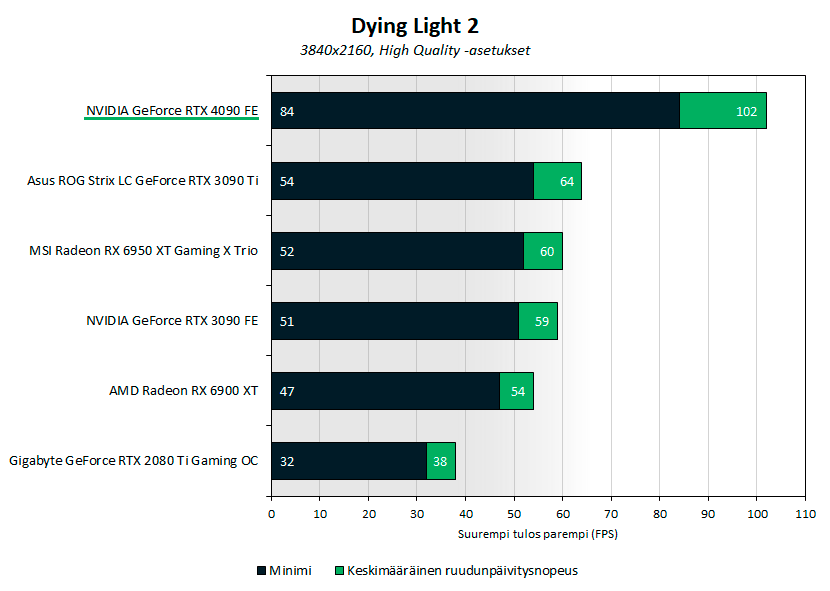

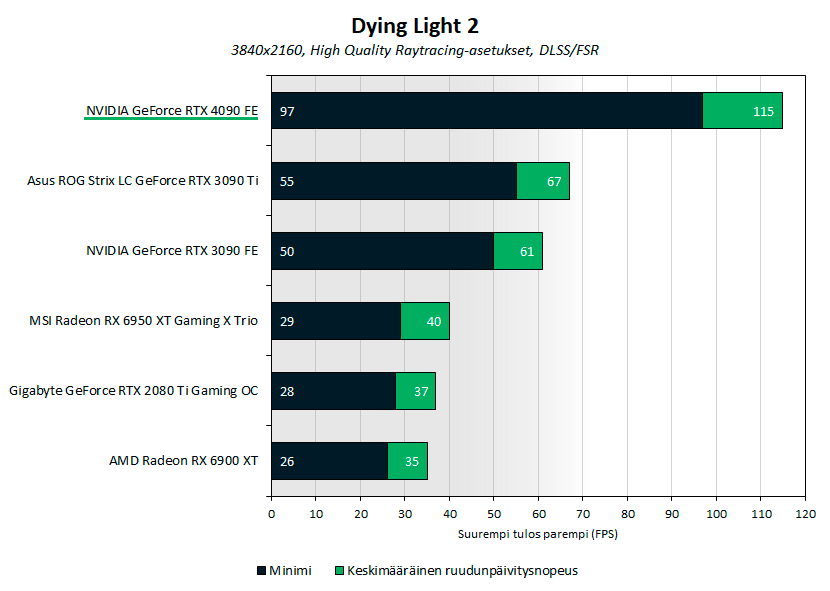

Dying Light 2:ssa parhailla High Quality -kuvanlaatuasetuksilla 4090 oli 59 % suorituskykyisempi kuin 3090 Ti.

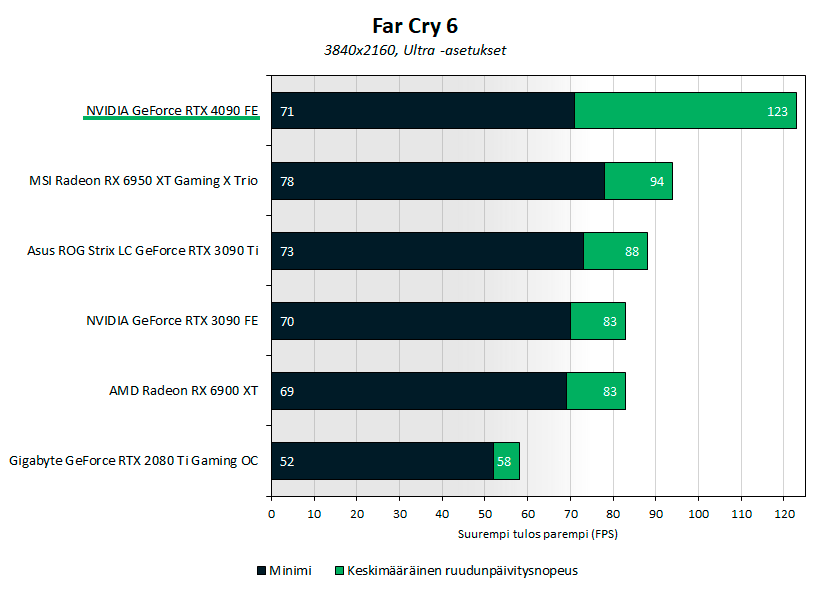

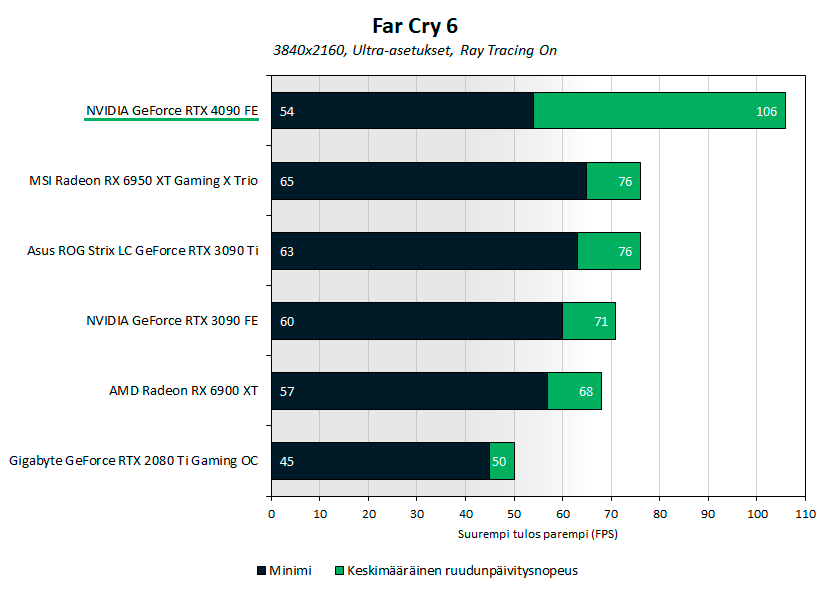

Far cry 6:ssa parhailla Ultra-kuvanlaatuasetuksilla 4090 oli 40 % suorituskykyisempi kuin 3090 Ti.

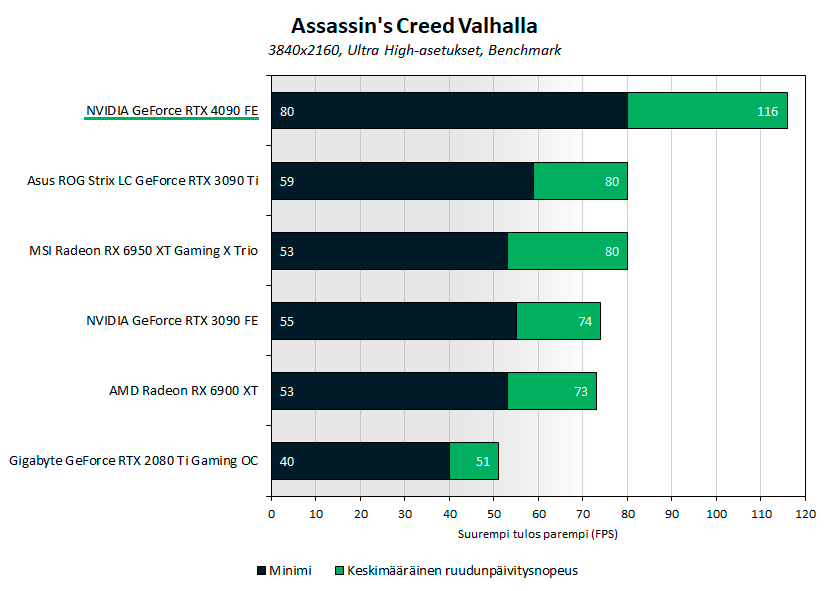

Assanssin’s Creed Valhallan sisäänrakennetussa benchmarkissa parhailla Ultra High -kuvanlaatuasetuksilla 4090 oli 45 % suorituskykyisempi kuin 3090 Ti.

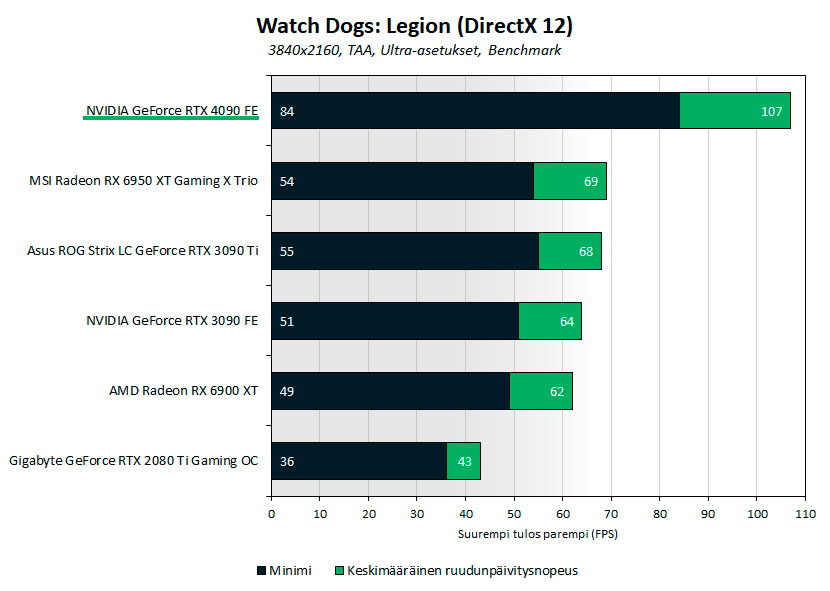

Watch Dogs: Legionin sisäänrakennetussa benchmarkissa parhailla Ultra-kuvanlaatuasetuksilla 4090 oli 55 % suorituskykyisempi kuin 3090 Ti.

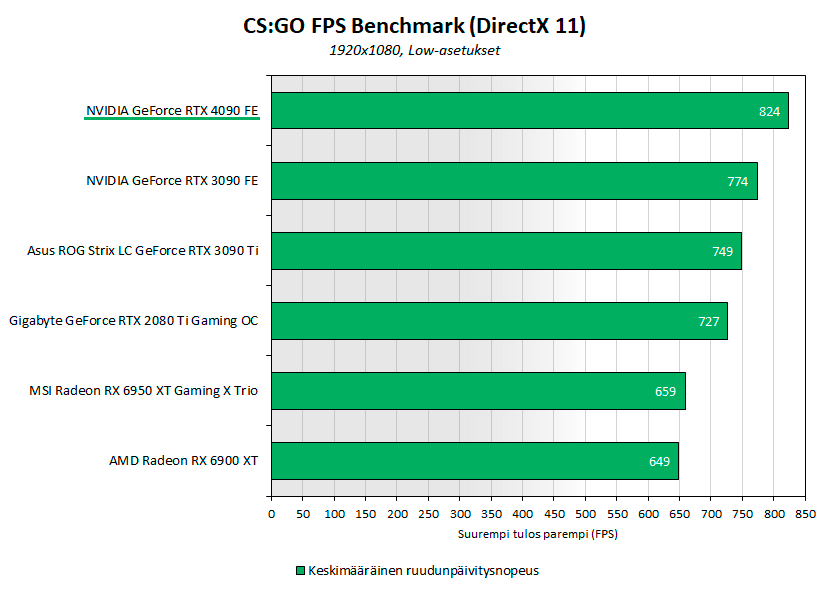

Suorituskykytestit 2560×1440- ja 1920×1080-resoluutioilla

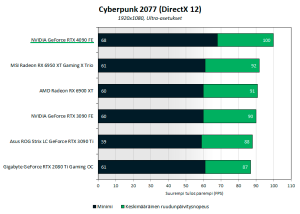

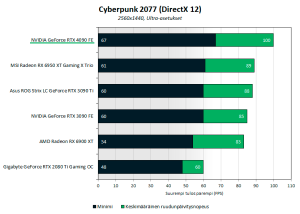

Cyberpunk 2077:ssä Full HD -resoluutiolla 4090 oli 9 % ja 1440p-resoluutiolla 12 % suorituskykyisempi kuin 3090 Ti. Molemmilla resoluutioilla 4090:llä Ryzen 9 5900X -prosessori oli suorituskyvyn pullonkaulana.

Counter Strike: Global Offensivessa oli Full HD -resoluutiolla käytössä alhaiset kuvanlaatuasetukset ja käytimme FPS Benchmark -testiä keskimääräisen ruudunpäivitysnopeuden mittaamiseen. 4090 oli 6 % suorituskykyisempi kuin 3090 Ti.

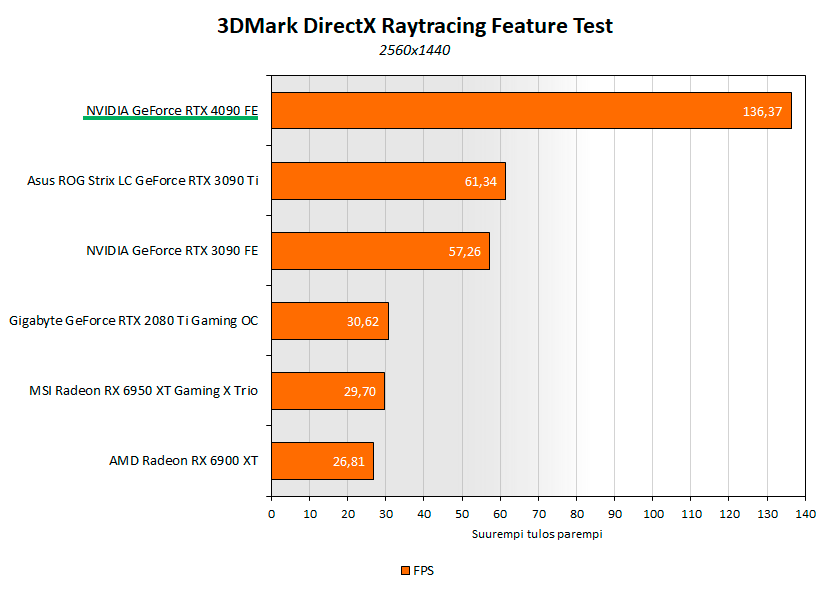

DirectX Raytracing & DLSS -suorituskyky (säteenseuranta)

3DMarkin puhtaasti säteenseurantaa käyttävässä DXR-testissä 4090 oli 120 % suorituskykyisempi kuin 3090 Ti.

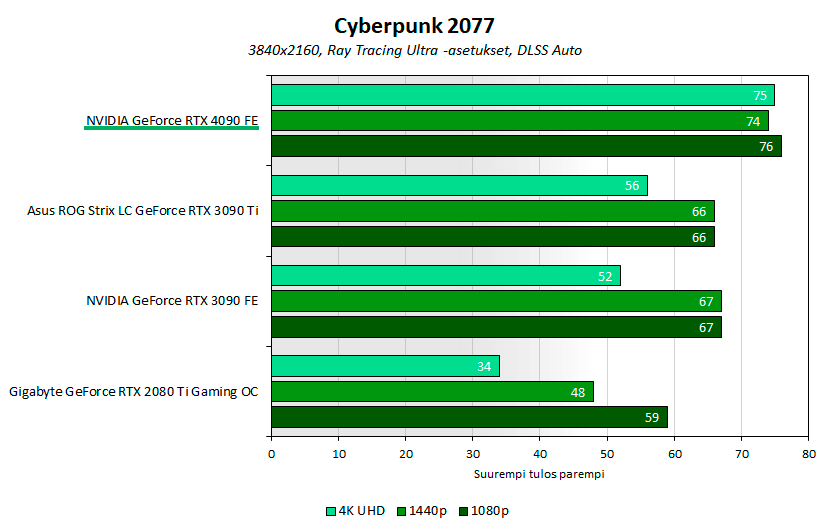

Cyberpunk 2077:ssä Ray Tracing Ultra -kuvanlaatuasetuksilla ja DLSS Auto-asetuksella 4090 oli 4k-resoluutiolla 34 % suorituskykyisempi kuin 3090 Ti. Kuten tuloksista näkee, 4090 on DLSS päällä suorituskykynsä osalta prosessoririippuvainen, kuten myös RTX 30 -sarjalaiset 1440p- ja 1080p-resoluutioilla.

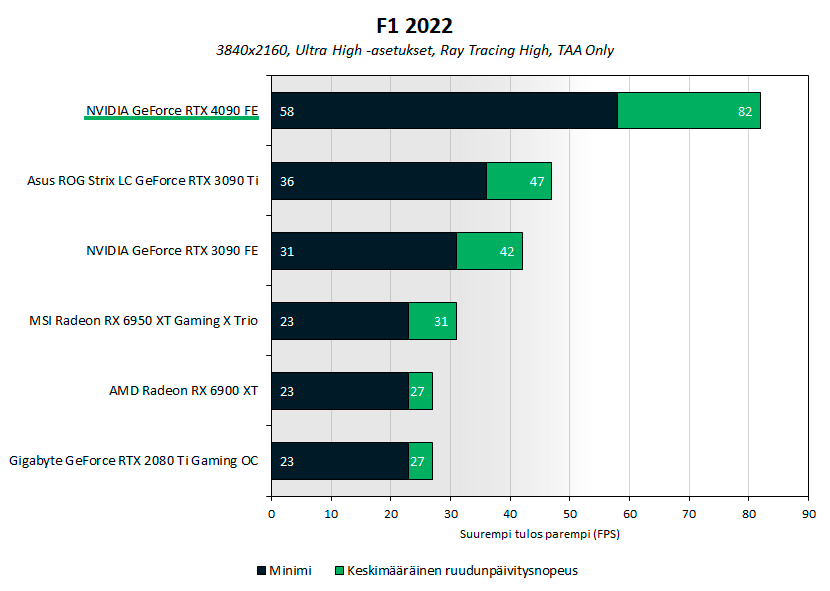

F1 22:ssä parhailla Ultra High -kuvanlaatuasetuksilla on käytössä myös säteenseuranta, mutta DLSS jätettiin pois käytöstä. 4090 oli 74 % suorituskykyisempi kuin 3090 Ti.

Dying Light 2:ssa High Quality Raytracing -asetuksilla ja DLSS käytössä 4090 oli 72 % suorituskykyisempi kuin 3090 Ti.

Far Cry 6:ssa Ultra-asetuksilla ja säteenseuranta käytössä 4090 oli 40 % suorituskykyisempi kuin 3090 Ti.

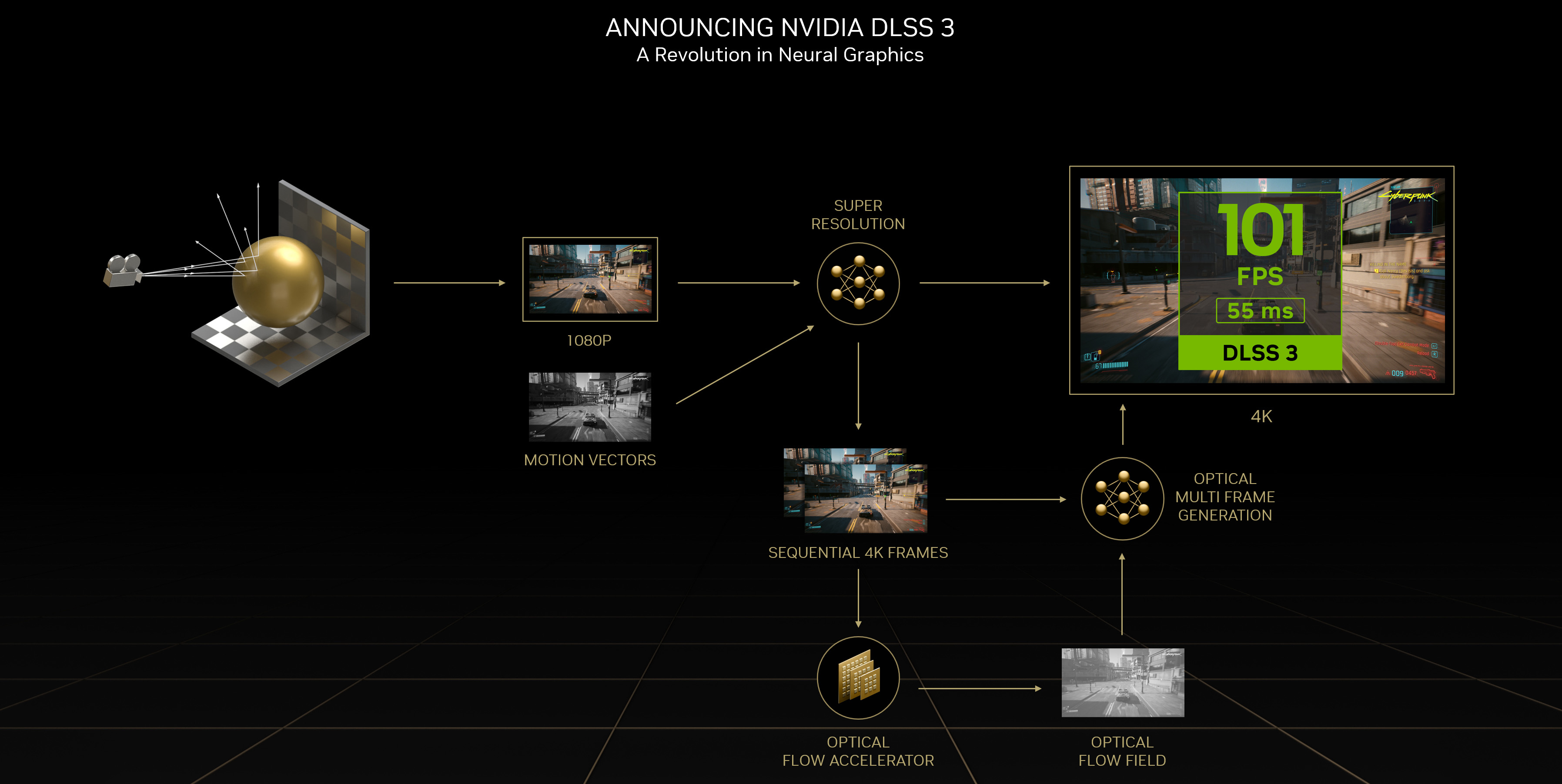

DLSS 3 -testit

NVIDIA esitteli RTX 40 -sarjan näytönohjaimien julkaisun yhteydessä uuden Deep Learning Super Sampling- eli DLSS 3 -version, jossa isoin uudistus on Optical Multi Frame Generation. Alemman renderöintiresoluution ja skaalauksen lisäksi nyt DLSS myös generoi kokonaan uusia ruutuja parantamaan ruudunpäivitysnopeutta. Frame Generation käyttää NVIDIAn aiempaa järeämpää Optical Flow Accelerator -yksikköä lukeakseen ruuduista liikedataa pelimoottorin liikevektoreiden lisäksi. Sen kerrotaan pystyvän seuraamaan kuvasta esimerkiksi heijastuksia ja vastaavia pikselitasolla asti. Esiopetettu neuroverkko rakentaa näistä ongitun datan ja edeltävien ruutujen perusteella tarvittavat tiedot luodakseen täysin itsenäisesti uuden ruudun, mikä parantaa suorituskykyä sekä prosessori- että näytönohjainriippuvaisissa tilanteissa.

DLSS 3 on tuettu vain Ada Lovelace -arkkitehtuuriin perustuvilla GeForce RTX 40 -sarjan näytönohjaimilla ja DLSS 3 -pelit tukevat automaattisesti myös NVIDIA Reflexiä varmistamaan mahdollisimman pienet viiveet. Tuki DLSS 3:lle on luvattu nyt jo 35 peliin, joista osan kohdalla kyse on nykyisen DLSS 2.0 -tuen päivittämisestä DLSS 3:een. Vaikka peliin olisi lisätty DLSS 3 -tuki, DLSS 2.0 toimii vanhemmilla näytönohjaimilla jatkossakin normaalisti.

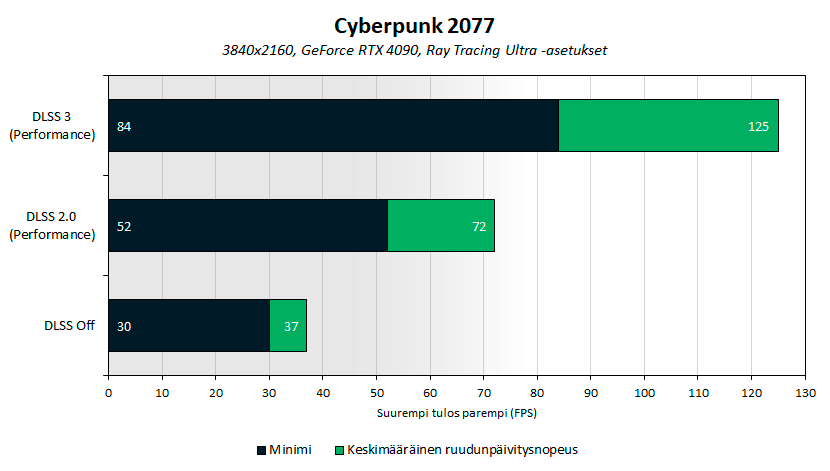

Testasimme 4k-resoluutiolla DLSS 3 -ominaisuutta Cyberpunk 2077 -pelillä säteenseuranta päällä ja vertasimme suorituskykyä ja silmämääräisesti kuvanlaatua DLSS 2.0:aan ja kun DLSS oli pois käytöstä.

Ray Tracing Ultra -asetuksella ilman DLSS:ää 4090:n suorituskyky jäi 37 FPS:ään ja peli ei käytännössä ollut sulavasti pelattava. DLSS 2.0 paransi keskimääräistä ruudunpäivitysnopeutta 95 % yli 70 FPS:ään ja pelikokemus parani samalla miellyttävän pehmeäksi. Pelatessa ja liikkeessä DLSS 2.0:n Performance-tason kuvanlaatua oli hyvin hankala erottaa natiivista 4k-kuvasta, mutta pysäytyskuvissa esimerkiksi heijastuksissa, verkkoaidassa, ritilöissä ja tekstuureissa oli havaittavissa selkeää sumeutta, mutta toisaalta jotkin tekstit ja tekstuurit olivat DLSS:llä alkuperäistä kuvaa terävämpiä.

DLSS 3 paransi keskimääräistä ruudunpäivitysnopeutta natiiviin kuvaan verrattuna 238 % ja DLSS 2.0:aan 74 %. Peliä pelatessa ja kuvankaappauksista eroa kuvanlaadussa DLSS 2.0:n ja DLSS 3:n välillä oli mahdoton todeta pikaisella testillä silmämääräisesti. DLSS 3:n kuvanlaatua tullaan tulevaisuudessa testaamaan eri tahojen toimesta todennäköisesti tarkemmin, joten jäämme odottamaan havaintoja kuvanlaatuun ja mahdollisiin ongelmatilanteisiin liittyen.

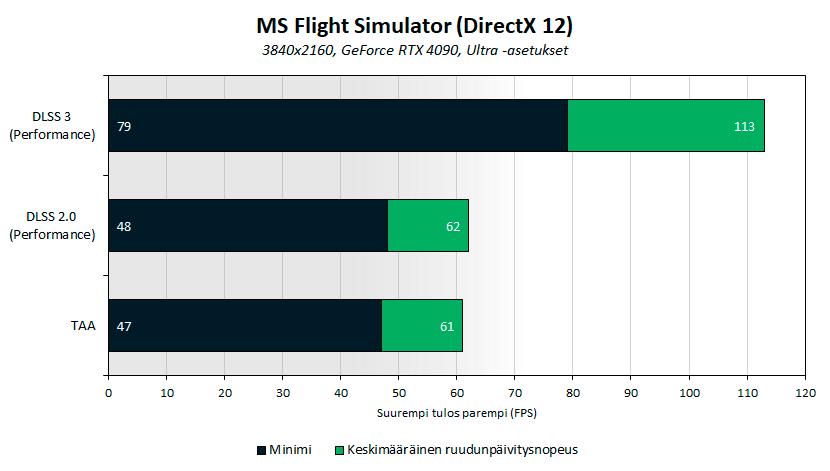

Microsoft Flight Simulatorissa DLSS 3 paransi keskimääräistä ruudunpäivitysnopeutta natiiviin kuvaan ja DLSS 2.0:aan verrattuna noin 82 %. Flight Simulatorissa DLSS:n käyttö aiheutti selvästi näkyviä grafiikkavirheitä muun muassa tekstuurien reunoihin, lentokoneen varjoon ja reunojenpehmennykseen. Samat virheet toistuivat DLSS 2.0:aa ja DLSS 3:a käytettäessä, joten odotettavissa on todennäköisesti vielä runsaasti viilausta DLSS-tukeen.

Hyötyohjelmat ja Open CL -suorituskyky

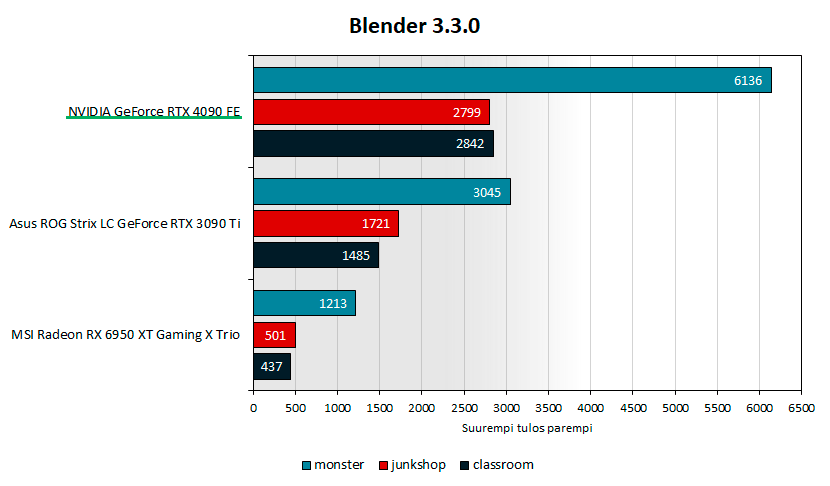

Blender 3.3.0 Benchmarkin testeissä 4090:n tulokset olivat 63-101 % parempia kuin 3090 Ti:llä.

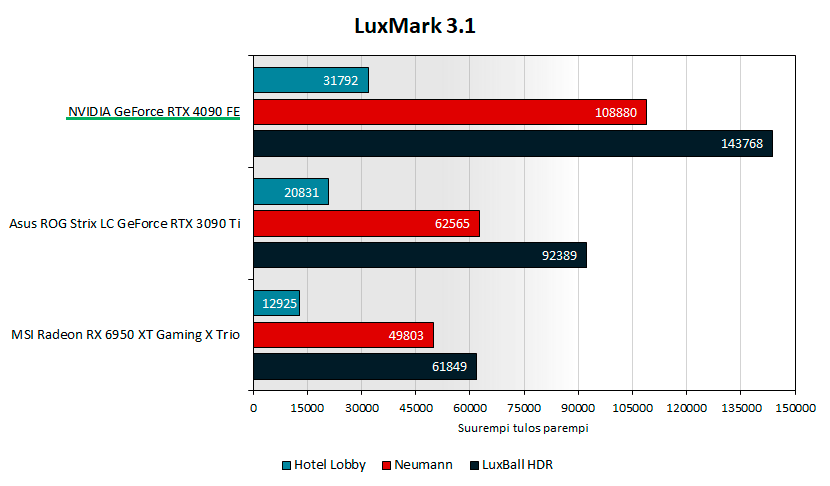

LuxMark 3.1:n testeissä 4090:n tulokset olivat 53-132 % parempia kuin 3090 Ti:llä.

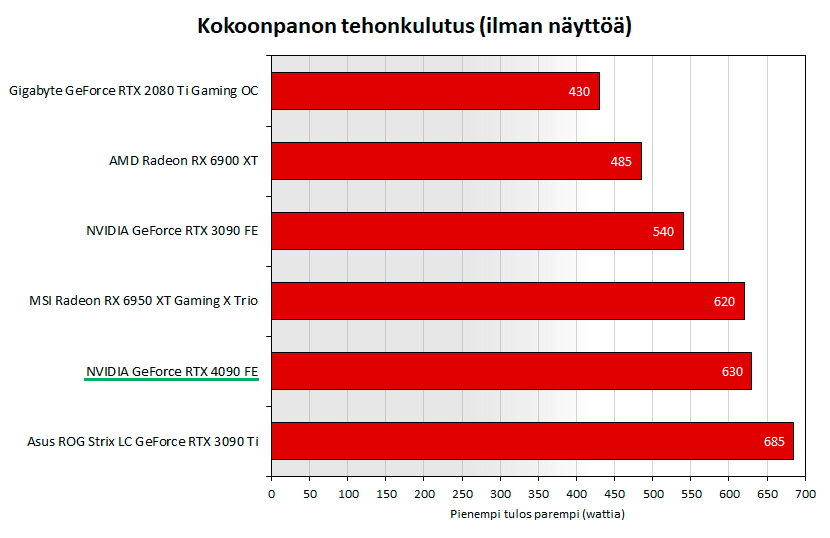

Tehonkulutusmittaukset

Tehonkulutusta mitattiin seinästä Coltech EMT707CTL -mittarilla, joka kertoo koko kokoonpanon tehonkulutuksen ilman näyttöä. 3D-rasituksena käytettiin Cyberpunk 2077 -peliä 4k-resoluutiolla.

Cyberpunk 2077:llä ja säteenseuranta päällä 4090:llä tehonkulutus nousi enimillään noin 450 wattiin, mutta kokoonpanon tehonkulutus jäi noin 55 wattia alhaisemmaksi kuin Asuksen nestejäähdytetyllä ja tehdasylikellotetulla ROG Stric 3090 Ti:llä. Uuden ATX 3.0 -standardin ja 16-pinnisen PCIe 5.0 12VHPWR -virtaliittimen mahdollistama 600 watin tehonkulutus ei siis toteutunut 4090 Foundes Editionilla lähellekään.

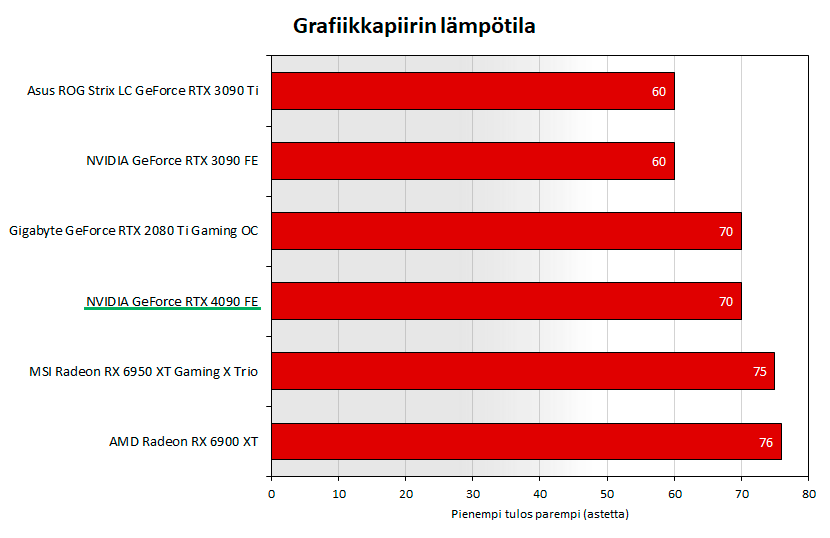

Lämpötilamittaukset

Grafiikkapiirin lämpötila mitattiin GPU-Z-ohjelman avulla ja 3D-rasituksena käytettiin Cyberpunk 2077 -peliä 4k-resoluutiolla.

AD102-grafiikkapiiri toimi NVIDIAn omalla Founders Editionin jäähdytyksellä 70-asteisena eli lämmöt olivat suhteellisen hyvin kurissa. GDDR6X-muistit toimivat 76-asteisena.

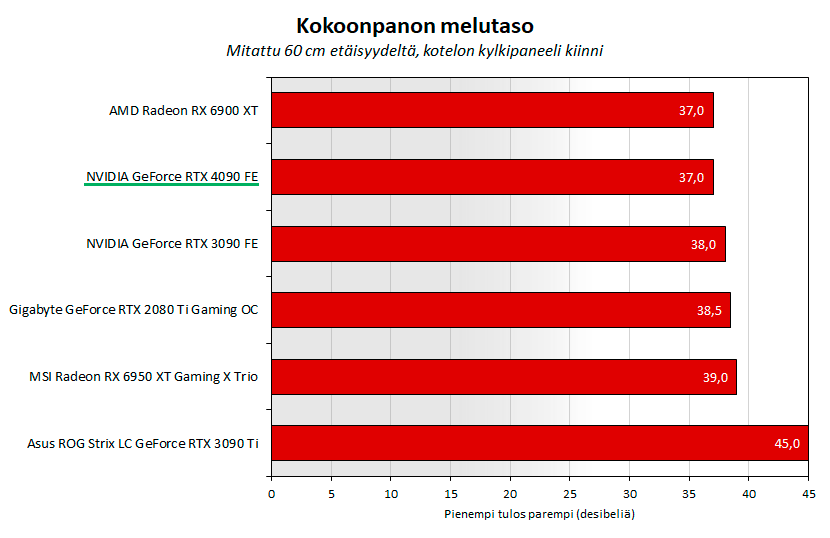

Melumittaukset

A-painotuksella suoritetuissa melumittauksissa Velleman DVM805 -desibelimittari sijoitettiin 60 senttimetrin päähän kiinni olevan kotelon kyljestä. Ympäristön melutaso testikokoonpano pois päältä oli 33,3 desibeliä. 3D-rasituksena käytettiin Cyberpunk 2077 -peliä -peliä 4k-resoluutiolla. Virallisesti melua mitataan tiettyjen standardien mukaan, joten mittaukset ovat lähinnä suuntaa antavia.

GeForce RTX 4090 Founders Edition toimi 3D-rasituksessa erittäin hiljaisena ja melutaso oli 37 desibeliä. Korvakuulolla kelojen vinkumista tai korkeataajuista sirinää ei havaittu käytännössä lainkaan.

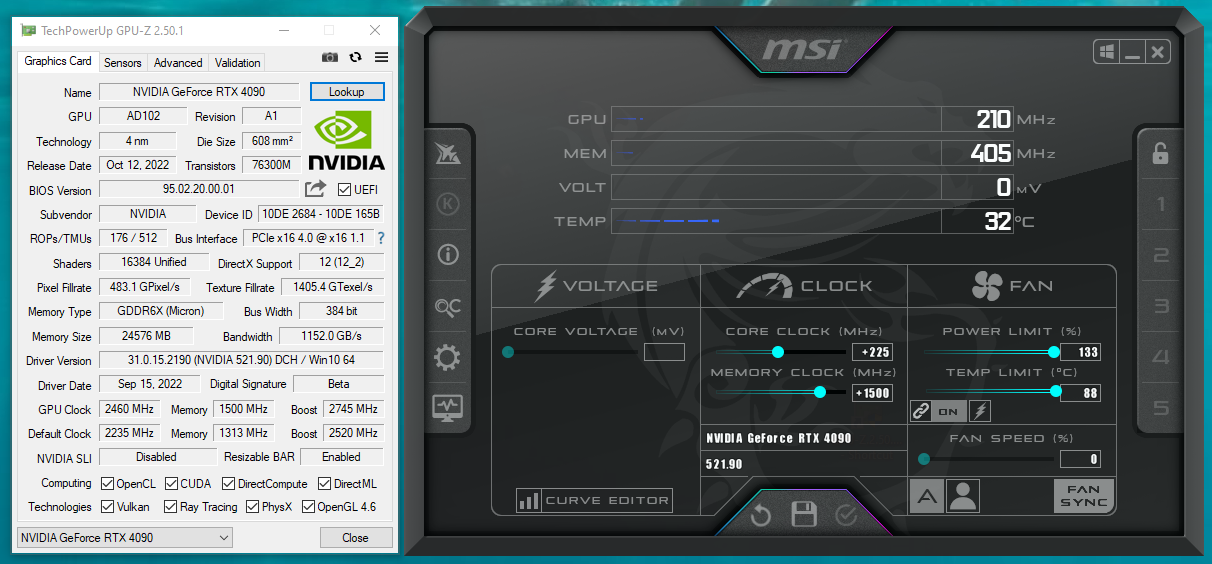

Ylikellotustestit

Ylikellotustestissä NVIDIAn GeForce RTX 4090 Founders Edition oli asennettuna suljetun Cooler Master Cosmos C700P -kotelon sisälle. Power- ja Temp Target- eli tehonkulutuksen ja lämpötilan ylärajat nostettiin maksimiin eli 133 %:iin ja 88 asteeseen. Tuulettimen kierrosnopeuden annettiin olla lämpötilan mukaan automaattisesti säätyvässä Auto-asennossa. Saavutetut kellotaajuudet ovat suuntaa antavia.

Power Limit on vakiona 450 wattia ja 33 % korotus maksimiin tarkoittaa noin 600 wattia.

Näytönohjain ylikellottui AD102-grafiikkapiirin osalta +225 MHz eli 2745 MHz:n Boost-taajuudelle, jolloin todellinen kellotaajuus 3D-rasituksessa oli 4k-resoluutiolla noin 2950 MHz. GDDR6X-muistit venyivät vakaasti ilman negatiivista vaikutusta suorituskykyyn +1500 MHz eli 24 Gbps:n nopeudelle (1500 MHz).

Grafiikkapiirin lämpötila nousi ylikellotettuna 70 asteesta 76 asteeseen, kokoonpanon tehonkulutus nousi 630 watista 705 wattiin ja melutaso nousi 37 desibelillä 38,5 desibeliin.

Ylikellotettuna RTX 4090 Founders Editionilla 3DMark Time Spy Extremen grafiikkatulos parani 7 % ja F1 22:n keskimääräinen ruudunpäivitysnopeus 9 %.

Loppuyhteenveto

GeForce RTX 4090 on erittäin suorituskykyinen näytönohjain ja tarjoaa jälleen ison harppauksen suorituskyvyssä eteenpäin erityisesti 4k-pelaamisessa verrattuna edelliseen RTX 30 -sarjaan. Valitettavasti huippusuorituskykyyn käsiinpäästäkseen joutuu myös venyttämään kukkaron nyörejä mallista riippuen 2000 euron verran tai enemmän. Siinä missä RTX 30 -sarjan julkaisun yhteydessä edullisia suositushintoja suhteessa suorituskykyyn jopa hämmästeltiin, on maailmantilanne muuttunut parin viime vuoden radikaalisti. NVIDIAn toimitusjohtaja Jensen Huang totesi RTX 40 -sarjan julkaisun yhteydessä suoraan, että sirujen hintojen laskeminen on menneisyyttä ja piikiekot ovat nykyään aiempaa kalliimpia.

io-techin testeissä RTX 4090 tarjosi perinteisissä peleissä ilman säteenseurantaa noin 50-70 % parempaa rasterointisuorituskykyä kuin 3090 Ti. 3DMarkin puhtaassa säteenseurantatestissä 4090 oli jopa 120 % suorituskykyisempi kuin 3090 Ti, mutta käytännössä peleissä säteenseuranta käytössä erot jäivät 40-70 %:iin.

Uusi DLSS 3 -ominaisuus ja Frame Generation eli ylimääräisten ruutujen luominen suorituskyvyn parantamiseksi toimi Cyberpunk 2077- ja Microsoft Flight Simulator -pelissä hyvin ja suorituskyky parani DLSS 2.0:aan verrattuna jopa 74-82 % ilman silmämääräisesti suurempaa vaikutusta kuvanlaatuun. RTX 4090:n suorituskyky oli jo ilman DLSS 3 -ominaisuutta niin vakuuttavalla tasolla, ettei sen käytölle nykypeleillä ollut akuuttia tarvetta, mutta sen avulla 4k-resoluutiolla ruudunpäivitysnopeudet saadaan nostettua maagisesta 60 FPS:stä yli 100 FPS:ään.

Tehonkulutus pyöri RTX 4090 Founders Editionilla suurimman osan ajasta 430-450 watin välimaastossa ja Founders Editionin kolmen korttipaikan korkuinen ja reilun parin kilon painoinen jäähdytysratkaisu hoiti hommansa erinomaisesti pitäen grafiikkapiirin ja muistien lämpötilat kurissa ja melutason miellyttävän hiljaisena. Tappiin ylikellotettuna näytönohjain haukkasi 500 wattia, grafiikkapiirin lämpötila nousi 76 asteeseen ja kokoonpanon melutaso nousi 38,5 desibeliin joka on jo selvästi kuultavissa, mutta ei vieläkään häiritsevän äänekäs. Ylikellotettuna näytönohjaimesta saatiin puristettua vielä vajaa 10 % lisää suorituskykyä.

Näytönohjainvalmistajien omien RTX 4090 -mallien testit saa julkaista huomenna. Odotettavissa on järeämpien jäähdytysratkaisuiden myötä alhaisempia lämpötiloja ja parempaa ylikellotuspotentiaalia. Näytönohjaimien myynti alkaa huomenna klo 16, mutta yli 2000 euron hinnoilla mitään järisyttävää ostoryntäystä tuskin on luvassa. AMD esittelee omat RDNA 3 -näytönohjaimensa kolmen viikon kuluttua, jolloin nähdään kuinka kilpailukykyisiä NVIDIAn RTX 4090- ja 4080-näytönohjaimien hinnat todellisuudessa ovat.

Kuka kuvittelee, että se satasen laadukas 850W tai 750W olisi huono virtalähde?

Kuka kuvittelee, että se satasen laadukas 850W tai 750W olisi huono virtalähde?

Tätä samaa on jauhettu nyt kohta 3-4 sukupolven ajan.

Okei, en ole niin tarkkaan aihetta seurannut. Itse en kuitenkaan kauhean naftille jättäisi powerin mitoitusta, kenties yhtä kokoluokkaa alemmas laadukkaalla powerilla uskaltaisi mennä. Saas nähdä, millaisia tehoja RDNA3 vaatii.

The battle of graphics card against power supply – power consumption and peak loads demystified | igor'sLAB

http://www.igorslab.de

Tämä taisi olla yksi ensimmäisiä "oikeita" tutkimuksia aiheeseen liittyen – aika monta vuotta sitten.

Jos tämä olisi ainut ulos tuleva malli niin voisi kyllä sanoa että kerrankin paljon maksamalla saa rahoilleen jotain uniikkia vastinetta (ja hyvän jäähyn!)…

…mutta totuushan on se että tämä on vain se yläporras ja taktisesti julkaistu eristettynä että jytky näyttää isommalta. Kunhan 4080:t saadaan testeihin puhumattakaan mahdollisesta 4070:stä niin se uutuudenviehätys jytkykortin hinnoilla karsiutunee aika nopeasti.

Hieno loikka eteenpäin, ja RT-tehosta kertoo jotain valtavaa se että HUBin anti-RT Steve sanoi että "viimein kortti jolla RT-asetukset on no-brainer" ja jopa tunnusti nauttineensa kun niitä sai päälle. Ei olisi kuvitellut vuosien naureksimisen jälkeen.

AMD:llä on kyllä varmaan hikiset paikat nyt vastata, riittääkö multiichipeissä temput pysyä perässä vai pitääkö nakata hinnoista

der8auer revikassa tuotiin esille aika hyvin että kortista saa kuristettua jopa 33% virrankulutuksesta kun optimoi ns ”sweetspottiin”

Niin AMD:lta olis kyllä peliliike leikata korttien MSRP puoleen nykyisestä. Voi NVIDIA kuumotella vastavuoroisesti kun keskiluokan myynti sakkaa täysin ja varastot edelleen pullollaan vanhaa 3k-sarjaa. Edelleen ne suurimmat tuotot tulee sieltä isoilta massoilta jos pystyy vaan vastaamaan tehokkaasti/edullisesti kysyntään.

kuten muilla sivuilla asia ilmenee,niillä alla olevat kivet tai ainakin 5800X3D,joka ei ole hyvä vaihtoehto.

7950x tai 12900k(s) olisi ollut oikea valinta.

paras todennäköisesti 13900K

Ehkä työkäytössä. Pelejä ajatellen en maksaisi 500€:a 3070:stä enää.

Tänks, pitääpä lukaista jossain välissä.

Keskiluokkaa on Core i5 tai Ryzen 5.

Mutta tosiaan turha vaihtaa testikokoonpanoa jos sieltä on juuri tulossa uusi kivi ykköspallille ja samat testit pitäisi ajaa viikon päästä uudelleen. (5800X3D taisi olla se kukkulan kuningas tällä hetkellä)

Eka kappele aika sekavaa tai liian nopeasti kehittyvää. Kakos kappaleen tulema ei ainakaan helpota näyttisten vertailua.

Meinaatteko myös testata Ryzen Threadripper 3990X tai vastaavalla prossulla suorituskykyä?

Olispa tuo ihan tosiasia eikä perinteistä jargonia, että yritetään kyllä laajentaa yms.

Ja kun porukka maksoi kaksi vuotta sitten kokonaiset 739€ kortista, joka on hemmetin paljon parempi ostos edelleen, jos hinta-perffiä katsoo. Yleensä hinta-perffi on parantunut genin myötä, vaan nyt näyttää huonolta.

Kyllä nvidia varmaan haluaisi laajentaa, kun oletettavasti saavat enemmän rahaa myymällä FE kortteja kuin mitä irtoaa voittoa AIB-korteista. Mutta ei se korttien myyminen ole niin triviaalia, kun pitää olla tukiorganisaatiotkin kunnossa asiakaspalveluun, palautuksiin jne. Menevät varmaan isot markkinat edellä. Tietty osansa voi olla vaikeutta siinäkin, että AIB:t eivät taida hirveästi tykätä, kun amd laajentaa heidän reviirilleen. Tulee tapaus EVGA mieleen.

Erittäin harvalla on laite, joka vaatisi jotain parempaa..

DisplayPort™ 1.4

7680 x 4320 / 60 Hz / 10 Bit Chroma / HDR

3840 x 2160 / 120 Hz / 10 Bit Chroma / HDR

Joku valitteli kulutuksia toisessa ketjussa mutta paitsi että sitä "varmaa tietoa" 900W tai edes 600W kortista ei nyt sitten käynytkään niin täältä voi käydä katsomassa mitä käy kun tehoa rajoitetaan (harmittavasti vain 300W asti, 200W olisi ollut mielenkiintoinen taso) tällä uudella ja vastaavasti edellisen polven kortilla:

Nvidia GeForce RTX 4090 FE im Test: Brachial schnell: Leistung mit weniger TDP und Overclocking

http://www.computerbase.de

Jos ei jaksa niin voin paljastaa että suorituskykyä katoaa 300W kohdalla n. 9% ja 450W 3090Ti jää edelleen kauas taakse. Eli jos watit pelottaa niin samoin kuin nykyprossuja Adaa näyttäisi voivan ajaa puolella kulutuksella mutta 90% täydestä suorituskyvystä. Ei paha mutta toki ennemmin kannattaa odottaa niitä paremmin hinnoiteltuja alemman luokan kortteja jotka tämän näytön perusteella tulee olemaan aika petoja nekin.

Ihmiset tajus väärin niitä huhuja joka ymmärtämättömyyttään tai ilkeämielisesti. 600W TGP:t on mun käsityksen mukaan maksimi mille nvidian piiri ja referenssi testattiin ja tuosta sitten lähdettiin kuvittelemaan tulossa olevan 600W tgp tuotetta.

Kai fe jäähyllä saa 600W tuotteen tehtyä, jos on pakko. 4090ti on vielä odottamassa amd:n rdna3:sta. Paljon riippunee rdna3:sta miten 4090ti muotoutuu. Jos on pakko niin tulee aikaisemmin ulos maksimeilla eli sinne 600W lähelle, jos nvidian kättä ei pakoteta niin tulee vasta vuoden päästä eikä välttämättä maksimeihin kellotettuna. 4090ti:hin vois laittaa täyden piirin, 24GBit muistit(vakiona) ja ehkä kelloja ylöspäin virrankulutuksen kustannuksella.

Varmaan aika monikin. Paljonkos virtalähteen pitäisi maksaa, jos päälle satasen 1000w "poweri," ei riitä ? Tämäkin testi 4090 rtx:llä ajettu 850w virtalähteellä.

Kokeneelle ja alaa tiiviisti seuranneelle nuo DLSS:n tilat (Performance … Quality) ovat selvää pässinlihaa. Itse olisin toivonut, että artikkelissa olisi mainittu selvästi mikä oli resoluutiona, josta se sitten skaalattiin 4K:oon. Ja koska tuo ”Frame Generation” on uusi juttu, niin olisin halunnut tietää, että laitetaanko se sitten natiiville 4K resoluutiolle vai pitääkö sillekin olla alempi, joka sitten skaalataan 4K:ksi.

4K pelaaminen ei näy vieläkään onnistuvan mikäli haluaa 4K näytölleen 144 – 165 FPS:n V-Syncin ollessa päällä (sidottu näytön virkistystaajuuteen). Tosin tähän on juuri DLSS 3 ja Frame Generation – omine repeilyineen ja varjoineen..

Olisin tietenkin Intelin Alder Laken omistavana halunnut nähdä testitulokset tällä alustalla ja lisäksi tietää olisiko Re-Sizeble BAR vaikuttanut tuloksiin. AMD:n puolella ilmeisesti SAM (Smart Access Memory). Kaikilla emoilla tämä asetus ei ole oletuksena päällä; esim. ASUS ja MSI.

Jutussa mainittiin myös, että RTX 4090 olisi tehokkain näytönohjain. RTX 4090Ti lienee kuitenkin se – sitten aikanaan/hetken päästä/ AMD Radeon julkkarin jälkeen. 😉

Samaa mieltä, että tuo nVidian oma FE malli on tyylikkäin ja jollaisen itsekin haluaisin. Foorumillahan joku totesi tuosta järeästä jäähdytysratkaisusta, että korttia olisi alun pitäen suunniteltu Samsungin 8 nm piireille.

Taisi olla kyse nimenomaan niistä virtapiikeistä jotka voivat aiheuttaa kokoonpanon sammumisen. Nyt näyttää siltä että Nvidian ajurit rajoittaa kelloja jos mennään yli 500w, eikä se johdu lämpöthrottlauksesta.

Fps häviö on noin 5-10%, mutta tehonkulutus pienenee noin 33%.

Jää nähtäväksi mitkä on 4080 hinnat.

Msrp hinta nousi 3090-4090 satasella, 1499$ –> 1599$

Eurohintojen vertailu on ehkä vähän hölmöä kun valuuttamme arvo on romahtanut valmistajan valuuttaan nähden. Käytännössä me maksetaan kovempaa hintaa, mutta syy ei suinkaan kokonaan ole nvidian.

FE hinnat jo tiedetään, eikä AIB kortit halvempia ole niin eikös ne jo tarpeeksi tarkkaan tiedetä?

Outo kommentti. Tämä korttihan nimenomaan olisi mahdollistanut 4K 120hz+ speksien käytön, kun 4K resollakin Ultra asetuksilla FPS:t paukkuu tuon 120 yli.

Ei se Steve ole ainut joka on jakanut tuon mielipiteen. Itse näen asian aivan samoin. Tähän asti RT suorituskyky on vain ollut liian tuhnu. Nyt alkaa olla vihdoin tehoa, mutta sitä on riittävästi vain tässä ja mahdollisessa Ti mallissa. 4080 ja alempien RT suorituskyky tulee jäämään tuhnuksi, joten ollaan vielä kaukana siitä että riittävä RT suorituskyky olisi kaikkien saatavilla.

Että 225W tulee tuosta 300W suorituskyvyssä nokkaan vain 1% vai miotä sää nyt oikein tarkoitat? Se puolella kulutuksella ajo kun olisi 225W, toi 300W on 33% pudotus, ei 50% eli puolet.

Joo tätä meinasin itsekin tulla sanomaan. Der8auer ajoi testejä 60% power targetilla -> tehonkulutus tippui 18-33% (alle 300 Wattiin) ja pelisuorituskyky kärsi vain 2-5%.

katso liitettä 970049katso liitettä 970050katso liitettä 970051

Onkohan noista kumpikaan kovin hyvä mittari pelisuorituskyvylle kun Cyberpunkissa on DLSS käytössä ja PUBG ei varsinaisesti ole kovin grafiikkarajoittunut peli.

No lähinnä kommentti viittasi siihen että puheissa näitä RT efektien vaikutuksia ei ole aiemmin voinut edes havaita mutta nytten kun suorituskykyä löytyy henkilöä miellyttävästi niin ne onkin kauniita ja upeita. Makunsa kullakin.

Huomaa että käytin erittäin tieteellistä ja tarkkaa termiä "puolella kulutuksella" jossa eksakti virhemarginaali on n. poronkusema. Eli en tarkoittanut mitään spesifiä lukua, koska kommentti kattoi sekä GPU:t että CPU:t joiden välillä se optimaalinen alue vaihtelee muutenkin. Jos tarkkoja lukuja haluaa laskeksia 4090:lle niin noi der8auerin käppyrät palvelee ainakin jollain tasolla.

Käsittääkseni niitä RT efektejä voi myös tuunata asetuksilla, ehkä se Steve on tarkastellut kokoajan asiaa siltä kantilta että RT efektit pitää tiputtaa niin matalaksi ettei suorituskyky tunkkaa liikaa että niillä ei ole enää juurikaan merkitystä.

Ja onhan noita oliko Dirt vai mikä jossa RT efektit on niin tuhnut että niitä taita juurikaan edes huomata johtuen siitä että on AMD sponssi peli ja haluttu saada se RT lätkä peliin mukaan joten tehty niin tuhnu RT toteutus että Radeon jaksaa sitä pyörittää.

Kyllä se tästä kun pari geniä mennään vielä eteenpäin niin toi RT alkaa olla kaikkien ulottuvilla niin että sitä voi sanoa muuksikin kuin tech demoksi taikka sellaisten leluksi joilla on varaa ostaa 2k€ näyttis.

Olihan tuossa myös 3DMark eri power targeteilla

Kyllähän RT on varsin käyttökelpoinen (3440×1440-resolla) myös 3080:lla josta maksoin sen 770€ julkaisussa.

Tätä sama olisin sanonut itsekin. Ihan mainiosti voi pelata rt-pelejä asetukset tapissa.

Hieno päivitys. Nyt on kyl semmonen kivi että ilman 4K resoja riittää kyllä todella pitkään.

Kertoo eniten siitä, että 1440p resoilla ei ero kasva kovin kummoisesti hintaan nähden, mutta toki on sielläkin nopea ja todella paljon riippuu pelistä missä sitä eroa tulee.

Tosi hyvä kuulla. Tämä näyttää olevan ainoa ilmaversio joka mahtuu koppaan kiintolevyjen kanssa.

Eipä sillä yli 120Hz: virkistystaajuudella ole juuri kenellekkään oikeasti yhtäänmitää merkitystä, muuta, kuin korkeintaan luulotaudin parantajana. Ei siis siinä kommentissa mitään outoa siis ole.

Lisäksi, kun on rautaa, niin pikkuhiljaa sitä rautaa myös käytetään raskaammin, joten ei sillä 4K:lla juurikaan FPS juhlita, pidemmän päällä. Toki on selvä että yli 60, joka on täysin riittävästi, tullaan yleensä pääsemään kyllä..

Kuulostaa lähinnä siltä ettet ole edes kokenut korkeita virkistystaajuuksia.

Asiasta on vaikka kuinka paljon tehty testejä ja kaikissa sama lopputulos; korkeammat herzit ja samalla vastaavasti korkeat FPS:t tekevät sinusta paremman pelaajan. Pystyt reagoimaan nopeisiin tilanteisiin nopeammin, huomaamaan nurkan takaa ilmestyvän vihollisen nopeammin jne.

Tämän hintaisessa kortissa todella pöyristyttävää ettei parempia näyttöstandardeja oltu tuettu kun kilpailijalta nämä löytyy.

No juu ei tässä vaiheessa toinna ostaa mitään näyttistä pelkästään RT:n takia. Se vaan on kiva lisä niissä peleissä joissa se nyt sattuu olemaan. Sille ei sinänsä kannata laskea mitään rahallista arvoa. Raaka rasterointiteho edelleen se tärkein asia jota kannattaa vertailla ja sen perusteella sitten ostaa mitä ostaa.

Sitten kun random indiekehittäjienkin peleissä alkaa olla RT ja DLSS yleisesti käytössä niin voi alkaa antaa jotain oikeeta painoarvoa RT-suorituskyvylle. Ennen sitä se on vaan lisäominaisuus. Jos vain pari prosenttia maailmalla kaikista julkaistuista peleistä tukee jotain teknologiaa niin on aika turha antaa sille teknologialle mitään sen kummempaa arvoa. Ei sillä etteikö RT olis hieno ja kiva juttu. Siitä vaan pitää tulla standardiominaisuus peleihin eikä vaan joku harvojen pelien erikoislisuke.

Ollaan vähän sellasessa muna vai kana -tilanteessa, kun tarvitaan joka Veetille sellanen kone joka jaksaa pyörittää säteenseurantaa ennen kuin se tulee yleistymään peleissä. Ja kun harva peli sitä tukee, niin porukalla ei oo mitään hirmu hinkua ostaa kalliita näyttiksiä sitä varten. Menee varmaan vielä pari-kolme sukupolvea että aletaan saada parin-kolmensadan euron hintaluokkaan sellaisia näyttiksiä joilla RT-pelit pyörii järkevällä tasolla. Sitten varmasti alkaa tulla niitä pelejäkin.