Apple ilmoitti viime kuussa hylkäävänsä x86-arkkitehtuurin seuraavan noin kahden vuoden kuluessa ja korvaavan sen omilla Arm-arkkitehtuuriin perustuvilla järjestelmäpiireillään. Yhtiö on paljastanut nyt myös näytönohjainpuolen kokevan saman uudistuksen.

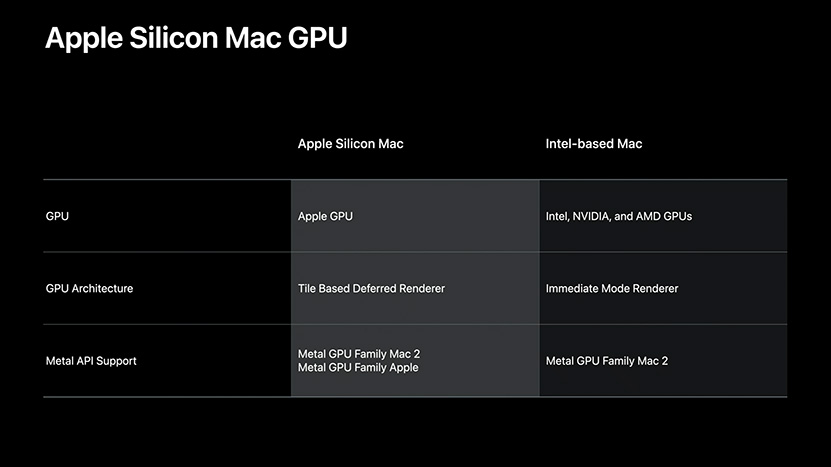

Applen x86-arkkitehtuuriin perustuvat Mac-tietokoneet ovat käyttäneet AMD:n, Intelin ja NVIDIAn näytönohjaimia, joskin NVIDIAn kohdalla kyse on lähinnä historiasta ja ajurituki on lopetettu viimeisillekin tuotteille jo viime vuoden puolella. Apple tulee jatkamaan AMD:n ja Intelin näytönohjainten käyttöä myös tulevaisuudessa Intel-pohjaisissa Mac-tietokoneissa, mutta Arm-pohjaisissa tilanne on toinen.

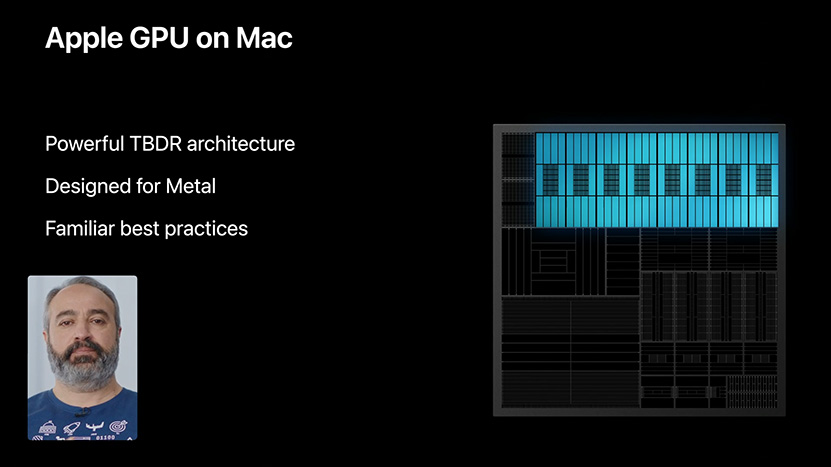

Applen WWDC20-konferenssin tiimoilta julkaistiin kehittäjille video, jossa sen näytönohjainajuripuolen johtaja kertoo yhtiön suunnitelmista näytönohjainpuolelle lähitulevaisuudessa. Videon mukaan Arm-arkkitehtuuriin perustuvissa Mac-tietokoneissa tullaan käyttämään yksinomaan Applen omia näytönohjaimia, jotka hyödyntävät mobiilipuolelta tuttua TBDR-arkkitehtuuria (Tile-Based Deferred Rendering). Käytännössä tämä tarkoittanee Imaginationin PowerVR:n suunnittelemaa arkkitehtuuria, minkä pohjalta joko Apple itse tai PowerVR Applen toimeksiannosta suunnittelee varsinaiset grafiikkapiirit tai IP-blokit integroitavaksi osaksi järjestelmäpiiriä. Valitettavasti videolla ei paljasteta tarkempia tietoja itse arkkitehtuurista tai miten sen suorituskyky tulee vertautumaan PC-puolen kilpailijoihin.

Lähde: Apple

Vaikka Apple iso ja rikas onkin, niin jotenkin alkaa tuntua ettei ne muskelit tule kuitenkaan riittämään näin laajalla rintamalla ainakaan kustannustehokkaasti. Toisaalta väliäkös sillä, laitetaan nolla perään niin kyllä ne ydinporukka ostaa kuitenkin vaikka pitäisi vaatteet myydä päältä.

Eihän Apple tässä mitään omaa näytönohjainta ole tyhjästä suunnittelemassa, vaan se on joko PowerVR:n suunnittelema GPU tai Applen PowerVR:n arkkitehtuurin pohjalta suunnittelema GPU, ihan niin kuin siellä mobiilipuolellakin (Applehan kertaalleen jo ilmoitti ettei sen tarvitse enää rojalteja maksella, mutta ei tainnut mennä kolmeakaan vuotta kunnes häntä koipien välissä piti käydä uutta lisenssiä pyytämässä)

Apple toki miettii liikkujaan oman liiketoiminnan kannalta järkevään suuntaan mutta nyt jo on nähtävissä esim. Photoshopilla työskennellessä että PC:llä homma sujuu aika paljon joutusammin. Mac pro:lla esim. suodattimien kanssa tulee vastaan tilanteita missä homma ei sujukkaan niin joutusastai kun tuolla 12/24 core AMD:llä jossa on GTX2070 Super näytönohjain ja muistia kivat 64 gigaa. Musahommissa toki Apple pesee tuon PC:n pelkästään käytettävyydessä 100-0 ja varsinkin editoidessa ja äänittäessä Apple on se ykkönen edelleen. Mutta ARM? Miten se skaalautuu tehon suhteen vs. nykyiset x86:set? Toki ARM ns. prossuja voidaan lätkiä nippuun vaikka sata ja siten saadaan ns. laskentatehoa mutta silti epäilyttää koko homma hieman. Toki ei pidä tuomita ennen kun ensimmäinen ns. Mac ARM:n hyppysissä ja voidaan kokeilla miten se homma pelittää. Onhan Applella se etu että softa voidaan tehdä vain ja ainostaan sen koneisiin joten sillisalaatti al’a PC puoli voidaan välttää ja näin saada etua tehonkin suhteen. Saas nähdä miten se homma sitten pelaa…

Ei tuo niin kovin kaukaa haettu idea kumminkaan ole. Tehdäänhän noita supertietokoneitakin laskentakäyttöön ja niistä löytyy myös x86 arkkitehtuurin lisäksi ARM -arkkitehtuuria. X86 -arkkitehtuurilla ei oman käsitykseni mukaan olisi oikeastaan edes mahdollista nykypäivänä suunnitella mitään järkevän oloista älypuhelinta, ilman suurta tehohävikkiä.

Veikkaan että Applen tulevat läppärit tavallaan poistuu markkinoilta ja tilalle tulee Ipadin kaltaisia ”läppäreitä”, joihin kaikki lisälaitteet näppäimistöä myöten tulee maksamaan maltaita. Sen sijaan tehot siinä segmentissä kovenee ja uskaltaisin väittää että myös älypuhelin segmentissä Apple:lla on teknisesti ARM-teknologiassa kova etumatka muihin nähden.

Läppäripuolella jo valtaosa intelin nykyisistä prosessoreista alkaa olemaan melkoisia throttlaavia matkakiukaita, joita ei pitäisi omasta mielestä asentaa enää mihinkään läppärin paksuiseen laitteeseen.

… Varsinkaan Applen suosimiin paksuuksiin läppäreissä…

Eli arm lienee oikein hyvä valinta parin millin paksuisiin powerbookkeihin ja aireihin!

Se on kyllä totta että jos joku saa tällaisen arkkitehtuurimuutoksen onnistumaan niin se on Apple. Heillä kun on lähes koko ekosysteemi omissa tassuissaan, niin isompikin muutos voi olla mahdollinen. Silti mitä nyt olen näiden ARM-pikkukoneiden (Raspi ja kloonit) kanssa pelaillut, niin kyllä se vieläkin vaan on vähän tahmeaa. Toki ei nuo nyt edusta ARM-kärkipäätä missään tapauksessa, mutta silti odottaisi että vähän liukkaammin asiat hoituisivat. Kyllä noilla silti jo 70% perushommista hoitaa, mutta silti olen nyt itse alkanut himassa virtualisoimaan noita nutikoita yhteen x86-palvelimeen kun hallinta, ylläpito jne helpompaa. Vaikka tuo x86-palvelin on joku 7v vanha AMD:n APU niin silti tuntuu kaikki sujuvan hiukan liukkaammin.

Ei siinä, toivon kyllä että ARMista saadaan se tulevaisuuden arkkitehtuuri. Samalla ehkä on pieni mahdollisuus päästä USA:n it-monopolien alta parempaan suojaan. Applella on tosiaan langan päät käsissään eli pystynevät optimoimaan raudan ja softan hyvin pitkälle kun taas pc-puolella heterogeenisyyttä on enemmän ja varmaan myös vaikeampi painostaa porukkaa päivittämään uuteen. Hankalintahan on siirtymävaihe jos käyttäjäkunta jakautuu x86- ja ARMin kesken kovin pitkäksi aikaa, niin se on kehittäjille kallista lystiä ylläpitää uusia koodipolkuja. Softatuki sen tulevaisuuden määrää.

Sinänsä Applelta näppärä suunnannäyttö, mutta voisivat nyt heittää tuon Metal-rajapinnan kuikkaan ja käyttää vaikka sitä Vulkania tai OpenCL/GL:ää. No ei pelaajat nyt ole pitkään aikaan olleetkaan Applen kohdeyleisöä, niin väliäkös tuolla.

Jos vertaat raspberry pi:tä johonkin niin vertaa sitä mielummmin johonkin peruspenaan, tai sitten vaikka rankasti alikellotettuun ekan sukupolven Atomiin. Tai Intelin quarckiin.

Ne Bobcat- ja Bulldozer-johdannaiset ytimet mitä niissä AMDn APUissa on ziljoona kertaa isompia, monimutkaisempia, virtasyöpömpiä ja kalliimpia kuin Raspberry pi:n ytimet.

Applen ARM-ytimet sen sijaan ovat oikeasti isoja, tehokkaita ja nopeita. Paljon tehokkaampia kuin niiden AMDn APUjen ytimet(poislukien zen-APUt), tällä hetkellä hyvin lähellä skylakea ja zeniä ja parissa vuodessa voi helposti mennä ohi.

x86ssa ei ole mitään monopolia, vaan duopoli.

ARM-käskykanta taas on täysin ARMin hallussa eikä kukaan voi tehdä ARM-prossuja ilman lupaa ARMilta. ARM toki lisensoi oikeutta tehdä niitä muille, mutta ARM voisi koska tahansa lopettaa myöntämästä näitä lisenssejä.

Eli tämä tarkoittaa siirtymistä duopolista monopoliin.

Ei ARMiin siirtyminen tarkoita mitään uusia koodipolkuja. Se tarkoittaa sitä, että KOKO SOFTA käännetään vaan ARM-kääntäjällä, ja niin kauan kun siitä ARMista ei ole useampia eri tuettuja versioita, mitään koodipolkukikkailuita ei tarvita.

Ja Applen kehitystyökalut tulee ilmeisesti tekemään tämän hyvin automaattisesti, että käytännössä ohjelmoijan ei tarvi nähdä tästä juuri mitään vaivaa.

Oletko koodannut miellekään mainituista rajapinnoista?

OpenCL ja Vulkan, vaikka ovat tehokkaita ja avoimia rajapintoja, ovat myös todella tuskaisia käyttää.

Jospa nyt aloittaisit sillä, että ottaisit vähän selvää missä suorituskykyluokassa Apple on jo nyt kännykkä- ja tablettikokoluokan ytimillään jo.

Ja sitten mietit, paljonko ihan samastakin ytimestä saa suorituskykyä lisää kun virrankulutusrajaa, jännitettä ja kelloa hiukan nostetaan että ei olla parin watin luokassa ~2.66 GHz:ssa vaan saadaan ne kellot jonnekin sinne 3 GHz päälle.

Ja sen jälkeen mietitään, kuinka paljon lisätehoa saadaan sillä, että suunnitellaan vaikka muuten melko samanlaisesta mikroarkkitehtuurista vähän työpöytäoptimoidumpi versio, jossa on pidempi liukuhihna, jossa kelloa saadaan vaikka vielä ~25% lisää, lähelle 4 GHz:aa, mutta IPC pidempien viiveiden takia putoaa vaikka ~8%. Tai IPC pysyy ennallaan, koska samalla ytimestä tehdään hiukan järeämpi(ja virtasyöpömpi, ja kalliimpi), koska tähän on varaa työpöydällä.

ARMv8ssa ei ole oikeastaan mitään mikä tekisi siitä huonommin soveltuvatn suuren suorituskyvyn prosessoreihin kuin x86; Päin vastoin, siinä on useampia näppäriä pieniä ominaisuuksia jotka tekee siitä hiukan paremmin soveltuvan siihen (esim. usean rekisterin kerralla lataavat/tallettavat muistioperaatiot, ehdolliset vertailut). ARMista myös puuttuu ne idiotismit joiden takia 1980-luvun RISCit (mm. MIPS ja SPARC) eivät pidemän päälle pärjänneet x86lle.

Tyypillinen Raspberry Pi maksaa alle satasen. Miten hyvän Intel/AMD-pohjaisen emolevy-prosessori-muisti-kombon ajattelit saavasi alle satasella uutena? Raspberry Pi:n prosessori vastaa suorituskyvyltään jotain alle parinsadan euron kännykkää.

Ihan hyvin olisi.

Suurin haitta x86sta vähävirtaisessa käytössä on sen monimutkainen dekoodaus. Ja ei tämän overhead siihen virrankulutukseen hirveän suuri ole, korkeintaan 10% luokkaa.

Läppäripuolella Intelillä on jo vuoden ollut markkinoilla Sunny Cove, joka ei täytä määritelmääsi.

Tosin kuinka paljon noissa musajutuissa on lopulta sitten kyse käyttöjärjestelmästä? Rautahan nyt on ollut samaa 15 vuotta.

Noista kannattaa pysyä kyllä täysin erossa vähintään pari kolme ensimmäistä sukupolvea, jos on tarvis töitä tehdä, ja pelkästään applen softat eivät riitä työntekoon… Ensimmäisestä sukupolvesta kannattaa ainankin pysyä erossa, siillä noin suurilla muutoksilla erilaisia ongelmia on varmasti huomattavan paljon.

No enpä tiedä. Jos day1 on luvattu tarjolla olevan MS:n Office, Adoben CC plus kaikki Applen omat myös Pro-tason softat niin suuremman osan hommistahan noilla hoitaa jo heti ihan samalla tavalla kuin tän hetkisillä intel-mäkeillä.

Tuosta tuli mieleen, että onkohan Applen visiona se sama kun Samsung(?) esitteli pari vuotta sitten eli kännykän liittäminen näyttöön tuo täyden työpöytänäkymän. Jospa vuosien päästä se koko tietokone kulkee mukana taskussa iPhonena tai repussa iPadinä. Luuria tai pädiä räplätessä näytöllä on iOS-näkymä, mutta kun se liitetään Applen näyttöön, siitä tulee täysi MacOS. Tämä konsepti voisi ainakin toimia normaalissa käytössä, kun luurien tehot alkaa olla sitä luokkaa että mielummin esimerkiksi renderöin 4K-videon luurilla kuin tietokoneella. Pro-käyttöön olisi sitten vielä täysiverisiä tehokkaampia Mac Pro -malleja. Tämä visio siis vasta vuosien päästä. Luulen, että nyt nähdään "perinteisiä" tietokoneita vielä.

Mitä ihmettä nyt oikein höpötät?

Niihin tietokoneisiin tulee ihan täysiverinen macos X.

Se ajaa ihan täysiverisiä macos Xlle tehtyjä ohjelmia, myös muiden kuin Applen tekemiä. Ja muutkin firmat kääntelevät jo macos x-softiaan ARM koska XCode 12 on jo ulkona.

Ja niiden arm-prosessorit tulee olemaan riittävän tehokkaita, monen söikeen suorituskyvyssä helposti jopa tehollaampia kuin Intelin työpöytäprossut mikäli Apple vaan laittaa niihib tarpeeksi ytimiä.

Ei.

AMDllä vaan siihen, mitä AMD pystyy, vaikuttaa selvästi AMDn taloudellinen tilanne (esim. nyt joudutaan tekemään työpöydälle noita "chiplet"-ratkaisuita joissa muistiviive on pidempi, kun ei ole varaa/resursseja kehittää erilaisia piilastuja työpöydälle ja palvelimiiin). "Paineen kasvaminen" eli kilpailun kiristyminen siten vaan tarkoittaa sitä, että AMDltä tulee ulos HUONOMPIA prosessoreita.

macOS 11 Big Sur: Everything We Know | MacRumors

http://www.macrumors.com

Jos pitäisi veikata, niin Apple on neuvotellut ainakin pitkän sopimuksen jonka aikana ARM ei voi vetää lisenssiä pois / tiukentaa ehtoja.

Ääh, sori, vääräketju, oikea olisi ollut apple-siirtyy-arm-arkkitehtuuriin-mac-tietokoneissa. siellä kommentoitu että moiset jutut menee roskiin, ei onnistu.

Lisäisin tähän kyllä myös lyhytnäköisen numeroiden tuijottamisen Intelillä. Haluttiin pitää korkeat marginaalit, jotka oisivat johtaneet kilpailijoita (ARM-pohjaisia) huomattavasti kalliimpiin prosessoreihin -> ei olisi ollut ostajia, joten ei jaksettu yrittää kilpailla hinnallakaan. Tätä samaa on ollut useammankin kerran nähtävissä Intelillä, saa nähdä onko opittu mitään.

ARMin ja x86:n muistinsuojaus (jos ne noin suomeksi käännetään) on erilainen ja tästä voi tulla ongelmia käännökseen. x86:n out-of-order varmistaa aina tiettyjen operaatioiden tapahtuvan tietyssä järjestyksessä mitä tulee muistikirjoituksiin ja lukemisiin, mutta ARMissa ei näin vahvaa suojausta ole. Täten ohjelmat, jotka on testattu toimivaksi x86:lla eivät välttämättä toimi oikein ARMilla, vaikka ne kääntyisivätkin. Luin hiljattain oikein hyvin selitetyn artikkelin aiheesta, joten en sen enempää tähän koske: Examining ARM vs X86 Memory Models with Rust, mutta samaa x86:n ajatusta olen itse käyttänyt myös Javassa, jossa JVM huolehtii muistioperaatioiden uudelleen järjestelystä hyvin vastaavalla tavalla kuin x86.

Tuota voi käyttää paljon hyväkseen nimittäin suorituskykyä vaativissa operaatioissa, kun voidaan jättää turhia operaatioita välistä pois. Toinen ongelma tulisi jos ohjelmisto käyttää hyväkseen AVX512 operaatioita, joille ei ole vastaavuuksia ARMilla. Tällöin ne vektorioperaatiot suoritetaankin yhtäkkiä skalaarina ja suorituskyky voi tippua helposti murto-osaan. Tähän ei riitä että ARMissa on vektoriprosessointiin käskykannat, kun tarvitaan tietynlaisia käskyjä jotta tiettyjen operaatioiden suorittaminen onnistuu. Esim. AVX512 koodia ei voi kääntää AVX2:lle ja vain kuvitella että suorituskyky tippuisi suhteessa leveyteen, koska sieltä puuttuu esim. tietyt masking operaatiot joilla voi tehdä myös primitivisiä ehtoja.

Eli mainituissa kuvankäsittely ja äänenkäsittelyohjelmistoissa tällaisia ongelmia voi tulla suorituskyvyn suhteen, koska ARMilla ei ole yksinkertaisesti yhtä kattavaa vektorirajapintaa. Muistioperaatio-ongelmia voi tulla melkein missä tahansa ohjelmassa ja niiden metsästäminen vasta hauskaa onkin.

Hah, sanon minä.

Kummasti se kilpailupaine vaan on joka kerta parantanut tilannetta. Sattumalta vain Intel pystyi tuomaan lisää ytimiä kuluttajakannoille piakkoin Zeninen jälkeen jne. Miksipä mikään firma puristaisi katteita alas tai sijoittaisi tuloksestaan suurimman osan kehitystyöhön (joka ei liity kustannustehokuutteen), jos nykyisillä tuotteita voisi ilman kilpailu-uhkaa myydä mukavalla katteella mailman tappiin? Ei se toki sitä tarkoita, että insinöörit tahallaan suunnittelisi huonoja ratkaisuja, vaan juuri esim. resurssoinnin kautta. Toki joskus myös henkilökohtaisen motivaation.

Toki se on sitten eri kysymys luoko ARM-Macit nyt sitten kuinka paljon kilpailupainetta x86 puolelle, käytönnössähän tuo edellyttäisi, että ARM-ratkaisu olisi niin paljon parempi että Mac-alkaisi vallata sen perusteella merkittävästi markkinaosuutta x86-PC:iltä. Suoria kilpailijoita noista ei oikein vieläkään tule kuin korkeintaan Mac-markkinan sisällä, saa nähdä onko sielläkään pitkään. Epäsuoraa kilpailua on toki jo nyt kun aina joku miettii ostanko Padin vai läppärin, mutta sen vaikutuskin on vastaavasti pienempi.

Nyt taitaa mennä termit "muistinsuojaus" ja "muistin konsistenttiussäännöt" sekaisin. Muistinsuojaus on kyllä ihan samanlainen sivupohjainen virtuaalimuisti, ainoana erona että ARM tukee myös sivukokoja 16 kiB ja 64 kiB joita x86 ei tue (ja Apple todennäkjöisesti kohtelee x86ssa käytettyä 4 kiB sivukokoa toisen luokan kansalaisena, vaikak ARMv8 sitä tukeekin).

Seuraava tekstisi liittyy muistin konsistenttiuteen, ei muistinsuojaukseen:

Joo, mutta tuon x86n muistikonsistanttiussääntöjen tiukkuuden hyödyntäminen "normaaleissa user-tilan softissa" on asia minkä pitäisi olla melko harvinaista; Niiden softien määrä joka näitä hyödyntää pitäisi olla hyvin pieni. Enemmän tätä hyödynnetään käyttiksen/säikeistyskirjaston/tulkin(esim. javascript-python) synkronointiprimitiivien toteutuksessa.

Ja tuo sen tason optimointi, että käytännössä melko varmasti koodari on ensin kuitenkin kirjoittanut koodista "turvallisen" version, jossa kutsutaan jotain järjestelmän synkronointiprimitiivejä, ja sitten vasta jälkikäteen tehnyt tuon optimoinnin, että tajunnut että ne synkronointipriomitiivit voi nimenomaan x86lla ottaa pois juuri tuossa tilanteessa, koska x86n tiukat muistinkonsistenttiussäännöt.

ELi jos se koodi oli alunperin kunnolla kirjoitettu, siellä on jo joku koodi tyyliin

#if (!defined(i386) && !defined(__x64_64))

lock(foo);

#endif

do_something_which_breaks_on_relaxed_memory_ordering();

#if (!defined(i386) && !defined(x64_64))

unlock(foo);

#endif

TAI

#if (defined(i386) || defined(x64_64))

#define myfence

#else

#define myfence something_that_really_implements_fence();

#endif

ja itse koodi

do_first_part_of_something

myfence()

do_second_part_of_something

Jolloin se jo toimii heittämällä ARMilla.

Ongelma tämä on lähinnä binäärikäännökselle, koska se on alunperin käännetty x86lle ja silloin sinne ei ole näitä ARMilla tarvittavia synkronointiprimitiivejä laitettu.

Toki on tietysti myös huonosti kirjoitettua monisäikeistä softaa, jossa ei ole oikeasti mietitty yhtään tuota muistin konsistenttiutta ja testattu vaan se on x86lla sattunut toimimaan tuurilla oikein, ja se on riittänyt softan julkaisuun ja levittämiseen.

Mistähän yksittäisistä operaatiosta tarkkaan ottaen puhut?

ARMv8.2:ssa on SVE2 joka on selvästi kehittyneempi kuin AVX-512.

Mikään todellinen ohjelma ei sisällä pelkästään mitään hardkoodattuja AVX512-intrinsiccejä vaan siellä on aina joku

#ifdef __AVX512__

AVX512_intrinsic_code_here();

#else of __SOME_OTHER_SIMD_EXTENSION__

some_other_intrinsic_code_path_here.

#else

simple_loop__or_manually_unrolled_scalar_here;

#endif

SVE(2)ssa on kehittyneemmät maskaustoiminnot kuin AVX512ssa.

Niin kehittyneet, että melkein minkä tahansa loopin voi kirjoittaa ihan looppina ja kääntäjä pystyy sen vektoroimaan SVE2lla jos loopissa ei vaan ole iteraatioiden välisiä riippuvuuksia; SVE2lla ei ole esim. mitään rajoituksia iteraatiomäärän jaollisuuden suhteen; Looppi voidaan vaan vektoroida ja sinne alkuun lisätään vaan yksi vertailukäsky joka maskaa viimeisellä kierroksella ulos ne iteraatiot, joita ei kuulu suorittaa, eikä haittaa vaikka ne "ylimääräiset linjat" accessoisi muistia jota ei saa accessoida (paitsi mahdollisina sivukanavahyökkäysrajapintoina , se page fault ignorataan jos sen aiheuttaa vektorilinja joka ei ole aktiivinen.

, se page fault ignorataan jos sen aiheuttaa vektorilinja joka ei ole aktiivinen.

Eli on aika hyvät saumat, että siitä täysin "optimoimattomasta looppiversiosta" generoituu oikein tehokasta rinnakkaista SVE2-koodia.

Tietosi ovat vanhentuneita, SVE2 on maailman kehittynein CPUita varten tarkoitettu vektorikäskykanta.

SItä ei toki vielä nykyisin markkinoilla olevissaa puhelimissa olevissa ARM-ytimissä ole, mutta eiköhän sen Apple toteuta omiin "oikeiden tietokoneidensa" ytimiin;

Ensimmäinen SVE:tä tukeva prossu tuli vajaat 2 vuotta sitten (se fujitsun supertietokoneprossu), ja SVE2 korjasi SVEstä ne puutteet, joiden takia sitä ei heti otettu "kännykkäytimiin".

Ei voi missä tahansa softassa ; Muistin konsistenttius voi olla ongelma ainoastaan monella säikeellä, saman säikeen sisällä käytettynä muistioperaatiot pysyvät aina tiukasti järjestyksssä ARMillakin.

Vastaus siirretty säikeeseen, johon tällaiset typeryydet kuuluu:

Virallinen: AMD vs Intel keskustelu- ja väittelyketju

bbs.io-tech.fi

Kiitos nimittelystä, mutta olen niin typerä etten ymmärrä miten Applen ARM prossujen vaikutus tai sen puuten x86-prossuihin liittyy AMD vs. Intel väittelyyn, ainakaan sen enempää kuin teknisempi keskustelu suoritinarkkitehtuurien eroista. Zenin vaikutus Intelin hinnoitteluun ja tarjontaan nyt oli vaan yksi esimerkki siitä että kilpailulla on merkitystä (yhtä hyvin se olisi voinut olla Lidlin vaikutus päivittäistavarakauppaan tai Uberin ja taksilain vaikutus tilausappeihin), joten en nyt ala sen takia kirjoittelemaan offtopic Intel vs. AMD ketjuun. Jos tuota aihealuetta haluaa laajentaa niin se olisi sitten kapitalismi vs. sosialismi ketju.

Tuotteilla, myös prossuilla, on enemmän kuin yksi ominaisuus, eikä niitä kehitetä tynnyrissä välittämättä markkinoista ja kilpailusta vaan juurikin niiden ehdoista. Joihinkin ominaisuuksiin voidaan vaikuttaa nopeasti (hinnoittelu, eri ominaisuuksien tarjonta eri hintaluokassa) ja joihinkin vaaditaan sitten huomattavasti pidempi aika. Mutta edelleenkään se kehitystyö ei tapahdu tyhjiössä vakisummalla rahaa käytettäväksi vakiojaolla tai "mitä nyt sattuu tulemaan ulos" periaatteella eri ominaisuuksien välillä. Minusta on aika ylimielistä ohittaa typeryytenä joko aihealue siitä miten tämä vaikuttaa kilpailuun x86 tuotteiden kanssa.

Sitä en epäile yhtään, että sinä tiedät prossuarkitehtuureista allekirjoittanutta enemmän, mutta jos sen perusteella esitetä että koko ajastus ARM vs. x86 arkkitehtuurien välillä syntyvästi kilpailutilanteesta on absurdi niin selitä toki miksi. Sen uskallan kuitenkin omalla tietämyksellänikin sanoa, että tuotekehitys ei tosiaankaan tapahdu vakiovauhdilla tyhjiössä.

Detaljit geekbench-ajosta näkee kun pistää .gb(versio) päätteen:

Eli valkkasit jostain syystä 6,1Ghz:n kelloilla ajetun GB5-tuloksen Inteliltä. Normaali 5GHz:n kelloilla ajettu tulos on hyvin lähellä Iphone11:sta tulosta, eli jo nykyisen Applen coren PPC on noin tuplat Skylakeen.

Eiköhän nyt riitä jo noista prossuarkkitehtuureista puhuminen näytönohjainketjussa, @hkultala jo kerran yritti ohjata jatkot parempaan paikkaan.

Applella on aika sairaan hyvää rautaa, näytönohjainpuoleltakin jotkin laskelmat antavat samansuuruisia performance/watt tuloksia vrt. Intel/AMD/nvidia – noita vaan on vähän vaikeampi verrata ja hahmottaa. Mutta prossuarkkitehtuuria jos verrataan niin laskuihin tulee pientä virhettä jos laskuissa käytetyn kellotaajuudet on pari gigahertziä pielessä

Eli jos jostain ei tarvii olla huolissaan niin ARMit maceissä eivät tule olemaan hitaita – näytönohjainpuoleltakin Applelta voi tulla liki yhtä kovaa rautaa ulos.

Tämä onkin mielenkiintoinen pointti. Olisihan se aika hienoa kun päästäisiin lopultakin siihen, että vetäset sen puhelimen taskusta, asetat telineeseen ja kaikki hommat jatkuu siitä. Näppäimistö ja näyttö vain tarvitaan. Ennen oli kannettavassakin sellainen integroitu levyasema, olisiko siinä jatkossa integroitu puhelintelakka? Reikä sivulla johon puhelin asetetaan. Tai jotain.

Noh, tuo ajatuksena kuulostaa kuitenkin ihan luonnolliselta askeleelta, vaikka ei varmasti kovin pian ja ei kovin tehoja vielä. Mutta jotenkin kuulostaisi yleisesti järkevältä suunnalta. Ei ole pahemmin visiota Jobsin jälkeen löytynyt vetää tuollaisia uusia tuotekategorioita Applen suunnalta, mutta olisiko taustalla joku ajatus kuitenkin. Vaiko vain halu kontrolloida enemmän koko ekosysteemiä?

En usko, että huonoa rautaa haluavat ulos laittaa. Mutta uskon kyllä, että hetki menee kun viilaavat raudan kuntoon ensimmäisten versioiden kanssa ja että softapuoli tulee perässä. Hyötykäytössähän softaa varmasti opitmoidaankin Apple ARM:lle kun aika tulee, pelipuoli ja pienemät softat voi kyllä jäädä sitten enemmänkin perästä jos yhtään erikoisempaa kääntämistä alkaa vaatia. 32 bittisen tuen poistaminen jo oli melko ikävä esitapaus. Harvinaisen huonoa aikaa hommat Mac nyt kun Intelit vanhenee parissa vuodessa ja ARMit tuloillaan ja epäselvää mitä näistä vielä kehittyy..

Huhujen pohjalta Applella olisi jo tälläistä toiminnetta testailtu, eli luurin voisi kytkeä näyttöön/telakkaan jolloin sillä ajettaisiin macOS:ää tai jotain siitä hieman riisuttua versiota, joka kuitenkin ajasi niitä macOS:n ARM-sovelluksia.

Samsungilla ollut Dex jo oliko Galaxy S8:sta lähtien, googlen huhuttiin tuovan vastaavaa jo ihan natiivina Androidiin (koodi taitaa löytyä valmiina jo Android 10:ssä, mutta ominaisuutta ei ole tuotu "tuotantoon").

Monessa paikassa on ollut pari vuotta havaittavissa selvää epäuskoa Applen piirien suorituskyvystä – ne on niin sairaan hyviä että niitä ei tahdota uskoa sitten millään. Applen kehitysalustana on Ipad Pro:n vuonna 2018 julkaistuun A12Z-piirin perustuva laite, eli prosessoriarkkitehtuuri siinä on pykälän vanhempi kuin Iphone11:ssa ja esimerkiksi maksimikellotaajuus vain 2,5Ghz.. Apple kieltää kehityslaitteiston käytön testitulosten julkaisuun mutta samantien kun ko. purkit jaettiin tuloksetkin tuli, eli x86-versio Geekbench5:stä ajettuna tuolla pari vuotta vanhalla Ipad pron piirillä Applen x86-emulaattorin läpi antaa single-core tulokseksi parhaimmillaan noin 850. Eli pari vuotta vanha Ipadin prossu ajamassa emuloitua x86-binääriä on jo ihan kilpailukykyinen Intelin mobiiliprossujen kanssa, ei ihan huippumallit saavat sen reilun tuhat pistettä, 9900K vakiona sen ~1350. Tää on vähän ennenkuulumatonta, ei oikeastaan ole edes pelkoa siitä että vanhat emuloidut binäärit toimisivat hitaasti, ainakin suurin osa niistä saadaan toimimaan ihan vastaavalla nopeudella kuin nopeimmilla Intel-mäkeilläkin.

Täsmälleen saman piirin laittamalla isoon läppäriin tai työpöytäkoneeseen kunnon jäähyn alle tarjoaa heti vähintään kymmeniä prosentteja lisää kelloja ja täten suorituskykyä, jos prosessi ei luo kovaa seinää kelloille. Saman arkkitehtuuriin perustuva pirii jossa on enemmän välimuistia ja joka on isommat kellot mahdollistavalla prosessilla tehty on sitten vielä selkeämmin edellä.

Toki tuollainen dokkaus voi useimpiin käyttötilanteisiin olla ihan käypä systeemi, mutta jos vähänkään on suorituskykykriittinen tilanne, niin korkean kulutuksen laitteet vievät kuin pässiä narussa maailman tappiin asti.

Sanoinkin että "lähes kaikki", joista oikeasti poikkeuksia on U -mallin prossut. AMD:n tdp on kutakuinkin intelin U -malleja vastaava, mutta suorituskyky taasen paljon parempaa läppäri segmentissä. Performance segmentissä Intelillä ei ole mitään jakoa läppäri rintamalla.

Tätä tilannetta onkin jatkunut jo historialliset pari kuukautta. Sitä ennen mentiin n. 20v kun Intelillä oli suvereenisti paremmat mobiilipiirit.

Oli jo aikakin kehittyä sillä rintamalla. Ilmeisesti Applekin on kyllästynyt Intelin jämähtäneeseen arkkitehtuuriin, jolla paremman puutteessa rahastettiin ihmisiä lähes vuosikymmen.

U-sarjasta on sekä Skylake-johdannaisia, mihin tuo väittämästi voikin päteä, että Ice Lakeja, mitkä on ihan eri asia. Ja tosiaan tässä kesän lopulla tulossa olevat Tiger Laket näyttäisivät juoksevan kauas edelle ainakin ennakkotesteissä.

Niin, jää nähtäväksi throttlaako ne (ennakkotestit ajetaan yleensä ihanneolosuhteissa yleisön ihmeteltäväksi), eli pitääkö tdp paikkansa loadissa. Tässä tilanteessa parasta on se, että on ainakin kilpailua joka pakottaa yrittämään enemmän.

Kunhan nuo hinnatkin tippuisi…

Mistähän "jämähtäneestä arkkitehtuurista" nyt oikein puhut? Kertoisitko lisää?

Ei taida ihan heti loppua Applelta rahat kassassa on melkein 200 miljardia euroa rahaa. Tuolla rahamäärällä voisi esim. pitää Suomen valtion toiminnassa neljä vuotta ja lopettaa kaikkien valtiolle menevien verojen keräämisen samaksi ajaksi ilmoittaa vaan, että Apple maksaa seurvat neljävuotta kaikkien Suomalaisten verot.

Apple now has $192.8 billion in cash on hand, down from last quarter

http://www.cnbc.com

Applen omien prossujen kehitykseen verrattuna noi on aika paikallaan seisonu.

Jep Intelin prossuissa on ollut valtavasti bugeja viimeisimmissä arkkitehtuureissa ja kehitys on jämähtänyt samaan viivanleveyteen. Kilpailijat menevät ohi. Intelin on käytännössä vain uudelleen brändännyt samaa arkkitehtuuria vuodesta toiseen pienin muutoksin. Apple on isona firmana kyllästynyt Intelin hitauteen ja ongelmiin. Myös Nokian 5G verkkokehitys on kusessa Intelin kustua Reefshark piirien kehityksen, joten Apple ei ole ainoa jolla on alkanut käämit palaa Inteliin.

Eikös se Jobs aikoinaan osoittanut, että aito mahdollisuus on mahdottoman mahdollistamisessa?

Meinaan, että ei sitä iPhonea ennen ollut kunnolisia älypuhelimia ja moni taisi niihin aika vähätellen suhtautua. Sama taisi vähän pienemmässä kaavassa olla iPadin kanssa. En ole henkilökohtaisesti koskaan omistanut kumpaakaan näistä laitteista, mutta nähdäkseni jos haluaisi tehdä oikeasti repäisevää ja isoa niin se löytyisi sieltä mahdottoman ja mahdollisen välimaastosta. Ei siitä saman vanhaan tuunaamisesta "koska muu ei voi onnistua/toimia".

Älypuhelin oli täysin ennustettava kehitys jo 90-luvun lopulla, apple "vain" teki ensimmäisen sulavasti toimivan sellaisen.

Ja toisin kuin älypuhelimen kohdalla niin tämmöisessä telineessä ei ole näytön kaltaista muna-kana-ongelmaa (miksi kukaan olisi ennen iPhonea tehnyt isoja ja tarkkoja kosketusnäyttöjä kun ei niitä kukaan ostanut, jolloin oli mahdoton suunnitella laite sellaisen ympärille kun niitä ei ollut). Telineisiin on kaikki liitännät ja rajapinnat jo olemassa, ihan pelkkä thunderbolt liitäntä puhelimen päässä riittää, loput on softatukea.

Kuten sanoin niin kevyeen käyttöön tuollainen dock-viritelmä tulee olemaan hyvä, mutta fysiikan lait tulee vastaan, jos puhelin edes docking modessa laitetaan viemään kymmeniä watteja. Akku ei tykkää lämmöstä (kestosta ei niin väliä, dock voi olla seinässä kiinni), pitää tehdä matkapuhelinkäyttöön täysin ylimitoitettu virransyöttö ja piirikään ei ole sitten täysin optimoitu mobiilikäyttöön. Ja silti se sama piiri kellotettuna viemään 100W, joka on isossa läppärissä mahdollinen jäähdytysteho, on nopeampi.

Johan Intelin johtokin on todennut että 10nm prossuilta ei kannata odottaa mitään suuria saavutuksia. Vielä vähän epämääräiset vuotaneet GB5 tulokset saavat 28W:n Tigerlaken single-core suorituskyvyn olemaan suurinpiirtein saman kuin A14-piirisen Iphonen(~1700). Intelin "mobiiliprosessori":ksi tietysti parannus mutta verrattuna Applen piireihin tulosta ei voi pitää kovin kaksisena. Geekbench on sangen kevyt testi lyhytkestoisena, Tigerlaken tulosten hyvyyden näkee vasta kun ajetaan vähän raskaampaa testiä, Icelakehan on energiatehokkuuden suhteen huononnus verrattuna 14nm piireihin, Tigerlaken pitää olla sangen suuri parannus jos aikoo olla likimainkaan kilpailukykyinen AMD:n ja muiden kilpailijoiden tuotteisiin nähden. Single-core suorituskyky tolkuttomalla tehonkulutuksella on ollut Icelakenkin kilpailukykyisin ominaisuus – eikä Tigerlake näytä oleellisesti tilannetta muuttavan.