Intel ja Micron kehittivät yhteistyönä 3D XPoint -muistit, joiden oli tarkoitus täyttää DRAM-muistien ja SSD-asemien välinen ammottava aukko uudella musitikerroksella. 3D XPoint muistit tunnetaan parhaiten Intel Optane -nimestä, vaikka Micronkin sai ainakin yhden aseman markkinoille asti.

Intel on nyt ilmoittanut lopettavansa koko Optane-sarjansa lopullisesti, mikä tarkoittaa samalla 3D XPoint -teknologian hautajaisia. Intel ja Micron lopettivat aiemmin yhteistyönsä 3D XPointin parissa, mutta kumpikin sai oikeuden jatkokehittää muisteja omien tarpeittensa mukaan. Micron ilmoitti lopettavansa 3D XPointin kehityksen omalta osaltaan jo viime vuoden keväänä.

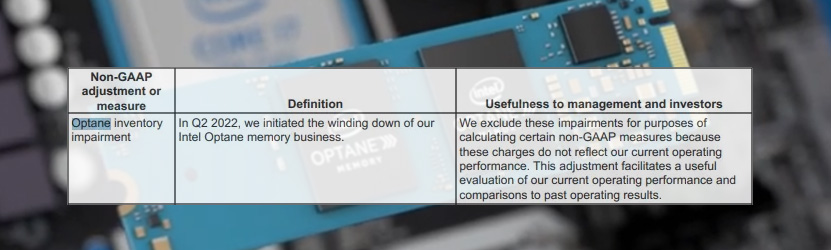

Tom’s Hardwaren Inteliltä saaman lausunnon mukaan IDM 2.0 -strategiaan kuuluu yhtiön portfolion järkeistäminen, eli käytännössä kannattamattomien yksiköiden eliminointi mahdollisuuksien mukaan. Yhtiö lupaa kuitenkin huolehtia nykyisten Optane-asiakkaittensa tarpeista siirtymäkaudella muihin muisteihin.

Intelin Optane-asemat eivät saavuttaneet ikinä merkittävää suosiota kuluttajapuolella ja suurin osa menekistä olikin esiasennettujen välimuistilevyjen saralla. Yrityspuolella Optanelle oli enemmänkin kysyntää, mutta Intelin tuore päätös kertoo selvää kieltä sen kannattavuudesta.

Lähde: Tom’s Hardware

Eikös optanen tarkoitus ollut toimia cachena rammin ja esim ssd:n tai normaalin hdd:n välillä, en koskaan ymmärtänyt mitä etua tuolla oikein saatiin verrattuna esim perus ssd cache zfs tiedostojärjestelmässä. Taas yksi proprietaryteknologia lisää.

Taisin nähdä tuota muutamassa läppärissä ainoinaan välimuistina normi HDD kanssa, mutta siinä en nähnyt pointtia.

Optane oli ideana ihan ok mutta intelin hinnoittelu tuhosi sen.

Ongelma oli se, ettei ollut softaa joka osasi hyödyntää sitä ja sen takia sitä myytiin nopeana ssd:nä, joka on käyttökohde joka heittää sen parhaat ominaisuudet viemäriin ja koittaa matkia ssd:eiden paskoja puolia.

Intelin olisi pitänyt kirjoittaa pari storageengineä sille esim. MariaDB:lle ja PostgreSQL:lle + työntää massia oraclelle / Ms:lle jotta ne olisivat kirjoittaneet erikoistuen omiin tuotteisiinsa.

Mutta se on nyt myöhäistä.

Projektit oli varmaan kaikissa noissa, mutta ne eivät edenneet, koska ei ollut tarvetta.

Kustannustehokkaissa ratkaisuissa järjestelmät on viety pilveen, jossa NVRAMille ei ole tukea. Eikä ole tulossa, koska ei ole tarpeeksi tarvetta.

Suorituskykyisissä ei-pilviratkaisuissa eheyden pystyy hoitamaan lähes samoilla viiveillä muilla tavoin. Muistinvaraisia storage-engineitä on useita, joiden eheys voidaan varmistaa muilla keinoin (RDMA, erilaiset rinnakkaiset saman operaation ajot, yms.). Tämä sitten maksaa rahaa eikä toimi pilvessä. Lisäksi lukuoperaatioissa RAMissa toimiva storage-engine on nopeampi.

Eli loppupeleissä 3Dxpoint ratkaisi ongelmaa, jota ei enää ollut tuotteen oikeasti tullessa markkinoille (joka oli NVRAMin osalta aivan liian myöhään).

Olin itsekin väärässä tämän suhteen, minulla oli kova usko tähän(kin) teknologiaan, mutta pieleen meni tämäkin arvaus.

Suurin menetetty mahdollisuus on mobiilimaailma. Virransäästön takia olisi ollut tosi hienoa, jos vaikka puhelimessa oleva semiaktiivinen data makaisi valmiina virrattomassa muistissa, jota sitten heräteltäisiin ainoastaan tarpeen mukaan. Tai horroksesta heräämisen nopeus.

Toki ihan kylmäboottaustakin saisi vielä optimoitua. Ei kokonaan poista tarvetta tämän tyyliseltä muistilta, mutta jos vaikka boottaisi 1-2 sekunnissa, se tekisi jo muunlaisista syvistä lepotiloista paljon kyseenalaisempia.

Esim. itse olen RPi-tyylisen kehityslaudan laittanut boottaamaan noin sekunnissa, vaikka kyseessä on hidas ARMv7, hidas levy ja kuitenkin ajurituesta ei ole karsittu pois juuri mitään – idea on vaan viivästyttää raudan alustamista. Vastaavasti Intelin 10v vanha HTPC buuttaa käyttiksen UEFIn valikosta 5 sekunnissa ja UEFI tuossa koneessa noin 2-3 sekunnissa. Näissä ei ollut edes LTO-optimoitua kerneliä joka lienee osassa Androideista ihan vakio. Oma uudehko Android kuitenkin boottaa 33 sekuntia PIN-koodin kyselyruutuun. Vanhempi Android kesti lähes minuutin.

Omalla nurkalla teollisuutta olisi ollut käyttöä mutta Intel ei koskaan tarjonnut piirejä sulautettuihin ratkaisuihin. Luulisi että ajoneuvopuoli olisi ollut ideaali markkina, samoin koneoppimisen sovellukset tuotantolaitteissa. Ajoneuvopuoli varmaan kaatui single vendor ja hinnoittelu kysymyksiin. Sääli. MRAM tai FeRAM ei oikein ole vaihtoehto johtuen piirien pienestä kapasiteetista.

PC puolella ei, mutta teollisuussovelluksissa paljonkin koska olemme edelleen FLASH teknologian armoilla eikä vaihtoehtoja ole. Perus EFS kestää muutaman täyden kirjoituksen kun Optane olisi kestänyt tuhansia. Samoin Optane ei kärsi kylmänä olemisesta samoin kuin FLASH.

Muistaakseni Optane julkaistiin hieman ennen SSD-tekniikkaa, ei uskottu että paria kymmentä gigaa enempää ihmiset hankkisi kohtuullisen kalliita piirejä. Mutta äkkiä ne SSD:t halpeni ja myös nopeutui, ja Optane kävi lopulta täysin turhaksi.

In memory taulu tietokannassa on nopea, säästää toki rahaa jos on jokin halvempi tekniikka mihin laittaa jokin muutaman kymmenen gigan kokoinen taulu, mikä olisi kuitenkin kohtuullisen nopea. Nyt kun saan 50 teraa yhtenäistä ssd-tilaa ja 64 Gt muistia on kohtalaisen halpaa, ei kannata enää mikään kolmas teknologia tietokannan optimoinnissa. Ja onhan nuo palvelimienkin emolevyt/prosessorit kehittyneet, nyt saa teran verran rammia aika perus myllyyn.

Mitä nopeampi on väylä, sitä enemmän niistä hakuajoista tulee pullonkaula, ja sitä suurempi on käytännön nopeusero NAND-flashin ja xPointib välillä.

Muistat TÄYSIN väärin. SSD-levyjä on ollut >10 vuotta, Optane tuli markkinoille 20127.

Eikä ole olemassa edes mitään "SSD-tekniikkaa". SSD tarkoittaa massamuistia, jossa ei ole liikkuvia/pyöriviä osia, sen voi toteuttaa hyvin monella eri tekniikalla.

Ihan samalla tavalla se xpoint olisi toiminut pilvessä kuin omassa datacenterissä. Jos vaan olisi ollut kuormia / softaa mitä ajaa ja kysyntää, niin azuresta ja AWS:stä olisi kyllä saanut tiettyä iops-lupausta kovemmissa saas-kantojen suorituskykyluokissa xpointilla varustettuja instansseja.

Ja vastaavasti puhtaita vm-instanssejakin olisi kyllä saanut pilvestä jos vaan kysyntää olisi ollut. Mutta miksi olisi, kun ei ole softaa joka hyötyy xpointista?

Toinen merkittävä tekijä on kyllä nosql:ien yleistyminen. Jengi tajusi, että oikeasti acid:ia tarvitaan tosi vähän ja suurin osa asioista on toisistaan riippumattomia -> kun siirryttiin pois puhtaasti sql-backendeistä, niin pullonkaulat siirtyivät muualle ja byte addressable low latency non-volatile optanen ilmeisin käyttökohde muuttui marginaalisemmaksi.

Muistelin optanea paljon vanhemmaksi, noin 10 vuotta ollut uutisissa, 2012 ostettiin vielä pyöriviä kiekkoja. Lopulta 2015 julkaistu jotain valmista Inteliltä, ja silloin oli jo esim. Samsung 860 Evo markkinoilla. Kirjoitin tuosta joskus Muropaketin aikana ennen IO-Techia niin ei voi enää etsiä milloin. 4k randomeissa oli kuitenkin moninkertainen IOPS verrattuna SSD-lättyihin. Ikinä tuota ei tullut hankittua, koska kuluttajatekniikan kehitys riitti minulle.

Taidetaan edelleen kuitenkin käyttää aika paljon perus sql:ää. AWS:n puolella ongelma on sehkä se ettei alustalla ole storage tyyppiä joka vastaisi optanea. Siellähän on siis EBS joka toimii verkon yli, EFS joka vastaa Nas:ia. Lisäksi EBS:stä taisi olla ssd versio joka on suoraan kiinni instanssissa, mutta se tyhjennetään joka restartin yhteydessä (johtuen siitä että restartissa se fyysinen kone yleensä vaihtuu). AWS:n aurora relaatio tietokantaki on toteutetttu siten että se kirjoittaa verkkolevylle ja usealle eri datasentterille samalla regioonalla. Veikkaan että tuon muuttaminen sellaiseksi että optanesta sais riittävästi hyötyä hintaan nähden olis sen verran iso homma ettei Amazon katsonut sitä järkeväksi ja toisaalta perus rds:n sen implementointi saattaisi viedä asiakkaita sen omalta aurora toteutukselta. Muut pilvitarjoajat taitaa tarjota omaa custom relaatio kantaa joka toimii vähän samalla tavalla, niin niilläkään ei liene ihan hirveän suurta innostusta lähteä virittään optanelle tukea, Varsinkin kun siinä olisi yhden toimittajan loukussa.

2015 Intel on tainnut julkaista ihan normaaleita NAND-flashiin perustuvia asemia, joilla ei ole mitään tekemistä Optanen kanssa.

2015 on tainnut myös tulla Inteliltä ensimmäinen "olemme lähivuosina tekemässä jotain ihan uutta"-julkilausuma Optaneen liittyen. Tällä ei ole mitään tekemistä valmiiden tuotteiden kanssa.

Ja Optane-levyt on ssd-levyjä. Lauseessa jossa verrataan Optanea "SSDhen" ei ole mitään järkeä.

Sama juttu. Osittain tosin siksi että pullonkaula tuntuu olevan muualla kuin tallennusmediassa. Jos Ramdiskillä ei saa juurikaan parempaa suorituskykyä kuin perus SSD:llä esim pelien latausajoissa, niin paljoko optanesta voi oikeasti olla iloa? En tiedä onko kukaan tutkinut missä se pullonkaula on, mutta Intelin mukaan osa syy miksi ero Nand:n ei ole kovin suuri on pcie:n tuoma latenssi. Odotin enemmän että intel olisi tuonut oman väylän (serveri/workstation) emoilleen jossa olisi ollut pienempi latenssi kuin että lopettaisivat koko optanen valmistuksen. Vähän jäi sellanen fiilis ettei tässä nyt käännetty ihan joka kiveä että optanelle oltaisiin saatu oma markkina segmentti. Edelleen on ja uskon että aina tulee olemaan sellasta dataa jota ei voi laittaa pilveen niin tälle kapeelle segmentille olisi mielestäni kannattanut lähteä kehittämään omaa tuotetta jossa tuo kirjoituskestävyys olisi ollut kova myyntivaltti. Vaikea sanoa paljonko tuota lantessia saa sitten painettua alas, mutta sehän oli aikanaan suurin myyntivaltti SSD:lle verrattuna HDD:n. Jos optane saisi samanlaisen harppauksen niin high end markkinoilla vois hyvinkin mennä kaupaksi.

Intelin ei olisi koskaan pitänyt edes tuoda Optanea markkinoille M.2 liitäntäisenä ssd:nä. Se selkeästi pilasi tekniikan maineen.