NVIDIA kertoi DLSS-skaalausteknologian julkaisussa myös erillisestä DLSS 2X -tilasta, joka toimisi natiiviresoluutiolla uutena reunojenpehmennystapana. Sen jälkeen teknologiasta ei olekaan juuri kuultu yhtiön linjattua, että DLSS:ää saisi käyttää vain tilanteissa, joissa se parantaa suorituskykyä.

NVIDIA aikoo ilmeisesti pitää linjauksestaan kiinni jatkossakin, sillä joko DLSS 2X -tilan DLSS 2.x -variantti tai ainakin hyvin samankaltainen teknologia on tulossa markkinoille DLAA- eli Deep Learning Anti-Aliasing -nimellä.

Teknologian tarkemmasta toteutuksesta ei tiedetä vielä muuta, kuin että se perustuu DLSS-teknologiaan ja tarjoaa pelkän reunojenpehmennyksen ilman kuvan skaalaamista korkeammalle resoluutiolle. DLAA:n ensimmäinen versio on jo käytössä Elder Scrolls Online -pelin testipalvelimilla, mutta laatuvertailuja siitä ei ole vielä tullut saataville. Pelin kehittäjä ZeniMax Onlinen edustaja Rich Lambert kehuu laatua kuitenkin paremmaksi kuin ESO:n nykyiset reunojenpehmennysmetodit ja yhtiön grafiikkapuolen johtaja Alex Tardiff toteaa puolestaan Twitterissä pelin olevan otollinen testialustaksi, koska pelin suorituskyky on riittävä ilman skaalaustakin. DLAA vaatii luonnollisesti myös veronsa, mutta suorituskykyvertailujakaan ei ole vielä saatavilla.

Lähteet: NVIDIA, Alex Tardiff @ Twitter

Miten tämä liittyy nyt yhtään mihinkään? Eikös uutisessa nimenomaan puhuttu reunanpehmennys teknologiasta joka vie sitä potkua sen antamisen sijaan?

Onhan tuo aasinsilta ohut tai jopa olematon, mutta tuohon 1070-tuen puuttumiseen viitaten tämä näyttää Nvidian osalta pikkasen taas ajattelemattomalta jos tulee olemaan samalla tavalla sidottu kuin dlss. Niin kauan kuin ovat markkinajohtajia niin toki tuo lisäarvoa heidän uudempien korttien käyttäjille, mutta sitä mukaa kun amd ja intel pääsevät ’kärryille’ niin alkaa kääntyä Nvidiaa vastaan jos tuovat teknologioita vain ja ainoastaan omille uusimmille sukupolvilleen. Vrt. Amd fsr-teknologia joka on huomattavasti universaalimpi ja kehittyessään voi saada Nvidian taktiikan näyttämään aika kyseenalaiselta. Tällä hetkellä korttien saatavuus ja hinnat ovat semmoset, että noita 1070/1080-tason kortteja on kuitenkin vielä aika rankasti käytössä kun ei uudempia saa tai hinnat estävät päivityksen.

Tätähän tässä on odotettu koko ajan julkkarista lähtien!

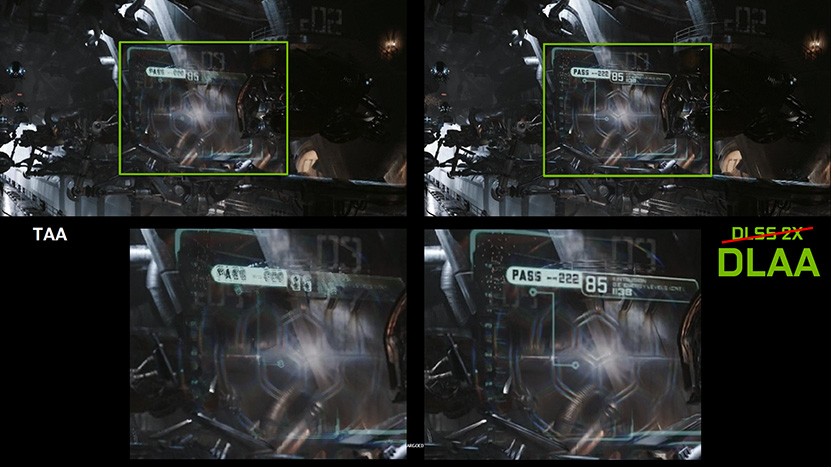

Tuo kuva on vuoden 2018 DLSS 2X demosta. DLAA käyttää eri tekniikkaa, eli uutiskuva ei tosiaan havainnollista DLAA:n kuvanlaatua.

Tuosta kuvaparista ei voi tällaista johtopäätöstä tehdä. DLSS 2X ei ole ottanut tuota TAA kuvaa ja parantanut sitä, vaan molemmat kuvat on muodostettu lähdekuvasta, joka ei ole nähtävänämme.

Hienointa näissä teknologioissa on se, että ne saattavat olla helposti yhteensopivia sitten vanhojenkin sovellusten kanssa. Emulaattoreihin amd:n fsr on tuonut hurjan boostin. Paremmat aliasingit vanhoihin pikseli 3d peleihin tekisivät niistä erittäin hienoja kokemuksia. Toivottavasti eivät lukitse softatasolle toimintaa kuten dlss.

Toisaalta, vuoden-parin päästä näitä tekniikoita (varmaan myös AMD:ltä ja Inteliltä tulee vastaavia) tungetaan sitten kaikkiin uutuuspeleihin, jolloin aikaisemmatkaan huippunäytönohjaimet eivät enää ’riittävällä’ tasolla suoriudu uusista tempuista.

Eli jos halaa käyttää parasta mahdolista laatua, on koko ajan pakko ostaa uudempia ja tehokkaampia näytönohjaimia. Jotka sitten maksavat aina vain enemmän ja enemmän.

Tätähän se kehitys on – se kun voidaan tulkita joko laadullisena parantamisena tai suunniteltuna vanhentamisena.

Keskittyisivät pelintekijän mieluummin vielä enemmän sen pelisisällön laadun ja peli-ideoiden parantamiseen kuin uusimpien huulikiille-efektien (a.k.a. ray-tracing) tuomiseen.

Ei DLSS:ää mihinkään ole lukittu. Sen toteutus vaatii erikseen peliin rakennettavan tuen (yksinkertaisimmillaan plugin jos käytössä ue tai unity, muuten isompi homma) ja pelienginen on tuettava tiettyjä ominaisuuksia että se ylipäätään voi toimia.

Kaikella todennäköisyydellä täysin sama pätee DLAA:han.

Jos kyseessä olisi jotenkin vastaava tekniikka niin tälläiset vertailut kävisi järkeen, mutta kun yhteistä on ainoastaan se että skaalataan kuvaa ylöspäin ja kaikki muu toimii täysin eri periaatteella niin ei ole oikein hyödyllistä sanoa että makkarastakin tulisi hyvä smoothie jos se olisi banaani.

DLSS:n ja DLAA:n vastineet tekniikkana on esim. UE5:n TSR ja TAA joihin voi hyvinkin toteutuksia ja laatua verrata. Detaljina voi todeta että myös Remedyn Quantum Break sisältää enginen oman temporaalisen skaalaimen. Ei siis liene yllättävää että Control oli yksi ensimmäisiä DLSS-pelejä.

FSR:ää voi taas vertailla esim NVIDIAn ajureiden skaalaus+sharpening asetuksiin tai joidenkin pelien omiin skaalaimiin (jotka se taitaa piestä usein ihan selvästi).

DLSS:n kohdalla on jo myöhäistä kitistä "suljettua" ympäristöä kun isot enginet sekä lukuisat muut developperit on täysillä (NVIDIAn porkkanalla tai ilman) mukana sen levittämisessä. Itse asiassa tilanne on jo ilmeisesti sellainen että jos indie-nyrkkipaja laittaa DLSS:n peliinsä (tarvitsi se sitä tai ei) niin siitä saa devausajan kustannukset takaisin kun NVIDIA boostaa peliä sosiaalisessa mediassaan suurelle yleisölle pyytämättäkin.

Intel onnistuessaan tuo markkinoille kilpailijan DLSS:n rinnalle kun sielläkin puuhastellaan samojen tekniikoiden kanssa, mutta vaikka näin kävisi niin mitään FSR:ää sinne mahdollisen saman rajapinnan taakse ei voi laittaa eli AMD:n pitäisi tulla muiden "tasolle" jos halutaan että kaikki on samalla viivalla kilpailemassa puhtaasti saman ominaisuuden toteutuksen kautta.

Mitään tarvetta tälläiselle ei tosin ole kun pelit pyörii ilmankin ja kyse on lähinnä lisäominaisuuksista joilla mahdollistetaan näyttävämmät pelit. Ja päinvastoin kun yleisesti höpötetään, näillä nimenomaan jatketaan niiden alempien korttien (missä tuki on) eloa kun voi vaikka näyttöpäivityksen jälkeenkin käyttää samaa korttia kunhan laittaa skaalaimet päälle.

Tämä on totta, miksei olisi kun on ollut aina ennenkin. Tosin paras mahdollinen laatu ei ole missään nimessä järkevä tavoite koska peleissä on asetuksia joiden käyttamisessä ei nyt vaan ole mitään järkeä jos ei tosiaan halua vain parasta laatua ruudunpäivityksestä välittämättä.

Se mikä näissä keskusteluissa jää aina sopivasti sanomatta on että vaikka ULTRAMEGA asetuksilla saa 3080:nkin ryömimään niin kyllä joku 1070 rullaa pelejä ihan hyvin jos vaan asetukset ja resoluutio on kohdallaan. Nykypelit ja moottorit skaalautuu kyllä alaspäin ja joskus laadullinen ero ei edes ole kovin suuri.

Eikö tämän tekniikan esiversio toiminut ihan vain Cuda ytimillä? Nvidia ei jatkanut sen kehitystä, koska tärkeämpää saada ihmiset ostamaan ylihintaisia RTX-kortteja?

Eiköhän se syy ole ihan siinä, että valtaosassa pelejä ne tensorcoret idlailee tekemättä mitään. Jos sitten niitä saadaan hyödynnettyä niin siitä on vain iloa.

Kun taas jos laskentaa tehtäisiin cuda-ytimillä, olisi se sama laskentateho jostain muualta pois.

Ainakin nykyisissä dlss toteutuksissa se skaalaus tehdään eri aikaan kuin mitä muu rendaus pipeline, ts. ne tensorytimet ei näe päällekkäistä käyttöä cudaytimien kanssa. Tiedä sitten että olisko nvidian mahdollista saada tuo onnistumaan paremminkin?

Siis vaikka se skaalaus tehtäisiin tensoriytimillä sille yksittäiselle framelle eri aikaan (eli käytännössä skaalaus muun renderöinnin jälkeen), niin ei ne Cuda-ytimet nyt tietääkseni jää sitä odottelemaan vaan ne prosessoi siinä vaiheessa jo seuraavaa framea. Tai jos näin ei ole, niin näkisin mielelläni lähteen missä Nvidia toteaa näin olevan.

Näkisin mielelläni myös lähteen jossa nvidia toteaa sen mitä itse spekuloit tapahtuvan.

Ongelma tossa on se, että skaalauksen jälkeen tehdään vielä läjä post prosessointia mm. niillä cudaytimillä ja siinä välissä uuden framen valmistelu olisi luultavasti haastavaa ja vaatisi isoja muutoksia pelimoottorin rakenteeseen. Se DLSS hommeli tapahtuu pipelinen ~puolivälissä, eikä lopussa kuten ehkä kuvittelet.

Siis sinä väitit että se tapahtuu eri aikaan, eikä tensori- ja cuda-ytimet näe päällekkäistä käyttöä. Tuo kuulostaisi ihan todella järjettömältä resurssien haaskaukselta, että cuda-ytimet jäisi odottelemaan sitä että tensori-ytimet saa laskentansa valmiiksi. Kaipaan tälle lähdettä, kun sen faktana keskustelussa esitit.

Mitä siis kuvittelet että ne cudaytimet siinä puuhaisivat samanaikaisesti? Alkaisivat rendaamaan seuraavaa ruutua kun nykyisen prosessointi on pahasti puolitessä?

Tosta näet kuinka tensorytimien kanssa ei ole päällekkäin käytännössä mitään muuta toimintaa (ja se toiminta mitä on, on hyvin samanmuotoista tensorkäytön kanssa viitaten siihen että ne on osa DLSS2.0 toimintoa), sekä kuinka se on pipelinen puolivälissä.

Tensor viittaa tässä kuvassa nimenomaan DLSS:ään.

Lisäksi niin kauan kun GPU:t on jatkuvasti tehorajotteisia, ja kuinka jo pelkällä shader- tai tensorkoodilla saadaan koko tehobudjetti käytettyä, niin ei tolla ihan ihmeitä saisi edes aikaiseksi.

Kiitos, laitatko nyt vielä lähteen näille kuville? Oman jo tuonne linkkasinkin, mikä oli suoraan Nvidian oma whitepaper.

Kuvat on nvidian profilointityökalusta control peliä pelatessa. Olis kiva nähdä vastaavat profiloinnit tosta youngbloodistakin (eikä nvidian pressimatskuja), joka on näköjään poikkeus sääntöön mikäli halpuuttajaan on uskominen.

Käytännössähän tuo päällekkäinen ajaminen nostaa yksittäisen ruudun renderöintiaikaa ja siten lisää pelimoottorin ohjauslatenssia.

Siis itsekö nää ajoit, vai mikä homma? Mua siis ihan oikeasti kiinnostaisi lukaista läpi jos nuo on osa jotain artikkelia tms. missä tuota perataan tarkemmin auki.

Oma käsitys siis tosiaan perustui vain hataraan muistikuvaan Nvidian omista esittelyistä (mille nyt tosiaan tuo whitepaperkin lähteenä ja Halpuuttajan kaivama promokuva) missä noita ajellaan samanaikaisesti, mutta vissiin totuus on sitten toinen ja ei oikeasti olekaan sitten toteutettuna kuin yhdessä pelissä.

Aa, sori. Sweclockersin yhdestä dlss ketjusta, jossa yksi käyttäjä ajoi profiloinnit:

Jonas pratar DLSS 2.0 och uppskalning med maskininlärning

http://www.sweclockers.com

Mut tosiaan niin kauan kun näyttikset on vahvasti tehorajotteisia, niin tuolla päällekkäisyydellä saatava suorituskykyero jää aika torsoksi. Käytännössä siinä voitetaan matalemman kellontaajuuden suoman paremman energiatehokkuuden verran suorituskykyä ja se siitä. Samalla lisätään bufferointia enginetasolla ja kasvatetaan end to end viivettä.

Nää kommentoinnit on hyviä kun itse ei ymmärrä yhtään mitään mistä puhutaan. Kiva silti lukea.

Jos saa spekuloida niin joku säteenseurannalla tehtävä GI voisi olla oiva taustataski pitkäaikaiseen ajoon. GI joka tapauksessa lasketaan monen framen ajalta ja se latenssi näkyy jo nyt esim. ue5:en valaistuksessa. Jos tulee joku iso muutos niin kestää monen framen ajan, että valaistus muuttuu oikeanlaiseksi. Yksinkertaistettuna voi sanoa ettei laskentateho riitä GI:n ratkaisemiseen yhden framen sisällä

Unreal Engine 5 Early Access Release Notes | Unreal Engine Documentation

Täytyy sanoa, että tuli nyt epävarmempi olo tämän asian suhteen kun lähdin tonkimaan että miksi olen tuohon käsitykseen joskus päätynyt. Saatoin puhua ihan paskaakin kyllä.

DLSS näkyi Wolfensteinissa tuolla analysointisoftalla (Nsight Graphics), jolla pomkinkin postaamat kuvat on tuotettu, ihan samanlaisena pätkänä framen loppupäässä kuten UE4:ssä ym jo Turingillakin. Mulla oli muistikuva, että Wolfenstein poikkesi muista tässä, mutta näin ei näyttäisi olevan.

Liittyy sen verran, etteivät nämä Nvidian proprietary-väkerrykset paljon lämmitä vanhan / toisen valmistajan graffakortin omistajaa. Olkoonkin, että tällä kertaa on kysymys reunanpehmennyksestä, joka luultavasti on fps:ää pienentävä tekniikka.

Rehellisyyden nimissä, en edes jaksanut lukea koko uutista loppuun asti.

Kyllä noissa nvidian tuottamissa materiaaleissa on selvästi mainittu kyseessä olevan juuri tuo peli. Se voi olla että kyseinen tila menee päälle vain kun triple buffering on kytketty päälle (looginen vaatimus), tai sit kyse voi olla jostain vain nvidian sisäiseen käyttöön tehdystä versiosta, jota ei syystä tai toisesta olla tuotu julkiseen levitykseen.

ESO AA Comparison.mp4

drive.google.com

On, siksi linkkasin sen enkä tubeversiota

Olettaisin, että DLAA vaatii tensori ytimiä kortilta toimiakseen ei se toimi muuta kuin uudemmilla korteilla varsinkin jos teknologia on hyvin samankaltainen DLSS kanssa, mutta ilman renderöidyn kuvan skaalaamista alemmalle resoluutiolle. Ainahan nämä valmistajat yrittävät luoda lisäarvoa uudemmille korteilleen eihän niitä muuten kukaan ostaisi jos saman arvon saisi vanhemmillakin korteilla.

Tensoriytimien "vaatiminen" on ihan puhtaasti NVIDIAn tietoinen valinta, kaikki nuo nyky-GPU:t osaisi laskea samat laskut. Suorituskyky on tietenkin silloin kysymysmerkki, mutta koska mitään testejä ei ole mahdollista tehdä ei voida tietää onko ero iso vai ei.