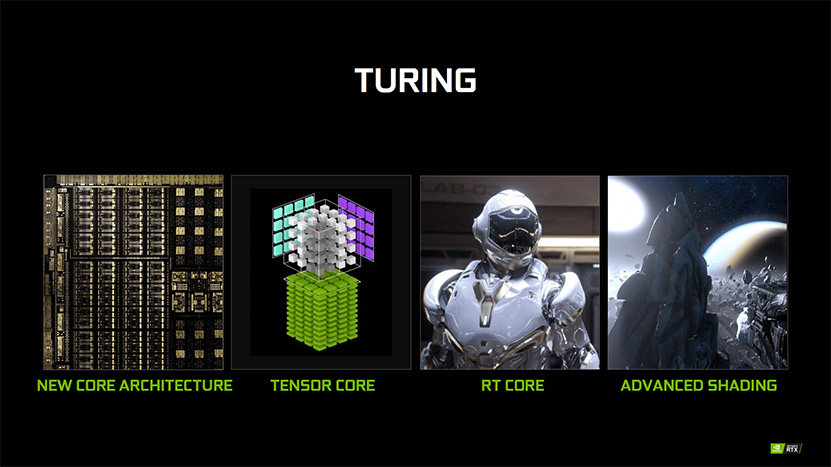

NVIDIA toi eilen kaikkien saataville Turing-arkkitehtuurin whitepaper-julkaisun. Kävimme eilen läpi arkkitehtuuriin perustuvien piirien ominaisuudet ja merkittävimmät muutokset ja nyt on aika paneutua piirien toimintaan ja uusiin teknologioihin.

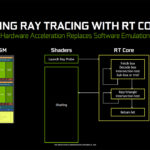

Ensimmäinen uusista teknologioista on säteenseurannan kiihdytys. Turing-arkkitehtuurin SM-yksikköihin (Streaming Multiprocessor) on lisätty uusi RT-yksikkö, joka mahdollistaa säteenseurannan kiihdytyksen laskemalla erikoistuneilla yksiköillä BVH-hakupuuhun (Bounding Volume Hierarchy) ja säteiden risteämiseen liittyviä laskuja. Yleiskäyttöisille laskuyksiköille kalliit tehtävät voidaan RT-yksiköiden avulla laskea paitsi nopeammin, myös uhraamatta piirin muuta laskentavoimaa niihin. NVIDIA on puhunut kymmenkertaisesta suorituskykyerosta GeForce RTX 2080 Ti:n ja GTX 1080 Ti:n säteenseurantasuorituskyvyssä, mutta tämän on todettu olevan tapausriippuvaista eikä päde kaikissa säteenseurantatapauksissa.

Säteenseuranta tulee saapumaan peleihin pikkuhiljaa ja tähän mennessä NVIDIA on kertonut yhdentoista pelin tulevan tukemaan ominaisuutta ennemmin tai myöhemmin. Käytännössä julkaisuaikataulua sanelee kehittäjän omien aikataulujen ja lisätyön lisäksi Windows, johon DirectX Ray Tracing eli DXR-rajapinta on luvassa lokakuussa julkaistavan October 2018 Update -versiopäivityksen myötä.

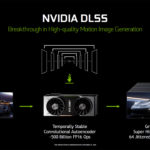

Heti säteenseurannan jälkeen eniten keskustelua on herättänyt Turing-arkkitehtuurin uusi Deep Learning Super Sampling -reunojenpehmennys. Yllä olevat vertailukuvat löydät täydessä koossa tästä: TAA vs DLSS, TAA vs DLSS 2X. DLSS on uusi tekoälyä hyödyntävä reunojenpehmennysteknologia, joka vaatii erillisen tuen peliltä ja NVIDIAlta. Kun pelille lisätään DLSS-tuki, opettaa NVIDIA tekoälylleen kyseisen pelin grafiikan ”perustotuuksia” käyttäen peräti 64-kertaista Super Sampling -reunojenpehmennystä. Muutaman megatavun kokoinen tietopaketti jaetaan joko pelin tai ajureiden mukana ja sitä hyödynnetään lopullisen kuvan muodostamisessa.

DLSS:stä on olemassa kaksi eri versiota, DLSS ja DLSS 2X, joiden toiminta eroaa jonkin verran toisistaan. NVIDIAn whitepaper jättää vielä hieman varaa tulkinnalle, mutta mikäli allekirjoittanut ymmärsi sen oikein normaali DLSS, jonka avulla NVIDIA kertoo RTX 2080:n peittoavan GTX 1080:n parhaimmillaan 100 %:n erolla, renderöi pelin todellisuudessa valittua matalammalla resoluutiolla. Tämän jälkeen hyödyntämällä Tensor-yksiköitään tekoäly käyttää ilmeisesti muutamaa edellistä ruutua sekä opeteltuja perustotuuksia luodakseen lopullisen, halutun resoluution kuvan pehmeine reunojeen.

DLSS 2X puolestaan renderöi kuvan asetetulla resoluutiolla mutta parantaa sitä käyttäen samoja 64xSSAA:lla opeteltuja perustotuuksia. DLSS 2X:n tarjoama reunojenpehmennyksen laatu on erittäin korkea ja NVIDIAn mukaan sitä on lähes mahdotonta erottaa aidosta 64xSSAA-kuvasta. DLSS 2X ei kuitenkaan tarjoa nopeusetua DLSS:n tapaan. DLSS 2X on myös käytännössä vapaa kuvan ylimääräisestä pehmenemisestä.

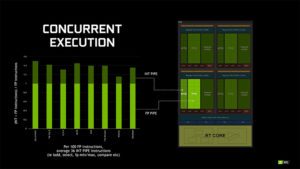

Uusi ominaisuus on niin ikään mahdollisuus suorittaa samanaikaisesti sekä INT(32)- että FP(32)-laskuja, koska Turingissa on erilliset INT32-yksiköt. Käytännössä kyse on siitä, että NVIDIA puolitti FP32-yksiköiden määrän mutta tehtävien jakelua hoitavat warp schedulerit ja lähetysyksiköt ovat edelleen yhtä järeitä kuin ennenkin. Jäljelle jäävä 50 % kapasiteetista voidaan tällöin käyttää INT32-, Load/Store-, SFU-, Tensori- ja FP64-käskyjen lähettämiseen laskettavaksi samanaikaisesti. Muutokset tehtiin jo Volta-arkkitehtuurissa, mutta nyt ne saapuvat ensimmäistä kertaa varsinaisesti kuluttajakäyttöön.

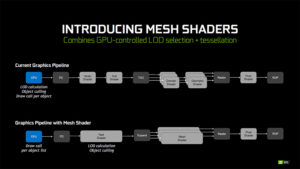

NVIDIA on lisännyt Turing-arkkitehtuuriin lisäksi tuet uusille tehtävä- ja verkkovarjostimille (Task Shader, Mesh Shader). Verkkovarjostimilla voidaan luoda kolmioita rasteroitavaksi, mutta normaalin yhden säikeen sijasta se käyttää useampaa, rinnakkaista yhteistyötä tekevää säiettä. Tehtävävarjostimet puolestaan toimivat runkovarjostimien (Hull Shader) tapaan ennen tesselointivaihetta, mutta toteuttaa tehtävänsä verkkovarjostimien tapaan rinnakkaisella useamman säikeen toteutuksella. Tämän hetkisen tulkinnan mukaan kyse on hyvin vastaavasta ominaisuudesta kuin AMD:n primitiivivarjostimet (Primitive Shader) ja se vaatii kehittäjiltä erillisen tuen ominaisuudelle. Uudet varjostimet mahdollistavat myös eri objektien kulloisenkin LOD-tason (Level of Detail) valinnan täysin grafiikkapiirin sisällä.

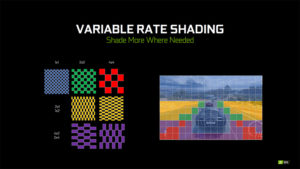

Selvästi aiemmasta kehittyneisiin ominaisuuksiin kuuluu puolestaan Variable Rate Shading, joka mahdollistaa eri ruudun osien varjostimien ajamisen eri tarkkuuksilla. Käytännössä kyse on vastaavasta ominaisuudesta kuin aiempi Multi-Resolution Shading, joka mahdollisti ruudun jakamisen yhteensä 16 osaan ja niiden varjostimien ajon eri tarkkuuksilla, mutta tällä kertaa ruutu voidaan jakaa 16 x 16 pikselin kokoisiin alueisiin, mikä esimerkiksi 4K-resoluutiolla tarkoittaa 32 400 erillistä aluetta.

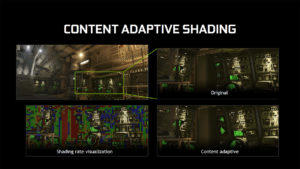

Samaa jatkokehitelmää on myös Content Adaptive Shading, joka antaa kehittäjille mahdollisuuden käyttää edellisen ruudun tietoja päätelläkseen seuraavan ruudun varjostimien tarkkuuden. Jos esimerkiksi yksi 16 x 16 alue on pelkkää yksiväristä seinää tai taivasta voi kehittäjä Content Adaptive Shadingin avulla renderöidä ko. alueen seuraavassa ruudussa matalammalla tarkkuudella. Motion Adaptive Shading puolestaan käyttää samaa logiikkaa liikkuviin objekteihin, jolloin nopeasti liikkuva objekti, jota ei kuitenkaan havaittaisi tarkkana ruudulla, voidaan varjostaa matalammalla tarkkuudella.

Texture Space Shading puolestaan mahdollistaa varjostimien arvojen laskemisen ja tallentamisen suoraan tekseleihin , joiden avulla esimerkiksi tiettyjen pikseleiden näkyvyystestit (z-test, rasterointi) ja ulkonäkötestit (varjostimet) voidaan laskea toisistaan poikkeavilla tarkkuuksilla, mikä voi parantaa suorituskykyä kuvanlaadun kärsimättä. NVIDIAn antamassa esimerkissä VR-käytössä voidaan renderöidä toisen silmän näkymä ensin ja käyttää tässä tallennettuja tietoja oikean silmän kuvan renderöintiin. Teoriassa tällöin oikeaa silmää varten tarvitsisi laskea täysin uudelleen vain ne tekselit, joita ei näy lainkaan vasemman silmän kuvassa.

Suosittelemme syvempää katsausta kaipaaville luonnollisesti itse whitepaperin lukua sekä esimerkiksi AnandTechin artikkelia.

Tähän voisi lisätä/korjata että toki DLSS X2 parantaa myös suorituskykyä vs SSAA, mutta ei siinä määrin ja eri tavalla kuin DLSS.

Käyttääkö tuo DLSS pelkästään lopullista värikuvaa reunojen pehmennykseen, vai käytetäänkö myös syvyyspuskuria apuna? Mielenkiintoista, miten koneoppiminen ihan yhtäkkiä työntyy niin monelle alalle…

Tarkennan lausetta hieman

Tulin vain sanomaan että erinomainen artikkeli.

Hyvin on nyt selitetty aikaisemmin mystiseltä vaikuttaneet markkinointipuheet.

Kiitos.

Löysin viikkoja vanhan videon jossa katsoja väitti että DLSS:llä ei juurikaan huomaa eroa TAA:n ja 2x FPS (oli juttua tuolla RTX säikeessä).

Ja kyllä tämän säikeen artikkelissa oleva kuva vertailu näyttää DLSS:llä parammalta kuin TAA. Vaikkakin on kyse kuvan suurennoksista, tuollaista eroa ei silmin huomaa liikkeessä ja varsinkaan jos käytössä 4K resoluuti eikä käytössä ole joku 100" näytin. IMO.

Jos viittaat tuohon DLSS etkä DLSS X2 vertailuun niin en ole missään nimessä samaa mieltä. Jos jätetään pois nuo liikeartifaktit jotka TAA:ssa näkyy (ne näkyvät noin vain pysäytyskuvassa, ei liikkeessä), niin DLSS on monessa kohtaa sumuisempi ja matalammalla resolla renderöinti paistaa paikoin läpi.

Toiseen ketjuun liittämässäni leikkauksessa tuosta näkyy tuo erityisen hyvin (vasen TAA, oikea DLSS):

Tuossa kuvasi kohdassa näkyy kyllä TAA paremmalta, tuossa mustassa vino-osassa.

Onkohan tässä nyt käynyt niin, että Nvidia on päättänyt alkaa renderöimään pienemmällä resoluutiolla, että uuden kortin tehot näyttää suuremmalta kuin vanhan kortin. Luin tämän ja sen Anandtechin artikkelin ajatuksella läpi ja vaikuttaisi siltä, että renderöivät asioita pienemmällä resoluutiolla ja pehmentävät ne resoluutioerot pois kuvista. tosin tarpeeksi isolla näytöllä esim. 1080p resoluutiolla pelatessa saattaa häiritä se, että vinojen pintojen reunat rasteroituu tms.

Toivottavasti punainen leiri ei lähde tällaiseen toimintaan mukaan, tehoja vaan kortteihin lisää, niin ei tarvitse alle pyydetyn resoluution rendailla ruutuja.

Yhdessä "testissä" jossa ei ole mtn. Tensoreita käytössä oli 2080Ti 22-55% nopeampi kuin 1080Ti, olikohan jotain 8-10 eri peliä testissä. 55% lisäys oli FarCry5:ssa. Siis jollain alkukantaisilla ajureilla joilla RTX edes toimii, kunhan on julkaistu ja viralliset WHQL ajurit tulevat niin sitten katsellaan… ja kunhan ajurit kehittyvät pari kuukautta.

Eikä tarvitse odotella jtn. lupailtuja GOD-ajureita joilla irtoaa +xx % kuten Vega56/64:jen julkkarissa mutisivat että näillä ajureilla startataan uusi Vega sukupolvi ja lähitulevaisuudessa kyllä lähtee.

Kaksipiipuinen juttu. Jos pienemmällä resolla rendaaminen ei huononna kuvanlaatua, niin mikä jottei. Tehoja säästyy muuhun. Mutta jos ja kun heikommalla resolla rendaaminen aina heikentää kuvaa jonkin verran, onkin sitten lopputuloksen paremmin kiinni käyttäjän tarpeista.

Jos peli on esim liian hidas oikealla reunanpehmennyksellä 4K tilassa, niin tuollainen matalamman reson rendaaminen voi olla ihan hyvä ratkaisu jos lopputulos on parempi kuin tavallinen reunanpehmennys vaikkapa 1080p resolla…

Mutta jep… tekee kyllä vertailun todella hankalaksi, varsinkin jos ja kun ruudun eri osia rebderöidään hyvinkin erilaisilla tarkkuuksilla erilaisista kohdista ruutua ja tulosta ”parannellaan” jälkikäteen jollakin metodilla joka perustuu opetettuun arvaamiseen. Eli kuva paranee, jos AI arvaa oikein, jos taas ei… well kuva ei parane, vaan saattaa jopa huonontua.

Ai että, siitä onkin aikaa kun on stillframeista pikselinussittu AA-toteutusten eroja.

Ainoa oikea ja tieteellisesti relevantti testausmenetelmä olisi tietty ABX-testaus pelitilanteessa, mieluiten isoilla ihmisjoukoilla jne.

Tuossa kuva normaali koossa ja suurennokset mukana, vinokohtien sahalaita on kyllä UHD- näytöltä läheltä katsottaessa vasta nähtävissä molemmissa tapauksissa:

![[IMG]](https://images.idgesg.net/images/article/2018/09/lkdfghpzhx-5-100771728-orig.jpg)

Nvidia Turing GPU deep dive: What's inside the radical GeForce RTX 2080 Ti

Toinen pienempi ruutu:

![[IMG]](https://devblogs.nvidia.com/wp-content/uploads/2018/09/image20.jpg)

Figure 22. DLSS 2X Provides Significantly Better Temporal Stability and Image Clarity Than TAA

Lähde: NVIDIA Turing Architecture In-Depth | NVIDIA Developer Blog

Eli on tuosta myös liikkuvan ruudun selkeys parempaa.

Mielenkiintoisempi kuin tuo pyssy, mikä on ilmeisesti liikkeessä, on se taustalla näkyvä pilvenpiirtäjä ja sen tarkkuus. Se on ihan yhtä tarkka DLSS, mikä on siis eräänlainen 2x upskaalaus tekoälyllä, kuin 4K natiivina renderöitynä. Tämä on kova juttu. Täytyy myös muistaa, että itse peli voidaan rendata DLSS, mutta pelin staattiset grafiikat voidaan piirtää natiivina 4K, siis erilaiset mittarit, tekstit, scoret jne. jotka lisätään ikäänkuin kuvan päälle. Kun se kuva sitten liikkuu 60hz tai 120hz niin ei siitä ehdi yksittäisiä pikseleitä ja niiden tarkkuuksia paljoa näkemään. Se on yks ja sama onko se aito 4K tai DLSS.

Voikohan molempia tekniikoita käyttää samaan aikaan, todennäköisesti ei koska silloin olemassa olevien Tensor ytimien laskenta teho jouduttaisiin vaikka puolittamaan 2 eri tekniikan kesken.

Mielenkiintoiseksi homman tekee jos peli tukee molempia uusia tekniikoita, taisi olla joku peli siinä tulevien pelien Ray Tracing listassa.

Siis mielessä kävi ajatusleikki joka onkin erittäin epätodennäköistä olisi tekniikoiden saman aikainen käyttö (RT-Lite 50% Tensoreista käytössä), niin Ray Tracingin joku kevennetty versio eli vaikkapa, sanotaan mainittu RT-Lite jolla vain osa RT-tuesta käytössä ollessa päällä saa kuvaa karkimmaksi, ja sitten DLSS:llä tuplataan olemassa oleva fps, tai siis ei tuplata vaan esim. puolet DLSS tuomasta nopeutuksesta koska DLSS:lla olisi käytössä toinen puolisko Tensoreista.

Noin niinkuin teoriassa, vaikka edes FHD resolla.

Yksi vilkaisu riittää kertomaan DLSS:n poistavan yksityiskohtia kuvasta. Enkä menisi sanomaan DLSS kuvaa edes realistisemmaksi, pikemmin päinvastoin.

Siinähän vasta ihme PPAA on joka saisi taiottua kaikki sahalaidat mäkeen, DLSS:llä se matalammalla resoluutiolla renderöinti vain yksinkertaisesti näkyy joistain kohdin pahasti läpi vaikka joissain kohdin onkin myös hoitanut hommansa paremmin.

Pitäisi saada lossless videota noista että voisi tehdä pidemmälle meneviä johtopäätöksiä mutta NVIDIAn julkaisemien kuvien perusteella TAA vaikuttaisi tarjoavan vähän paremman kokonaistuloksen.

@Hiikeri Ei raytracingissa ole pakko tensoreita käyttää yhtään mihinkään. Eikä DLSS:stä voi taikoa "puolta nopeusedusta", se nopeusetu tulee matalammalla resolla renderöinnistä tämän hetkisten tietojen perusteella eikä siinäkään ole mitään tekemistä tensoreiden kanssa, niitä tarvitaan vain parsimaan se kuva lopulliseen muotoonsa skaalaamalla ja paikkaamalla.

Ei. DLSS on AI metodi ja AI käyttää tensoreita. DLSS ei ole perinteinen matemaattinen upskaalaus. DLSS ikäänkuin syntetisoi koko kuvan uudestaan tekoälyllä. Se vain ’vaikuttaa’ samalta trikiltä kuin jokin bilineaarinen interpolointi, mutta ei ole sitä. Tekoäly tulkitsee alemman resoluution kuvaa pala palalta ja syntetisoi tuon datan ja treenatun neuroverkon avulla uusia palasia, kaksi kertaa leveämpiä ja korkeampia. Niistä sitten muodostuu lopullinen kuva.

Ti vs Ti ja 80 vs 80 testiä.

Ti:llä reilusta 40% tuonne ~50% lisää perusnopeutta Ultralla sekä 4K nykypeleissä.

NVIDIA GeForce RTX 2080 Ti and RTX 2080 'official' performance unveiled | VideoCardz.com

Tämä kuva on siis DLSS 2X:sta joka ei ole vastaavalla tapaa nopea kuin DLSS koska tässä kuva oikeasti renderöidään sillä valitulla resoluutiolla

Testejä :rolleyes:

Tiedän, voi olla vaan aika nuhaista Shadereilla tai Cpulla laskea Reaaliaikaista TR peleissä.

Sehän oli selvää spekulointia 50/50 ajatus leikkini.

Yksinkertaistin ja luulin että kaikki ymmärsivät DLSSn toiminnan eli tensoriytimet ne siellä pelatessa laskevat pelistä tai ajureista tulevat "esiopetetut" Deep Learning toiminnan.

Siellä on ne RT-yksiköt sitä varten. Tensoreita käytetään denoisingissa jos jossain RT-jutussa.

Tensoriytimet siis etsivät esiopetettujen tietojen perusteella tiedot miten kuvaa pitäisi parantaa että se vastaisi tavoitetta. Sen perusteella mitä NVIDIA kertoi nopeusetu ei liity siihen tekoälyosuuteen mitenkään vaan siihen että se peli renderöidään matalammalla resoluutiolla kuin pitäisi (esim 1440p renderöitäisiinkin 1080p tms, resoluutioesimerkit hatusta heitettyjä)

Tokihan se liittyy tekoälyyn siten, että ilman tekoälyä / tensoreita nopeusetuakaan ei olisi. Mutta varsinainen nopeusetu toki lähtee sieltä alemmalla resolla rendaamisesta + mahdollisesti siitä, että tekoälyä voitaisiin ajaa rinnakkain renderöinnin kanssa. En tiedä mihin kohtaan tuo DLSS pipelineä sijoittuu. Ehkä se on niin nopea operaatio, ettei sitä rinnakkain tarvitse suorittaa.

Melkoisen syvällistä proosaa. Hyvä uutisartikkeli.

Käsittääkseni kaikkien useampaa peräkkäistä framea käyttävän AA:n on sijoituttava aivan renderöintiprosessin viimeiseksi tehtäväksi, myös DLSS:n.

Mihin tuo sinun tulkintasi DLSS:n toimintaperiaatteesta muuten perustuu? En toki voi vannoa ettetkö ole oikeassa, mutta ainakaan tuosta whitepaperista ei välittynyt minulla tuollaista kuvaa

Eipä mitään kummoista tulossa. Vaatii sen verran työtä kehittäjältä implementoida nämä ominaisuudet, vaikka saattavat ollakin suhteellisen helppoja implementoida, että jää varmaan monelta tekemättä. Resurssien vapauttaminen jättäen turhaa työtä tekemättä renderöinti vaiheessa toki voi tuoda potentiaalisesti lisää graafista karkkia, mutta viehän tuokin taas yhtälailla aikaa toteuttaa.

Käyttääkkö sitten vapautuneita resursseja paranneltuun grafiikkaan vai tukeeko nämä ominaisuudet säteenseurannan esillemarssia, mikä on varsin raskas efekti ja jolle kaikki resurssit ovat tarpeen. Veikkaan että suurinosa kehittäjistä valitsee vain korkeamman ruudunpäivityksen, mikä sitten saattaa hämätä kuluttajaa siltä osin, että Nvidian näytönohjaimet vaikuttavat tehokkaammilta mitä ovatkaan, kun kyse on lopulta ihan renderöintivaiheessa tehdystä kikkailusta. Ei kikkailussa kuitenkaan mitään pahaa ole, mutta harmillista vain jos menee kehittäjiltä aikaa näiden toteuttamiseen ja ne toimivat sitten vain Nvidian raudalla.

Ikävänä pahana AMD:n korteille nämä resurssien säästöt eivät tietenkään näy AMD:n raudalla ja kaikki toimii poikkeuksetta reilusti hitaammin. Olisi paljon mukavampaa että kehittäjät suoraan hylkäisivät nämä Nvidian teknologiat ja lähtisivät ihan suoraan Vulkanin kelkkaan tuomaan ruudulle kaikkea paljon siistimpää, kuten suuria määriä partikkeleita ja vaikka mitä muita hienouksia mitä Vulkan ja tietääkseni ihan DX12 myös mahdollistaa. Tiivistettynä Nvidia ajaa kehitystä mikä taas enempi kampittaa vastustajaa, kun tarjolla olisi jo rajapintoja mitkä mahdollistaisivat paljon siistimpiä asioita ilman mitään erikoistunutta rautaa.

Paremmat reunanpehmennysmetodit ovat tietysti aina tervetulleita, mutta varmaan suurinosa suosii sitä joka vie vähiten tehoja. 4K-resoluution kanssa ei mielestäni pehmennystä edes tarvitse, ainakin mitä 49″ television kanssa kokeilin. Monessa pelissä TAA tekee oikein hyvää jälkeä, mutta vaihtelee vähän pelin mukaan. Toivottavasti näitä teknologioita nähdään korkeintaan vain jossain hyvin visuaalisissa ”elokuvapeleissä”, mitkä eivät muutenkaan tarjoa mitään mielenkiintoista interaktiivista sisältöä.

Jaa-a. Joskus olet moittinut Nvidian käyttävän liikaa ja turhaa tessalointia. :facepalm:

Nyt siis puhut liikkuvan kohteen suurennetusta pysäytyskuvasta, niin lähinnä siinä näkyy korjaukset vrt. TAA: an. Muilla asetuksilla on paljon isompi vaikutus kuvan näkyviin yksityiskohtiin. Tai voit käyttää vaikka DLSS 2x. Itse ottaisin ehdottomasti FPS- lisän tuolla DLSS: llä.:tup:

Tuossa yläkuvassa (ei suurennos) näkyy selvää lisäsisältöä ruudussa (oikealla DLSS):

katso liitettä 136589 TAA katso liitettä 136590 DLSS

Samaa mieltä.

Eri mieltä.

Nopeus sitä käytettessä vrt. TAA: an?

En tiedä minkälaisilla silmällä katselette noita kuvia jos TAA näyttää paremmalle? silmälasit? Kyllä jo tuo perus DLSS näyttää paljon terävämmälle kun TAA, DLSS 2X:stä nyt puhumattakaan. Pitäisi saada samasta pelistä kuvia sekä nopeusmittauksia TAA, DLSS ja DLSS 2X jotta pystyisi vertailemaan.

Sitten kun testit ohi poistetaan nuo käytöstä ja vain FPS:lla on merkitystä. Nyt kaivetaan kumpi tarkempi pikselin tarkkuudella.

Kiinnostaisi nöhdö Fxaa ja perus D

Nämähän vaikuttavat myös suoraan siihe fps

Instrumentarium – Juuri sinulle sopivat silmälasit – Instrumentarium

Terävämpi, realistisempi ja parempi ovat täysin eri asioita. Tulikuuma piippu joka on kliinisen siisti on epärealistinen ja kaiken päälle koomisen näköinen.

Täällä ei ole mitään muuta koomista kuin sinun jatkuvat argumentit kaikkeen Nvidiaan liittyvään.

Tämähän on täysin totta, NVIDIA on ollut tunkemassa nimenomaan liikaa ja turhaa tesselointia joihinkin peleihin (se kuuluisa betoniporsas ja hawx2 ainakin tulevat heti mieleen ylimääräisestä tesselaatiosta, muistaakseni tuoreimmassa witcherissäkin sai tesselaatiokerrointa vetää aika tavalla pienemmäksi ennen kuin visuaalisesti tuli mitään eroa. Lisääkin esimerkkejä taitaa löytyä jos jaksaisi kaivaa, nuo tulivat heti mieleen.

Mitäs näistä kuvista piti vertailla tarkalleen?

NVIDIA ei ole kommentoinut DLSS 2X:n nopeutta vielä, eli testejä pitää odotella, mutta minimissään sen pitäisi olla vähän hitaampaa kuin ilman mitään AA:ta koska toisin kuin DLSS, DLSS 2X:ssä renderöidään ruutu oikealla tarkkuudella ennen AI-settejä

Jos tarvitsee suurennoslasia ja kuvankäsittelyohjelmaa erojen havaitsemiseksi, niin silloin erot ovat merkityksettömiä (ellei juuri tuota hae tuotteelta). Jos saisi nämä samat vertailut liikkuvan kuvan muodossa..

Kiinnostaa kyllä tuo DLSS:n laatu. Luultavasti parempi kuin checkerboard jutut ym. muut kikat. Itse luulen, että DLSS 2X:lla tulee 10% takkiin nopeudessa. Luulisi sen suht nopean olevan.

Tästä perustelusta sai kyllä päivän naurut :rofl: Tuohan menee täysin pelin visuaalisen suunnittelun piikkiin; käytännössä syytät nyt aa-metodia siitä, että se tekee kuvasta tarkan 😀

Semmoinen tuli vielä mieleen että näin monen oikomisen performanssin kanssa, sekä kuvanparannukset vielä päälle, voi käydä niin että kuvasta tulee lopulta sumeampi, pehmeämpi tai siinä voi olla jopa havaittavia pieniä virheitä, jos kehittäjän implementointi ei ole täydellinen, ajurit sekoilee tai ylipäätään tekniikka ei ole viimeisen päälle hiottu. Kannattaa olla arvostelijoiden ja ennakkotilaajien tarkkana peleissä, joissa näitä tekniikoita voi käyttää, että kärsiikö kuvanlaatu jollakin tavalla. Suurempi FPS lukema ei aina tarkoita automaattisesti parempaa ja Turingin kanssa oiotaan monessa kohtaa, mikä on itse asiassa koko arkkitehtuurin ehkäpä merkittävin "teholisäys".

Tiedän jo ennestään että kaikki eivät ole kuvanaladun kanssa niin tarkkoja ja kilpamentaliteetilla pelaavia kiinnostaa lähinnä että vastustajahahmon pikselit näkyvät mahdollisimman terävästi, mutta minä ainakin kun nautin erittäin hyvän näköisistä peleistä haluan parasta kuvanlaatua ilman kompromisseja. Tälläkin hetkellä ihan ilman mitään näytönohjaimesta löytyviä teknologioita toiset pelit vaan näyttävät terävämmiltä kuin toiset, oli sama reunanpehemennysmetodi käytössä taikka pois päältä, mikä kertoo siitä miten niin monin eri tavoin grafiikan piirtämistä voi lähestyä.

Itseä kiinnostaa lähinnä se että kuinka tasalaatuista tuo ai tekee. Jos piiput piirretään joka framessa eri tavalla niin kyllä se liikkuvassa kuvassa nopeasti häiritsee. Kaikki asiat ja pinnat kun muuttuisi väriseviksi pinnoiksi. Stillikuvilla oikeastaan mitään väliä.

Kuulemma ihan normaalilta näyttää ilman värinää tms. Fps vaan selkeästi korkeampi.

Kuulemma ihan normaalilta näyttää ilman värinää tms. Fps vaan selkeästi korkeampi.

Ja tämä tieto muuttamasta nvidian demosta. Mites ihan oikeat pelit?

Täytyy odottaa oikeiden pelien testejä.

Juuri näin. Itse vain epäilen ettei isojen pelien kaikkia asioita voi opettaa ai:lle riittävän hyvin. Aika näyttää.

Nuo ympyröidyt kohdat, sulaa metallia tmv. (kun tuolla eräs mainitsi että yksityiskohtia katoaa DLSS: n myötä, nimenomaan kun nyt ei katsota suurennosta). Tuossa DLSS- ruudussa on enempi "tavaraa":

katso liitettä 136743 TAA katso liitettä 136744 DLSS

Siis aseen suuliekkejä tarkoitat? Ne ovat hyvin todennäköisesti dynaamisia joten kahta identtistä on luultavasti mahdotonta saada ylipäätään. Mikäli ne eivät ole dynaamisia, saattaa DLSS taikoa ylimääräistä ruutuun sillä AI:llaan, mutta parempi asia se ei missään nimessä liene

Huomioiden mitä tuo oikeasti tekee… ei pitäisi olla kovin suuri pelko tuosta pintojen ”värisemisestä”.

Kyseessä on siis hieman kärjistäen paranneltu: (1) reunanpehmennys ja (2) ylöspäinskaalaus terävöittäen (aka. tuo taikaparannus). Lisäksi tuota ylöspäinskaalausta tehdään vain se noin 40 %.

Isoin ongelma on, että tuo ylöspäinskaalaus ei luo oikeasti uusia yksityiskohtia. Se on vähän samankaltainen efektinä kuin (älypuhelinkameroista) tuttu valikoiva terävöitys (oleellisesti siis kuvan korkeiden paikkataajuuksien voimistaminen).

Tekoälyksi tuota ei kannata kutsua… älyä prosessissa on hyvin vähän. (Neuroverkkopohjaisista antialiasointimenetelmistä on muutama julkaisu myös muilta kuin nVidia, ja perusperiaate on lopulta hyvin yksikertainen ja mekanistinen.)

Tuo ”DLSS 2X” on näistä ehkä se mielenkiintoisempi. Kun jättää tuon keinotekoisen kuvanparannuksen pois, ja keskittyy vain antialiasointiin, niin tämä saattaa hyvinkin olla ns. paras tapa antialiasoida. (Etenkin kun ne tensoriyksiköt olisi muuten alityöllistettyjä.) Ideaalisesti tämä on tosiaan ns. ilmainen laskutoimitus saada siedettävä jälkikäsittelyantialiasointi (ja siten siis kaiken järjen mukaan tapahtuu piirtoketjun lopussa kuten FXAA, TAA, jne.).

Menetelmälle syötetään siis (oletettavasti, perustuen muutaman muun tahon koneopittuihin neuroverkkoantialiasointidemoihin) (mahdollisesti muutama viimeinen) syvyyspuskuri ja ruutu, ja se tuottaa niistä piirrettävän kuvan (käyttäen luultavasti melko pientä ja yksinkertaista konvoluutioneuroverkkoa pelikohtaisen oppimisen todellisen tarpeen suhteen ole hyvin skeptinen ja toivon jonkun nopeasti ”häkkäävän” tuon rajoitteen pois).

Kysyinkin tästä asiasta jo tässä ketjussa ja kävin lukemassa Nvidian paperista, jossa ei mainita syvyyspuskuria sanallakaan. Saa siis sen vaikutelman, että reunat pehmennettäisiin suoraan värikuvan avulla. Noissa esimerkkidemoissakin kun on aika miedosti partikkeleita, niin vähän vieläkin epäilyttää mitenkä tuo oikeasti tulee toimimaan.

Mutuna heittäisin, että partikkelit jo itsessään voisivat helposti sekoittaa tuon reunanpehmennyksen käytetäänpä syvyyspuskuria tai ei… Voi tietysti olla, että tuo järjestelmä on niin idioottivarma, ettei sitä tarvitse opettaa uudestaan joka kerta kun peliin lisätään uusia partikkeleita.

Toivottavasti io-techin artikkelissa paneudutaan näihin uusiin teknologioihin edes hiukan, jos vain mahdollista.

Ei partikkelit (tai muut osittain läpinäkyvät esineet) ole mitenkään erityisen vaikea ongelma reunanpehmennykselle? (Toki, ilman syvyyspuskuria niitä on melko mahdoton edes yrittää erikseen tunnistaa.)

Pohjimmiltaan ideana on: meillä on tämä sahalaitainen kuva, ja halutaan siitä sahalaidaton versio (menettämättä samalla liikaa yksityiskohtia oikeasti terävistä reunoista esimerkiksi tekstuureissa). Eli, jälkikäsittelyoperaattorina tuo on oleellisesti valikoiva sumennus (tunnista reuna: sumenna keskiarvoistamalla naapurustosta reunan normaalin suuntaisesti, ei reunaa: älä sumenna).

Ideaalisesti tuollainen hyvä reunantunnistin tunnistaa ne reunat hyvin jopa sen puoliksi läpinäkyvän partikkelin läpi ja tekee reunanpehmennystä myös siellä (reunanpehmennysoperaation kannalta partikkelin olemassaololla ei ole sen reunan tunnistuksen jälkeen suuremmin väliä). Pahimmillaan partikkelien alueella leijuu sellainen reunanpehmentämätön kuva kun ne reunat jää tunnistatta (jos esim. tekisi tunnistuksen pelkästään syvyyspuskurista)…

Luultavasti koska TAA:n tapaan DLSS käyttää useampaa framea, FXAA:t, MSAA:t sun muut vain yhtä.

Tavallaan näin veikkaisin, mutta kyllä tuo silti hieman ”haisee”. Ns. poimittu kirsikoita, tai rusinoita pullasta. Tai mitä ikinä sanontaa halutaankaan käyttää.

Valittu siis vielä ruutu, jossa tuossa aseessa on ihan tökeröt artefaktit piippujen juuressa kun käytetään TAA… (Ja, etenkin jos tuo nyt on pelikohtaisesti opetettu, siis vaikka oppinut että tässä pelissä ei sitten kannata käyttää edellisiä ruutuja kun niistä tulee vääjäämättä pahoja ”repimisartefakteja”… ja siksi toimii enemmän kuin FXAA tässä pelissä (etsi reunat uusimmasta kuvasta, pehmennä niiden ympäristö)…)

Siis "pelikohtaisesti opetettu" tarkoittaa pelin renderöimistä 64xSSAA:lla x kulmasta / kertaa / resoluutiolla, ei mitään "ei AA:ta täällä, AA:ta tuolla", se käyttää aina useampaa ruutua ihan niin kuin TAA:kin.

Niin tarkoittaa… mutta mitä se tosiasiallsesti (myös) tekee, on opettaa tuolle verkolle, että kannattaako kyseisessä pelissä käyttää edellisten ruutujen tietoa vai ei. Jos pelissä on paljon pyöriviä asioita, niin TAA ei toimi. Samoin neuroverkko oppii, että ei voi käyttää edellisiä ruutuja… Siksi tuo on kirsikanpoimintaa…

Eli loppupeleissä nopeampaa suorituskykyä saadaan ainostaan peleissä mitä tukee noita uusia ominaisuuksia vanhemmissa peleissä suorituskyky on normi sukupolven nousu eli luokkaa 3-8%

Ja ajureista tulee entistä monimutkaisempia eli ongelmat lisäntyy ainakin alkuvaihessa.