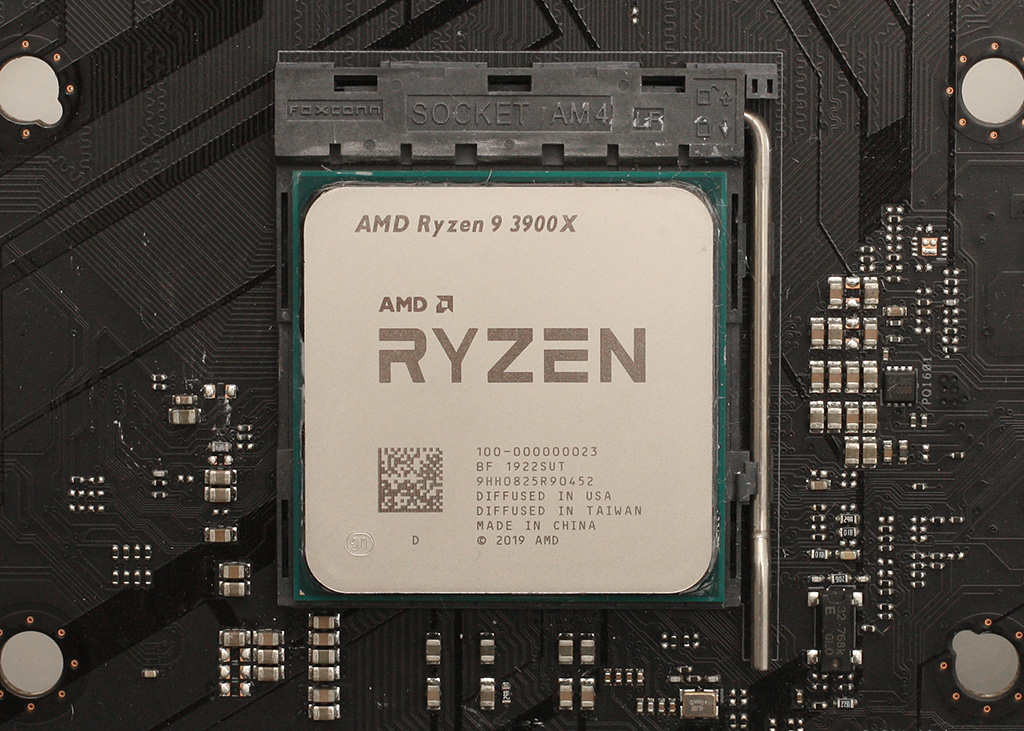

Testissä AMD:n uusista 3. sukupolven Ryzen-prosessoreista 12-ytiminen Ryzen 9 3900X ja 8-ytiminen Ryzen 7 3700X.

Saimme io-techin testiin heti tuoreeeltaan 12-ytimisen Ryzen 9 3900X:n ja 65 watin TDP-arvolla varustetun 8-ytimisen Ryzen 7 3700X:n. Tutustumme artikkelissa prosessoreiden ominaisuuksiin ja perinteisten prosessori ja 1080p-pelitestien lisäksi tutkimme suorituskykyä myös korkeammilla resoluutioilla ja testasimme muistinopeuden vaikutusta suorituskykyyn aina DDR4-4200-nopeudelle asti. Mukana on myös tehonkulutus- ja lämpötilamittaukset sekä ylikellotustestit.

Lue artikkeli: Testissä AMD Ryzen 9 3900X & Ryzen 7 3700X (Matisse)

Eipä tässä mitään, suurin työ on onneksi jo takana päin. Mielenkiintoista seurata, miten tilanne kehittyy ja toivottavasti pystyy tarjoamaan lukijoille tietoa 🙂

Ei kai sitä missään ole todistettu eikä tarkkaa syytä ole tiedossa. Tulosten perusteella vain vaikuttaa siltä, että Ryzen 3000 -sarjan prosessorit eivät saa Nvidian näytönohjaimilla kaikkea irti.

Jos foliota pitää vetää pään yli niin eikös samallatavalla voi ajatella että AMD on rukannut ajureitaan niin että Intelin prosessorit kiinni tulokset on pienemmät? 😀

No hard feelings, ihan vaan objektiivisuutta asiaan… 🙂

Tuo nyt on ihan typerää väitellä kenen vika nVidian vai AMD:n. Sitä emme ehkä koskaan saa tietää.

Vian ollessa selvästi yhteensopivuudessa sen ratkaiseminen todennäköisesti vaatii yhteistyötä nVidian ja AMD:n välillä. Ei olisi ollut järkevää jättää julkaisua tekemättä, tuo korjaus ottaa aikansa.

Noh noh, eihän kaikkien fanipoikien palvoma AMD voisi koskaan tehdä moista… unpossible. :rolleyes:

Tai sitten herätään ja todetaan että äärimmäisen monimutkaiset emo-prossu-näytönohjain-käyttis-pinot joskus käyttäytyvät oudosti ja vaativat jälkikäteen fiksailua kun kaikki ei mene niinkuin elokuvissa. Vikaa voi olla kenessä vaan, mutta 99.99% todennäköisyydellä kyseessä on "oho, mites se nyt noin…?" yllätys kaikille osapuolille…

😳

Eikös isompi ole parempi ja sittenhän nuo on just päinvastoin kuin sanoit

On se tämäkin sinänsä mahdollista mutta ongelmaa diagnosoidessa AMD:n prosessorit nimenomaan kohtasivat errorin NVIDIAn ohjaimilla.

Voisi kuvitella että NVIDIAkin on ES:ää saanut kehityslustoiksi, kun ei nyt tuon alan kilpailijasta ole kyse?

Missä kukaan on niin väittänyt?

Missä kukaan on niin väittänyt?[/QUOTE]

Ei kukaan niin ole väittänyt mutta ainakin itse vihjailit. Sen vuoksi kysyin ihan asiallisesti onko siitä jotain todisteita jo, joku jotain taisi tähän ketjuun liittääkin.

Muutaman ES-alustan joiden firmwaret ja ajurit ovat muutenkin keskeneräiset ja jatkuvassa muutoksessa, jolloin ei oikein aina tiedä, että onko vika omissa vai toisen osapuolen softissa.

En kyllä ymmärrä miten se on vihjailua että vika on varmasti NVIDIAn kun viestissä jossitellaan ja puhutaan tämän hetkisestä vaikutelmasta

AMD:llä ei ole mitään intressiä sabotoida omien tuotteiden suorituskykyä julkaisu revisioissa, kuitenkin AMD:lla on hyvin tiedossa että suurin osa julkaisuajankohdan prosessorien testeistä ja arvosteluista tehdään NVidian ohjaimilla. NVidialla olisi intressi pitää AMD mahdollisimman heikossa tilanteessa taloudellisesti ja ohjata CPU-myynnin rahavirtaa Intelille, sabotoimalla julkaisuhetkellä AMD:n suorituskykyä.

Kuitenkin melkoista foliohattuilua ja ensimmäisenä voisi olettaa tahatonta bugia jossain.

Uudet pelitestit AMD-kortin kanssa olisi kyllä mielenkiintoiset, niin näkisi miten vaikuttaa tuloksiin

No jotakuinkin joo. Tuo on kuitenkin aika radikaali muutos arkkitehtuuriin että CPU coret ja cachet ovat kokonaan erillisillä piireillä ja juttelevat IO piirille joka vasta sitten käpistelee muisteja, PCIE:tä yms.

Linux puolella on taas Zen2:lla boottiongelmia, ilmeiseti jotain ongelmaa sytemd:n ja RdRand:n kanssa, joten eiköhän nämä ole jotain corner case ongelmia aivan uudenlaisen arkkitehtuurin kanssa.

En kyllä usko että Nvidia heikentäisi AMD:n prosessoreja vaikkapa konkurssin toivossa, sillä monopoliasema on todennäköisesti ongelmallisempi kuin selkeä markkinajohto kilpailun kanssa. Nyt he voivat verrata omia tuotteitaan voittajina AMD:n malleihin nähden, monopolissa voisi olla edessä yhtiön pilkkomista.

Ja taas tässäkin tilanteessa Nvidian "tarkoituksellinen" heikentäminen satuttaisi vain heitä itseään, jos samaa 3000-sarjalaista ajetaan sekä Nvidialla "rajoitettuna" ja AMD:lla täydellä teholla, niin silloin Nvidian oma tuote on suhteellisesti huonompi AMD:n näytönohjaimeen verrattuna. Kuulostaako järkevältä toiminnalta?

Mielikuvat yhteensopivuusongelmista Nvidian raudan kanssa tuskin ovat Nvidian edun mukaisia yleensäkään, mutta etenkin juuri nyt kun uutta rautaa tulvii markkinoille.

Moni upouuden Ryzenin ostaja puntaroi ostaako koneeseen uusi Geforce vai uusi Radeon. Foliohattu voisi yhtälailla tässä tilanteessa haistaa myös AMD:n pelaavan likaista peliä, kun Geforceilla ilmeneekin ongelmia prossujen kanssa.

Mutta tosiaan, Nvidian ajuri 6viikkoa vanha, tänään tulossa mitä luultavimmin uusi, kun uudet Geforcet tulevat myyntiin.

Eri asia, että korjaako se vielä tätä ongelmaa.

Ihmetyttää että näissä keskusteluissa aina tulee esiin "tarkotuksellinen sabotoiminen" tai maksetut testit. En nyt viittaa keneenkään yhteiseen käyttäjään, vaan yleiseen trendiin.

Koska historia yleensä toistaa itseään. AMD:n kilpailijat kun ovat todistetusti sabotoineet ja maksaneet OEM valmistajille, niin miksi pitäisi olettaa että tänä päivänä ei niin tapahtuisi?

Ei teillä satu oleen hyllyssä b350 emoa? Jos heittäs testit myös sillä. Toisaalla se kyllä on työnalla eli ei pakollista.

Silloinhan tämän olisi pitänyt näkyä vanhoilla ryzeneillä paljon enemmän?

Itsekin lähtisin ensialkuun tutkimaan että ei kai siellä vain nerffata kilpailijaa jotta saadaan oma tuote näyttämään paremmalta, mutta eiköhän tuo selviä.

Tutkin nyt vähän lisää noita Boost-kelloja niin kun pisti task managerista affinity pelkästään Core 0 (eli 1 ydin, ei SMT) sain 3900X:llä Boost-kellon käymään 4575 MHz:ssä ja muutenkin se kävi jatkuvassa rasituksessa tuolla 4550 MHz tuntumassa. 1c + SMT eli afiinityssä Core 1 ja Core 2 käytössä kellotaajuus laskee keskimäärin sitten 4300 MHz.

Hei tuliko postaukseen virhe vai SMT päällä testiin. Loogisestihan varmaan ensimmäinen core ja sen SMT virtuaali core olisi 0 ja 1.. ei 1 ja 2. Jälimmäinen tapaus aktivoisi 2 fyysistä corea, joka ehkä vaikuttaa.. tai sitten ei. ? 🙂

Joo tuli eli 0 ja 1 siis

Onkohan tämä osa"syyllinen" siihen, että SMT pois päältä tuo 3900X suoriutuu paremmin joissain peleissä? Vai sittenkin jokin SMT:n ominaisuus mistä on joissain peleissä haittaa? Tai kenties molemmat… Loputtomasti keksii lisää testattavaa :btooth:

Toisaalta onko tuolla sitten väliä. Luultavasti SMT kannattaa pitää päällä, koska suuressa osassa sovelluksia, ja varmaan pelejäkin, siitä on hyötyä.

Onhan tuossa semmoinen mahdollisuus, että pelin ajaessa kamaa usaemmassa threadissa pari threadia skeduloidaan corelle X ja coren X SMT virtuaali corelle, sitten jos ne sattuvat kilpailemaan sellaisista resursseista joita ei voida jakaa niin jompikumpi jää jonoon. Ja jos taas koodin puolella toinen threadi venaa toista niin sitten jonotellaan kunnes molemmat valmistuu.

Toki voi olla myös ihan lämmöistä kiinni kun SMT:n hyödyntäminen toki myös generoi lämpöä ja jos tulee pistemäinen hotspot niin PBO saattaa nykäistä jarrusta.

3900X:n tapauksesas on vielä tietysti sekin, että ensimmäisen CCD (vai mikä se oli) täyttyminen aiheuttaa osan tavarasta ajoa toisella CCD:llä, jolloin tulee heti cache ja/tai muistiviiveitä kun tavaraa pitää ruveta synkkailemaan CCD:n välillä. Sinänsä siis hieman samalainen ongelma kun TR prossuissa jos saman sovelluksen osia pyöritellään useammalla kuin yhdellä sirulla.

Eli teoriassa voisi olla mahdollista, että 6C tehokkaasti hyödyntävä peli toimii 3900X:llä vs 3700X:llä paremmin kuin 8C tehokkaasti hyödytävä, koska jälkimmäisessa tapauksessa käyttiksen skeduleri luultavasti lemppaa tavaraa ajoon CCD2:lle. Tämä toki perustuu oletukseen että 3900X rakentuu 2x kpl CCD:stä joissa molemissa 6 ehjää corea.

Vaan tämä ihan spekulaatiota kun ei tuollaista kiveä ole käsissä niin paha testailla mitään. 🙂

Tästä oli hetki sitten keskustelua oliko se nyt tuolla AMD/Intel-väittelyketjussa, että SMT tuo pienen keskimääräisen penaltyn yhden säikeen suorituskyvylle, koska kyseessä kuitenkin jaettua kapasiteettia eli aina löytyy jotain pullonkauloja missä kaksi samassa fyysisessä ytimessä pyörivää säiettä joutuu keskenään kilpailemaan. Tämä pätee myös muihin arkkitehtuureihin, eikä siitä ymmärtääkseni päästä koskaan täysin eroon.

Huhupuheet Nvidian tai AMD:n tietoisesta sabotoinnista kummankaan suhteen voi mun mielestä heittää suoraan roskiin. Ei tee minkäänlaista taloudellista järkeä kummallekaan osapuolelle toimia näin.

Sen sijaan on ihan ymmärrettävää, että uuden raudan kanssa on jonnekin ajuriin eksynyt bugi. Tekisi tosiaan mieli nähdä vertailu 9900k vs 3900x AMD:n näytönohjaimella jolloin tää spekulointi saisi jonkinlaisen varmistuksen.

Ainoa arvostelu jossa olen nähnyt AMD:n rautaa käytettävän on gear seekersin youtubessa. Siinä 3600 ja 3600x pisti hyvin kampoihin ja jopa voitti 9900k:n osassa testejä radeon VII:n näyttiksellä. Kuitenkin ton lafkan testitulokset eroaa sen verran paljon muista näkemistäni ettei tuosta voi mitään vielä päätellä.

Koskahan sieltä EK tms julkaisee blokkia mikä olisi optimoitu näille hotspoteille, jos siitä käytännön kannalta mitään hyötyä olisi. Ainakin aika tasaisesti polkeville blokki markkinoille jotain "selvää" erilaisuutta olisi siinä tarjolla olettaen että tuosta blokin optimoinnista olisi hyötyä näille 3000-sarjaisillle.

Voisikohan sillä olla asian kanssa tekemistä että nvidia käyttää software scheduleria CPU:lla, kun AMD:n korteissa on rautascheduleri?

Testatkaa noi prossut 32gb tai 64gb muistilla. Ei kukaan noita osta ja käytä 16gb muistia. Vähän sama kuin testaisi pelejä 2060:llä.

Eihän tuossa tarvitse olla mitään suoranaista taloudellista järkeä. Puhutaan AMD:n tämän vuoden merkittävimmän tuotteen julkaisusta. Jos millään kikalla kilpailija pystyy vaikuttamaan siihen mielikuvaan, ensivaikutelmaan, mikä kuluttajilla on jostain brändistä, niin aivan varmasti siihen tilaisuuteen tartutaan.

Joo, Nvidia ei kilpaile prossujen kanssa, mutta jos saadaan tehostettua ja pitkitettyä mielikuvaa kuluttajien mielessä siitä että "Ei AMD pärjää edelleenkään pelikäytössä", niin se sataa suoraan Nvidian laariin kun myydään näyttiksiä.

Ongelmat voidaan sitten kaikessa rauhassa korjata vaiheessa, mutta mielikuva on luotu.

Mutta joo, foliot takas kaappiin ja eteenpäin, varmasti tulee lisää testejä amd:n korteilla ihan pikapuoliin.

En nyt täysin ymmärrä kysytkö tätä @Sampsa vai minulta tai miten se liittyy tuhon postaukseeni? Mutta kyllä yleensä pyrin kellottamaan paitsi prosessoria ja näytönohjainta myös muisteja.

Minähän vain pyysin tarkistamaan saisiko ne prosessorin buustikellot (kun 3900X luvataan 4.6GHz) nousemaan enempi AMD:n näytönohjaimella jos ne Nvidian näyttiksillä pysyvät alemmilla kelloilla.

Mutta nyt kun itse tulit asian ottaneeksi puheeksi voisin myös kysyä miten itse yleensä sitten kellotat, eli pelkästään prosessoria, ainoastaan muisteja vai näytönohjainta vai kahta näistä kolmesta vai kaikkia kolmea? Vaikkei se nyt suoranaisesti tähän ketjuun kuulukaan…

Toki saa ajella isommilla muistimäärillä mutta pientä rajaa elitismiin. 16gigaa on ihan jees ja riittää monelle; iteki pelailen sillä ja vanhalla prossulla tälläkin hetkellä ja jos tässä päivitän 3600:seen niin siihenkin 16gb riittää edelleenkin.

Puhuttiin 3900x ja 9900k ylikellotustesteistä. Eli ei 6 ytimisistä peruskivistä, vaan ihan oikeasti hyötykäyttöprossuista.

Kyllä nyt on pienen reality checkin aika, suurimmalle osalle 16 Gt on enemmän kuin tarpeeksi, 8 Gt piisaa jopa pelikäytössä vielä ihan hyvin. Sama näyttispuolella, suurin osa ei osta mitään 2060:iä vaan selvästi halvempia ja hitaampia näyttiksiä.

Mitä ihmettä, kyllä 16 gigatavua nykypäivänä on useimmiten enemmän kuin tarpeeksi. Mihin käyttöön tarvitset 32 tai 64 gigatavua ja siitä on näkyvä hyöty?

Liekkö tuolla muistin määrällä mitään merkitystä jos testiohjelma mahtuu pyörimään 16Gt muistissa, kun kyseessä ei ole muuta kuin testipenkki. Toki työkoneessa täytyy olla vähintään 32Gt muistia jo huonommallakin prosessorilla, 64Gt vaikuttaisi olevan omassa työkäytössä maksimi mihin kannattaa sijoittaa, tietty senkin muistin saa täyteen jos haluaa. Pelit pyörii hyvin 16Gt muistilla, ja pelikoneessa kannattaa sijoittaa enempi latensseihin ja nopeuteen, kuin määrään.

Hyötykäytössä 16 gigaa loppuu hyvinkin nopeasti, ja oletan että se myös vaikutti noihin teidän ajamiin hyötykäyttötesteihin.

Esim. tämä testi vaikuttaa vähän siltä, että muistia tarttisi lisää, saatan toki olla väärässä:

![[IMG]](https://www.io-tech.fi/wp-content/uploads/2019/07/ryzen3-bench-premiere.png)

Ilman pagefileä ainakin monet pelit nykypäivänä kippaa työpöydälle 1440p resoluutiolla ultratekstuureilla 16GB muistilla.

Tämäkin täyttä totta, varsinkin jos taustalla stiimiä, selainta tms.

Monet pelit kippaavat työpöydälle ilman pagefileä vaikka muistia olisi miten paljon, Windows ja sille suunnitellut pelit olettavat pagefilen olevan olemassa ja jos sitä ei ole ne eivät välttämättä käyttäydy oikein (pelit tai edes käyttis)

Ei kai tuo sääntö päde kuin johonkin kivikautisiin ohjelmiin, jotka ehkä on koodattu noin? Pelit pyörii hyvin kunnes se muisti loppuu ja kippaa. 2014 asti ajellut ilman pagefileä, nyt vasta tullut noita kun 1440p monitoriin päivitteli.

Windowsin virhelogit tietysti ei toimi ilman jos koko kone kaatuu.

Sama homma itellä, ajelin 1080p aikaan vaikka kuinka kauan ilman pagefileä, kunnes pelit ja selaimet alkoi viemään enemmän muistia. Nykyään ei ole kuin se 16 gigaa, mikä ei riitä siihen. Koskaan ei ole ollut ongelmia, jotka olisi johtuneet pagefilen puutteesta, vaan muisti on aina yksinkertaisesti loppunut, tai muussa tapauksessa toiminut erinomaisesti.

Minä en kyllä ymmärrä miksi sen muistin kanssa pitää pihistellä. Ainoa syy on ehkä se, että muistohjain kyykkää isommilla muistimäärillä ja se heikentää testituloksia.

Kuitenkin kun koneella haluaa tehdä jotain oikeasti, niin ei kukaan aja niitä softiaan isolaatiossa koneella minimoidakseen muistin kulutuksen. Outlook + selain auki parilla tabilla + slack + jotain vastaavaa ja muistia on oikeasti varattuna helposti se yli 8GB ihan vakiona ja sen jälkeen mahdolliselle työkuormalle ei kovin paljon 16:sta enää riitä.

Ei tietenkään tarvikkaan, en itekään tarkoittanut että pitäisi kun muistihan on nyt ennätyshalpaa ellei pidä saaha vimosen päälle nopeutta/latenssia ja vähän valojakin 🙂 Itelle toi 16 vaan riittää niin käytän sen rahan mieluummin vaikka näyttikseen. Ja tuossa ajattelin vaan lähinnä sitä työmäärää mikä tulee jos pitää rueta kaikki testit ajeleen 3 eri muistimäärällä kun jokainen voi kattoa ne perustestit ja sitten shoppailla itelle niin paljon ku tarttee + se äänensävy millä se oma totuus tuodaan esille ainoana oikeana vaihtoehtona 😉

Anandtech muuten teki omat testinsä seuraavalla setupilla:

G.Skill TridentZ 4×8 GB

DDR4-3200 CL16 6-16-16-36

The AMD 3rd Gen Ryzen Deep Dive Review: 3700X and 3900X Raising The Bar

–

Itseäni kiinnostaisivat ehkä enemmän 2x 16GB setillä tehdyt tulokset jotta mahdollista laajennusvaraa jäisi vielä tulevaisuuden varalle.

Minä kyllä isoloin duuni ja henk.koht jutut ihan erikäyttikselle asti jo tietoturvasyistä. Eli en pelaillessa pidä mitään ulkohuussia, slackia, skypeä tai muutakaan duuniin liittyvää tunkkia käynnissä. Itselle riittää 16GB ihan hyvin, joten en näe syytä vaihtaa muistikampoja vaikka CPU vaihtuu sysksyllä. En koe saavani rahalle vastinetta pienestä kellotaajuuden korotuksesta siinä suhteessa mitä ne uudet kapulat maksaa. Vanhoista kun ei tässä vaiheessa kummoisesti rahaa saa myymällä.

Kyllä mä tätä io-tech selainta ainakin työkoneella ajan ihan tyytyväisenä ja siinä sivussa whatsapin desktop-clienttiä. Kotikoneella ei tietty työ-outlookit, skypet tai muut pyöri.

Noh vielä vuosi sitten muistit olivat paljon kalliimpia kuin nyt. Korkeaan kellotaajuuteen ja pieniin viiveisiin kykenevät muistit ovat vieläkin kalliita.

Muistia ei myöskään voi päivittää pienissä erissä. Kahden muistikanavan järjestelmissä pitää käytännössä tuplata muistin määrä, vaikka vähempikin riittäisi. Itselläkin 32 GB keskusmuistia, mutta suurin muistintarve on tainnut olla n. 24 GB. Eli kolmasosa on täysin käyttämättömän. Tuon rahan (yli 100e) olisi voinut laittaa johonkin järkevämpään, josta olisi oikeasti hyötyä.