Intelin prosessoripuoli on ollut AMD:n Ryzenin julkaisusta lähtien enemmän tai vähemmän sekaisin. Kilpailun sekoittaman pakan tilannetta ei auta se, että yhtiöllä on suuria ongelmia 10 nanometrin valmistusprosessinsa kanssa ja 14 nanometrin tuotantokapasiteetin riittämättömyyden vuoksi Intel joutuu päivittämään Vietnamissa sijaitsevan testi- ja kokoonpanolaitoksen Copy Exactly! -menetelmällä 14 nanometrin -prosessoreille sopivaksi (PDF).

Ice Lake on Intelin surullisen kuuluisaa Cannon Lakea seuraava arkkitehtuuri. Viimeisimpien tietojen mukaan sen julkaisun olisi pitänyt tapahtua 2019, hieman ennen vuoden 2020 ensimmäisellä puoliskolla julkaistavaa palvelinpuolen Ice Lake-SP -versiota. Suunnitelmat ovat kuitenkin viivästyneet tuoreimpien vuotojen perusteella ja Ice Lake on luvassa kuluttajapuolellekin vasta 2020.

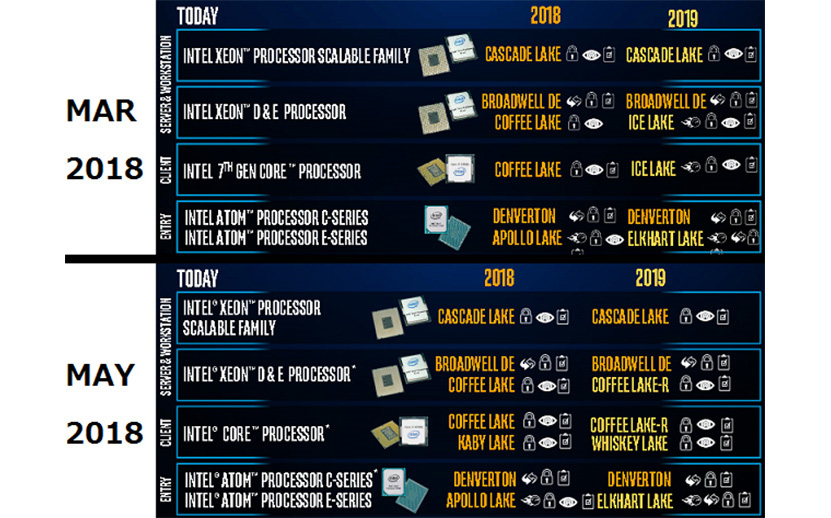

Expreviewin julkaisemien diojen mukaan Ice Laken julkaisu oli ajoitettu vuoteen 2019 vielä tämän vuoden maaliskuussa, mutta jo toukokuussa tilalle saatiin päivitetty roadmap, jossa Ice Lakea ei näy. Vuodet 2018 ja 2019 kattavan roadmapin mukaan ensi vuonna markkinoilla ovat Ice Laken sijasta Coffee Lake-R ja Whiskey Lake.

Lähde: Expreview

Siinä olisi AMD:llä todella hyvä rako menestyä Zen 2:n kanssa.

Nah… Intel tekee taas jonkun diilin valmistajien kanssa ja AMD jää nuolemaan näppejään…

No toivottavasti ei sentään, mutta kun AMD edellisen kerran oli jopa niskan päällä Intel kyllä osasi likaisen pelin.

Intelhän meinasi teettää joitain CPU:ita TSMC:llä mutta se yllättäen peruuntuin, vähän samaan aikaan kuin AMD ilmoitti että kaikki sen 7nm CPU:t tehdään TSMC:llä.

Olisikohan AMD kopioinut Intelin pelikirjaa ja antanut TSMC:n ymmärtää että olisi TSMC:n etujen mukaista laittaa niiden Intelin prosessorejen valmistushinta niin ylös että Intel menettää mielenkiintonsa 🙂

Intelin alamäet on hyväksi kilpailulle, kannatan.

Ryzen menestyy servu markkinoilla todella hyvin ja pelikäytössä tuntuu ryzen pelaavan vajaasti tietyissä peleissä Pubg 1 core 80% ja 15 10%-20% vaikka cpu bottleneck tuntuu Ultraview kanssa kaupungissa… 3.9Ghz kelloilla cpu usage peleissä 20%

Eiköhän myöhästyminen liity lähinnä rautapuolen tietoturvafikseihin, tuskin ryzenillä on sen kanssa mitään tekemistä.

Nyt melkein valmiit tuotteet on tuotu markkinoille ja niitä softapaikkaillan ja noita taas paikkaillaan rautapuolelta ja sitten jatketaan.

Väittäisin kyllä, että tuo on 100-prosenttisesti valmistusprosessista kiinni. Jos valmistusprosessi toimisi, siihen kannattaisi vaihtaa vanhempikin arkkitehtuuri. Ryzeniin tämä ei liity mitenkään, paitsi ehkä lisää Intelin johdon paniikkia.

Vaikka sääli onkin aina kun uudet tuotteet myöhästyvät, tulee kyllä mieleen että tällä kertaa ihan hyvä, antaa AMD:lle mahollisuuden saada hieman markkinaosuutta takaisin joka taas pitkällä tähtäimellä on varmasti kuluttajan eduksi.

Juurikin noin!

Ajat ovat onneksi muuttuneet. Nyt on monta firmaa joilla ei ole rahasta tiukkaa. Toisekseen firmat ovat nähneet mitä tapahtuu kun yksi yritys hallitsee ja siksi haluavat varmasti toisen kisaan mukaan.

Buginen peli, toimii huonosti about kaikilla olemassa olevilla prosessoreilla.

Ainakin mitä uutisia olen seurannut, niin useat valmistajat ovat jo nyt alkaneet tilaamaan amd:tä yhä enenevässä määrin

Jos vain valmistusprosessi toimisi jollain lailla, niin Intelillä ei tosiaan olisi varaa viivästyttää tuotteiden valmistamista sillä.

Die-shrink tarvittaisiin jo kasvaneiden ydinmäärienkin takia kasvattamaan waferilta saatavien sirujen määrää.

Varsinkin monoliittiset palvelinprossut alkavat olla megaliittejä kooltaan.

Ja niiden markkinoiden katteilla ei tosiaan kannata myydä ei oota, niin desktop puoli voi joutua kärsimään kapasitettipulasta vaikka kuinka pitkään.

Vieläköhän löytyy ketään joka uskoo Krzanichin potkujen viralliseen syyhyn…

Nämä Intelin 10nm lykkäyksen on jo niin isoja että tuossa ajassa ehtii vaihtaa osan 10nm tehtaiden tuotantolaitteistosta toisenlaiseen, herääkin kysymys onko se Intelin 10nm niin perseellään että ne tosiankin joutuu vaihtamaan laitteistoa saadakseen aikaan toimivan prosessin.

Kyllähän tuossa täytyy olla jotain perustavanlaatuisesti pielessä. Noh, AMD kiittää. En tosin vieläkään oikein ymmärrä millä perusteella Intelin osake on niin alhaalla ja AMD suhteessa ylhäällä? Jos katsoo yritysten tuloksia niin aika kovat odotukset on AMD:lle sen suhteen laitettu.

Intelin markkina-arvo on yli 200 miljardia, en nyt sanoisi että osake on jotenkin alhaalla firmalle, joka on vuosia myöhässä tärkeimmän teknologiansa julkaisussa. Kyllä tuossa on aika kovat odotukset, sille, että Intel saa homman toimimaan.

Osakkeiden arvo heijastaa yleensä myös pitemmän ajan tilannetta eikä pelkkää hetkellistä tulosta.

Itse asiassahan osakemarkkinat jättivät huomiotta Meltdownin/Spectren vaikutukset isojen katteiden palvelinpuolella.

(Intelin hyper-threadingin toteutuksessa oleva TLBleedkin on toinen bugi)

Ja johan se oli jo alkuvuodestakin selvää, että AMD:n MCM ratkaisu pystyy antamaan laskenta/palvelinpuolelle paljon edullisemmin runsaasti säikeitä/ytimiä kuin Intelin monoliittiset prossut.

Samoin 10nm:n kuseminen Olkiluoto 3:n lailla aiheuttaa ongelmia.

Vastaavasti taas AMD:llä on valtava kasvupotentiaali noilla hyvän kateprosentin markkinoilla ja MCM rakenteella ydinmääriä on helppo kasvattaa ilman valmistuskustannusten rajua nousua.

Zen2 ja 7nm voivat hyvinkin viedä suorituskykykuninkuuden useimmissa asioissa Intelin Skylake-johdannaisilta.

Zen arkkitehtuuri myös varmasti löytää tiensä konsoleihinkin.

Siitä on todella pitkä aika kun AMD on ollut yhtä hyvässä tilanteessa.

Ja vaikka ei Intel tästä mihinkään kaadu, niin voivat parin vuoden päästä joutua kilpailemaan paljon tasaväkisemmistä lähtökohdista pystymättä rahastamaan kaikessa.

Nyt alkaa tulla joko prosessin pienennyksen rajat vastaan, tai jotain muuta on Intelillä kunnolla sekaisin. AMD kiittää ja kuluttajat myös kunhan Zen 2 julkaistaan, niin ei varmaan jää mitään syytä ostaa Intelin tuotteita.

Mitä paremmin AMD:llä menee ja mitä huonommin Intellillä, sitä kovemmat paineet Intellillä on tilanteen korjaamiseen ja sitä enemmän he todennäköisesti investoivat siihen. Joten kyllähän tämä kaikenkaikkiaan aivan mahtava juttu on pidemmän päälle. Intelli jauhanu melkein paikallaan viimeiset 10v ja yhtäkkiä onkin pakko alkaa oikeasti keksiä konkreettista parannusta suorituskykyyn. Intellillä ei kuitenkaan raha lopu vaikka menis vuosikaudet korjata ongelmat.

Henk koht. mututuntuma on, että seuraavana 5v mennään prossupuolella huomattavasti enemmän eteenpäin, kuin viimeisen 10v aikana. Olit sitten punaisessa tai sinisessä leirissä elämme helvetin hienoja aikoja.

Tässä vaan sellainen pieni ongelma, että Mooren laki on tullut tiensä päähän ja jokainen uusi valmistusprosessi on ollut aiempaa kalliimpi. Suunnilleen ainut tapa saada lisää laskentatehoa (enemmän kuin vuosittaiset 1-5%) on vaihtaa radikaalisti arkkitehtuuria, mikä on nykyisten appsien tekijöille kauhistus. Jonkin aikaa pelkästään ydinmäärää kasvattamalla pääsee myös eteenpäin. Kantavat teemat tulevat olemaan erilaiset ja ehkä vaikeasti ohjelmoitavat uudet arkkitehtuurit, hyvin heterogeeniset erikois-coret tekemään eri juttuja, uudet ohjelmointikielet, aiempaa rankempi optimointi ja matalan tason ajattelu. Valmistustekniikkapuolella on eräänlainen kriisi päällä. Toisaalta suurteholaskentaa on jo nyt tehty 32-64 ytimellä, joten siltä osin ei ole kovin jännittävää, että isommat ydinmäärät tulevat kuluttajien saataville. Näin on aina käynyt ja kyse on vaan siitä, että nykyiset 1000-5000 euron sirut saadaan ennen pitkää kertaluokkaa halvemmaksi ja Pertti Peruskuluttajan kukkarolle sopivaksi.

Tuo ei tiedä hyvää Intelille. Jos AMD onnistuu kunnolla tuon Zen 2 kanssa ja arvostelut ovat positiivisia, niin Intelin osake rysähtää oikein kunnolla. Ja OEM valmistajat ovat vissiin jo nyt tyytymättömiä Intelin prosessoreiden saatavuuteen.

Lisäksi tuossa on nyt oikeasti mahdollisuus, että ensi vuonna AMD:llä on yhtä nopeat tai jopa hiukan nopeammat prosessorit kuin Intelillä. Edellisestä kerrasta onkin aikaa melkoisesti. Kuluttaja kiittää.

Intel on ilmoittanut valmistajille, että jouluna/vuoden vaihteessa heillä ei tule riittämään prosessoreita kaikille, joten tilaukset pitää syöttää nyt jos meinaa apajille. Epäilemättä tämä nostaa monen valmistajan kiinnostusta AMD:tä kohtaan. Sääli ettei Zen2 kerennyt vielä tämän vuoden joulumarkkinoille.

Jotenki en usko että kyse on 10nm ongelmasta. Enemmän tuntuu kun on kirjoitettu että Intelin prosessori vaatii suurempia muutoksia kuin AMD:n jotta vuoto jutut saadaan korjatttua, niin kyse on tästä.

Valmistuu vuonna 2020, jolloin Intel toivoo prosessin olevan käyttökelpoinen. Toki Intelillä pitää silloin olla riittävästi uuden prosessin valmistuskapasiteettia.

No se että Intel joutuisi potkimaan itseään ahteriin urakalla tekisi pelkkää hyvää kuluttajille.

Sen verran pitkään Intel vain rahastanut härskisti ihan teknisen puolen ulkopuolellakin.

Kuten koverat mitä sattuu muotoiset heatspreaderit heikentämässä kontaktia jäähyyn ja hammastahnat heatspreaderin alla.

Jos unohdetaan hig end/kellottelut, niin ainahan se nostaa vaatimuksia jäähylle.

Tuskin liittyy tietoturvafikseihin kun siellä on jo saatu julki ekat prosessorit joissa on paikattu osa ja pian tulee Cascade Lake jossa on korjattu "kaikki" (niin kaikki kuin ilmeisesti mahdollista tällä hetkellä Intelin arkkitehtuureille)

Ei ole mihinkään peruuntunut, Intel tekee kyllä tälläkin hetkellä joitain piirejä TSMC:llä ja huhujen mukaan yhden piirisarjan tuotanto on siirretty tai siirretään TSMC:lle.

Mitään "kunnon prossuja" (ts core, xeon jne) ne ei käsittääkseni ole ikinä aikonutkaan tehdä TSMC:llä.

Ei.

Kuten jo todettua Intel on tälläkin hetkellä TSMC:n asiakas.

Jossain vaiheessa kannattaa myös tehdä syvempiäkin muutoksia.

Se nyt on täysin selkiö, että uudet piirit olivat suunniteltu sitä silmälläpitäen, että 10 nanon prosessi olisi käytössä, tietynlaisena. Nyt se ei ole, joten samalla voi ihan hyvin tehdä syvemmälle ulottuvia muutoksia ja ne sitten myöhästyttävätkin selkeästi enemmän, niin kuin nyt on käynyt. Intelhän tiesi noista jo jonkinaikaa ennen julkaisua, joten sitä on varmasti huolella suunniteltu, mitä kannattaa tehdä minkäkin tuotteen kanssa. Jos tuote oli tarpeeksi valmis, niin softa (mikrokoodipätsit) jos taas suurinpiirtein valmis, niin pientä hiontaa rautapuolelle (nuo mainitsemasi tuotteet) ja jos vielä kuitenkin miltei suunnittelupöydällä, niin sitten katsotaan, keretäänkö, kun pistetään syvemmälle ulottuvia muutoksia ja jos ei keretä, niin siirretään tuotteita, niin kuin nyt on tehty.

Tuo voi toki olla seuraus 10nm:n ongelmista, mutta kyllä ne 10nm:n ongelmat ovat se perimmäinen syy.

Minä haluaisin nähdä edes 10 nm prosessin käytännössä (40nm (MMP) ja jne..) Lithography 193 nm

Ei, vaan intel on teetättämässä piirisarjoja (tai siis IO-ohjain piirejä, termi "piirisarja" on vanhentunut kun piirejä on vain yksi) TSMC:llä.

Jotkut asiaatuntemattomat reportterit vaan luulivat, että kyse oli prosessoreista ja uutisoivat tästä virheellisesti ja väittivät, että intel olisi valmistuttamassa prosessoreita TSMCllä.

Kyse oli siis vain uutisankasta. Ja uutisankan paljastumisesta uutisankaksi, ei perumisesta.

[semiot]

Tosin Intel tekee tai on tehnyt aiemmin ihan prosessoreja siellä TSMC:llä (SoFIAa ainakin)

[/semiot]

TLBleed ei ole mikään bugi. Se on sivukanavahyökkäys.

Ja se vaatii sen verran tarkkaa tähtäämistä juuri käytössä olevan prosesson TLB-rakenteelle, että Zen saattaa olla aivan yhtä haavoittuvainen – että kukaan ei vaan ole vielä koodannut TLBleediä joka on tähdätty Zenin erilaista TLB-rakennetta vastaan.

Oleellista on suorituskyky, ei säikeiden määrä. Ja sama suorituskyky pienemmällä säiemäärällä on parempi, koska 1) Aina välillä tulee vastaan tilanteita, joissa vaan tarvitaan maksimaalista yhden säikeen suorituskykyä 2) Joissain softissa lisensointimaksut menee ydinmäärän mukaan. Sama suorituskyky vähemmällä ydinmäärällä -> halevmmat lisenssimaksut.

MCM ei ole mikään yksisarvinen jolla ytimien määrää voidaan kasvattaa ongelmitta, vaan siinä on omat selväst haittapuolensa.

Tietokoneen hierarkiassa ytimien suhteen voi olla monta tasoa, karkeasti ottaen:

1) ydin

2) läjä lähellä olevia ytimiä joilla jaettua välimuistia

3) piilastu

4) soketti(paketti)

5) yksittäinen tietokone (yhteinen muistiavaruus, välimuistikoherentti)

6) monen tietokoneen verkko (supertietokone)

Ja oleellista on, miten eri ytimet kommunikoi keskenään, kuinka paljon se tulee pullonkaulaksi

Intelin piireissä ei tällä hetkellä erillisinä tasoja 2,3,4 vaan ne on kaikki samaa.

AMDllä taas 4 ydintä muodostaa 2-tason(CCX) jonka sisällä kommunikaatio on hyvin nopeaa, mutta heti kun mennään sieltä ulos, kommunikaatio hidastuu selvästi. Ja kun mennään ulos samalta piilastulta, kommunikaatio hidastuu vielä selvästi lisää. Riippumatta siitä, onko se samassa paketissa samassa soketissa vai eri soketissa.

AMDn MCM-ratkaisu siis hidastaa ytimien välistä kommunikaatiota, ja se hidastaa muistiviivettä muistiin joka on kytketty toiseen piilastuun

Intelillä taas kaikki soketin ytimet on samassa meshissä, ja kommunikaatio niiden välillä on nopeaa (tosin hitaampaa kuin AMDllä kommunikaatio saman CCXn eri ytimien välillä). Ja kaikki samaan piilastuun eli sokettiin kytketty muisti toimii intelillä nopeasti.

Sitten samalta piilastulta ja soketilta ulos toiselle soketille menevä liikenne on selvästi hitaampaa.

MCMn ongelmana on kommunikaatio hitaus piilastujen välillä. Piirin sisälle voidaan helposti tehdä väyliä jotka ovat satoja tai jopa tuhansia bittejä leveitä eikä tämä maksa juuri mitään eikä kuluta hirveästi sähköä. Eri piilastujen välillä taas tällaiset väylät tulevat kalliiksi ja kuluttavat helposti paljon virtaa.

Ja itse asiassa intelillä on hallussaan parempi paketointitekniikka tällaisten järeiden MCMn sisäisten piilastuja yhdistävien väylien tekemiseen, MCM.

Intel pystyisi tekemäään AMDtä paremman MCM-prosessorin, jos haluaisi.

Tähän asti ei ole halunnut, koska

1) EI ole halunnut tehdä pienempää piilastua ja laittaa niitä samankokoiseen pakettin, koska ei ole halunnut kärsiä piilastujen välisen kommunikaation overheadeiesta. Mielummin on vaan tehnyt ison piirin, joka on nopeampi, mutta hiukan kalliimpi valmistaa. Laatu vs valmistuskustannukset.

2) Ei ole halunnut tehdä samankokoisista piilastuista isompaa pakettia, koska tämä tuottaisi järkyttävästi lämpöä, ja vaatisi järkyttävän leveän muistiväylän, parempi tehdä vaan useampi soketti, joka on helpompi jäähdyttää ja jonne saa helpommin ne muisitjohdot reititettyä.

Mutta voi olla, että kun markkinat huutaa "moar cores!" niin intelkin päätyy MCM-ratkaisun tekemään, ja laittamaan pari isoa piilastua samaan pakettiin. Ja kärsimään sitten ehkä vähän muistikaistapullonkaulaa, jos ei saa yhteen sokettiin tarpeeksi muistikanavia.

Numeronmurskauksessa vaan ei ainakaan;

Tällä hetkellä Skylake-SP:n järeimmät mallit tarjoaakin vain 4x teoreettisen flops-suorituskyvyn/ydin/cycle Zeniin verrattuna, kun käytetään AVX-512-koodia. Aika paljon saa AMDllä olla kirimistä, että numeronmurskauksessa saa inteliä kiinni.

Löysi jo, kiinalaisia varten on jo tehty custom-konsolipiiri jossa zen, vega sekä 8 gigaa GDDR5sta. (Zhongshan Subor)

Eihän se täydellinen olekaan.

Mutta täydellisessä maailmassahan voitaisiin valmistaa mielivaltaisen kokoisia prossuja samalla hinnalla per pinta-ala.

Mikä ei sekään päde yhtään sen enempää.

Tähän täytyy sanoa että ArodedTV:n zen masterplan videolla (tai jollain zen videolla) on hyvää dataa siitä miten amd on tutkinut noiden erilaisten muistikonfiguraatioiden toimivuutta. Ilmeisesti aktiivisella interposerilla voitaisiin suurin osa muistiviiveongelmista saada ratkaistua. Ei siis tietenkään täydelliseksi, mutta hyvin toimivaksi. Joku mikälie vänkyrädonitsi se paras vaihtoehto olikaan.

Veikkaisin kyllä, että markkinat kyllä sopeutuvat, jos ytimiä tulee radikaalisti lisää. Ei lisenssimaksujen koko voi loputtomiin sanella, ettei teknisesti mahdollisesti ihan pätevä tekniikka yleistyisi.

Ottaen huomioon, että RPi-klusteritkin ovat kova juttu joissain piireissä, yhdysväylän nopeus ei monissakaan tehtävissä ole mitenkään tärkeä. Säikeiden välinen synkkaus on jo suhteellisen kallista nykyäänkin noissa 4+ ytimen laitteissa, joten ne algoritmit, jotka toimivat 4 ytimellä, ovat luultavasti melko toimivia 8-64 ytimelläkin. GPU:lla ja toisinlaisilla arkkitehtuureilla voi jakaa ihan eri tavalla tietoa, esim. kellojakson välein yhden 'warpin' sisällä toiselta 'ytimeltä'. x86 taas menee aika kyykkyyn, kun synkkaus voi kestää satoja tai tuhansia kellojaksoja.

Mihin tekniikkaan nyt tässä oikein viittaat? "Moar cores"-tekniikkaan?

Raspberry pi-clusterit? Ne on täyttä pelleilyä. Täysiä leluja.

Aina löytyy ihmisiä, jotka leikkii, mutta jospa ei nyt sotkettaisi ihmisten leikkejä/leluja ja oikeita tuhansien eurojen hintaisia työkaluja toisiinsa.

.. mutta muistin viive on. Enemmän pieniä NUMA-nodeja pienemmän määrän suuria NUMA-modeja sijaan tarkoittaa suurempaa keskimääräistä muistiviivettä.

Ja jos se kommunikaation nopeus ei ole tärkeä, sitten voidaan melko helposti myös laittaa ne piilastut kokonaan eri soketteihin. Ja tällöin muistiväylien reitittäminen ja jäähdytys on paljon helpompaa, ja saadaan parempi suorituskyky virrankulutuksen kasvamatta.

Tässä on nyt kyse hyvin eri asioista.

Oikean säikeen vertaaminen GPUn work itemiin on täysin rikkinäinen vertailu.

CPUllakin voi ajaa montaa work itemia eri SIMD-linjoissa, erityisesti AVX-512 on suunniteltu nimenomaan siihen, ja toisaalta GPUlla synkkaus eri work grouppien välillä menee kyllä myös hyvin hitaaksi. Ja se data liikkuu kyllä sieltä COUN SIMD-linjalta toiselle hyvin nopeasti shuffle- tai permute-käskyllä.

Tämä on kuitenkin täysin eri asia kuin se, että data liikkuu välimuistikoherentisti ytimen välimuistista toiseen, synkronointien kera.

Ja muutenkin välimuistikoherentin C:llä ohjelmoitavan systeemin synkronoinnin vertaaminen ei-välimuistikoherenttiin OpenCL:llä/CUDA:lla ohjelmoitavaan systeemiin..

Suurin osa, muttei kaikkia.

Ja interposer on kallis, ja intelin EMIB tekee käytännössä kaiken sen, minkä interposer, mutta halvemmalla.

Tähän asti kaikki interposerit ja EMIB:t ovat olleet passiivisia. Eli pelkkiä johtimia. Tuo aktiivinen interposer olisi siis sitä että interposer olisi valotettu piilastu siinä missä piirikin. Toki interposer saisi olla kertaluokkaa suuremmilla prosesseilla ja virheitä saisi olla vaikka kuinka ilman ongelmia. Aktiivisella saavutettaisiin vain se että tuo muistijärjestelmä ei olisi niin suuri pullonkaula useamman sirun konfiguraatioissa.

tuosta eteenpäin oli se eri topologien testausta. Hieman pidemmällä verrataan myös Intelin EMIB toteutukseen.

Vaikka se aktiivinen interposer olisikin tosiaan kalliimpi niin kasa pieniä piirejä tuottaisi huomattavasti korkeammat kellotaajuudetkin. Tämä siis ilman virrankulutuksen nousua (sama jännite).

katso liitettä 140537

Jos AMD saisi tuotettua 64 core 2.7GHz all core serveriprossuja kohtuuhinnalla niin Intel olisi todella ongelmissa. Oikeastaan hinta saisi olla se $10k eikä se olisi ongelma.

Toki kuluttajapuolella perusprossut tulee varmasti olemaan single chip malleja todella pitkään, koska niissä useammasta piiristä ei vain ole hyötyä ja maksaa enemmän. Näin siis sekä AMD että Intel. Serveripuolella tilanne on kuitenkin toinen, kuin myös enthusiast tason työpöytäprossut (TR ja HEDT ylipäätään).

Samaa mieltä. Jos noille nyt pitäisi joku hyvä käyttökohde keksiä, niin clusteri koneelle softan koodauksen opetteluun tuo on tietysti toimii ihan ok jos ongelmat pidetään tarpeeksi pienenä raspi:n muistimäärille. Silloin rauta tulee halvaksi (ja monia sopivia ongelmia kyllä on joilla harjoitella). Muuten ihan leikkikaluja.

Monikohan noiden leluklustereiden rakentelijoista osaa, jaksaa ja pärjää ko. koodailussa. Se olisi ihan kiva tietää. 🙂

Muutama kurssi tuli aiheesta käytyä ja koululla oli onneksi vähän hienommat puitteet siihen touhuun. Oli tosin sen verran päätä hajoittaavaa touhua, että päätin ammatikseni kirjoitella vähän toisenlaista koodia. 🙂

Heh!

On siellä hyviäkin koodareita, mutta edullinen alusta tarjoaa tietysti kokeilun mahdollisuuden puhtaille harrastajillekkin.

Toisaalta pienet tehot ja muistit ohjaavat tehokkaaseen koodaamiseen, mutta ei rasberryllä koodaaminen kenestäkään koodarigurua itsessään tee.

Mutta on se harrastus, josta toiset nauttivat ja itse osaan nostaa hattua myös taitaville Rasberryn koodaajille!

Niin, PC-puolella näyttää vahvasti siltä, että ytimien määrä lisääntyy ajan funktiona ja HT:n kanssa päästään varmaan muutamien vuosien sisään 32-64 softan näkökulmasta loogisen coren järjestelmiin. Asiakkaat eivät oikein tykkää ideasta, että ohjelman hintaa voi skaalata ylöspäin tällä verukkeella, jos aiemmin esim. kellotaajuuden noston myötä nopeutus tuli lisensöinnin kannalta ilmaiseksi.

Pointti oli sanoa, että on vahvasti hajautettuja rinnakkaisalgoritmeja, joissa tehtävät ovat niin irrallisia, että RPi-klusteri voi ajaa niitä tai pilvi-instanssit tai yksittäiset kotitietokoneet. Jos jossain moniytimisessä laitteessa muistisaanti corelta toiselle kestää mikrosekunnin liian kauan, kyllä se silti näille käyttäjille voi sopia. Ytimien sijoittaminen yhdelle piirille voi tuoda logistisia helpotuksia kun laitteita pitäisi kasata järjestelmiksi.

Voi olla näinkin, mutta jostain syystä suunta on ollut poispäin monisokettisista koneista. Onko sitten kustannus loppukäyttäjälle vai mikä, mutta ihan tuotesegmenttiin katsomatta integroinnin astetta on haluttu lisätä.

Ei niitä suoraan pidäkään verrata, mutta jos haluaa kartoittaa, mitä käyttöä on millekin koneelle, ja tekee 2d-matriisin niin, että vaakaan on listattu erilaisia arkkitehtuuriratkaisuja (jos niitä jossain määrin voi listata) ja toiseen suuntaan erilaisia algoritmeja erilaisin rinnakkaisuusastein, tässä huomaa, että joillain kernel-funktioita käyttävillä algoritmeilla tarve kahden ohjelmalaskurilla varustetun yksikön väliseen kommunikointiin on niin suuri, että vaikka x86-latensseja pienentäisi esim. 90% nykyisestä, algoritmia ei silti kannata toteuttaa näin vaan kannattaa jakaa ongelma siltikin todella isoihin lohkoihin, vaihtaa datarinnakkaisuudesta tehtävärinnakkaisuuteen ja optimoida yhden lohkon sisällä sitten yksi core ja SIMD. Tämä tarkoittaa sitä että koko joukko rinnakkaisuuden tekniikoita pitää jättää pois laskuista ja toteuttaa about kaikki mahdollinen jollain korkealla tasolla lohkovalla algoritmilla.

Varmasti näin, mutta AVX on melko kankea väline verrattuna esim. GPU:n vastaavaan. Ja se ei skaalaudu kivasti vaan yhtenä rajana on se yksi core ja sitten toisaalta mitä leveämmäksi SIMDiä kasvattaa, sitä isompi aliutilisaatio liukuhihnalla on mahdollisesti huonossa tilanteessa. Tässä voi ajatusleikkinä miettiä, mitä jos sen piin tilan käyttäisikin esim. Cortex-A32-ytimiin ja lisäisi niitä vähän enemmän. Samanlaiset ongelmat eivät tietystikään tästä hyödy, mutta jokin toinen laskennallinen ongelma voi tehostua. Kumpi sitten on parempi? Se on kai monen tekijän summa ja pitää huomioida softa-tarjonta ja ohj.kielien kehitys yms.

En tarkoittanut tässä yksittäisen implementaation vertaamista kahden tekniikan välillä vaan sitä laajempaa katsausta, mikä onnistuu ja mikä on helppoa milläkin tarjotulla ratkaisulla.

Jos klusterin haluaa rakentaa, pelkästään jo Raspberryjen välillä on melko iso ero, tekeekö laitteen compute moduleista vai täysin varustellusta laudasta. Klusterissa tarvitaan muisti, CPU (ehkä GPU myös) ja väylä ulospäin. Kaikki muu rauta levyllä on turhaa, maksaa ja kuluttaa virtaa sekä vaikeuttaa jäähdytystä.

Lisäksi olisi kiva, jos laitteet voi latoa kätevästi virransyötön ja jäähdytyksen kannalta ja parhaassa tapauksessa esim. laitteet voisi buutata täysin itsenäisesti verkosta ilman sd-korttien kanssa pelaamista, jos esim. jokin kortti vikaantuu tai softabugi pitäisi synkata nodeille kätevästi. Valitettavasti näissä projekteissa on usein menty jo vikaan tässä kohtaa – ei ole osattu valita RPi-vaihtoehdoista sopivinta tehtävään (compute module on suunniteltu nimenomaan laskentaongelmiin). Tässä voi mennä vielä enemmän vikaa jos ostaa halvimman toimittajan sijaan esim. ne 20 lautaa Verkkokauppa.comista ja ostaa 20 x satasen hintaisen starter packin noobs-distrolla ja päälle parit poweroidut deltacon usb-hubit ja etähallittavan 48 portin kytkimen.

Tietty jos haluaa vain askarrella kuluttajaosista klusterin, silloinkin alkup. rautavalinta korostuu hinnassa ja tehoissa moninkertaiseksi, jos nodeja hankkii kymmenittäin. Esimerkiksi Orange Pi+2E on ollut saman hintainen kuin RPi ja tarjonnut tuplasti muistia ja natiivin gigabitin verkon, joka on kovassa käytössä noin 8 kertaa nopeampi sekä tietysti sisältänyt flashia jo valmiina eli muistikortin hinnankin on säästänyt. Myös Odroideissa on ollut tehokkaampaa rautaa melkein samalla hinnalla. Raspberryn eduksi voi laskea sen, että saa tukea paremmin, mutta kannattaako esim. tuhannen euron klusteria lähteä tekemään, jos osaa vain Pythonilla sanoa GPIO1.on() ja GPIO1.off().

Uusimpia markkinaosuus raportteja on juuri ilmestynyt. AMD osuus oli noussut noin 0.2% aikaisemmista mittauksista…

Eli jengi joko jättää ostamatta, tai ostaa Inteliä hinnan noususta huolimatta. Ei ole helppoa tietotekniikkamarkkinoilla jos ei myy Intelin vehkeitä…

Ja lähde oli?

Jaa-a, ekana tulee aina tietenkin mieleen ne Mindfactoryn tilastot, jotka ei millään tasolla peilaa kyllä tuota väitettä (spoilertagit ison kuvan vuoksi)

PassMarkinkin uusimmissa tilastoissa (mitkä eivät peilaa myyntejä vaan ajoja passmarkilla) AMD sai 5% lisää osuutta 3. vuosineljänneksen aikana

Eli tosiaan, @Hannibal lähde ois kiva

Mercury searchin listoja katselin

http://www.mercuryresearch.com/graphics-pr-2017-q4.pdf

Ensi kuussa pitäisi tulla 2018 listat, mitkä ovat varmaan ihan mielenkiintoista luettavaa, koska tänä vuonna AMD prossia on myyty tosi paljon, joka saattaa nostaa AMDn osuutta useammankin prosentin verran… Intel laitteiden määrä maailmassa on vain niin iso, että AMD saisi myydä aivan hillittömästi prossia ja AMD laitteiden osuus markkinoilla ei silti nousisi kovinkaan paljoa.

Eri asia on, jos AMD myy tolkuttoman paljon useita vuosia peräkkäin, niin pikkuhiljaa ero alkaisi tottakai kaventua.

Mercury Research

Mutta isoissa firmoissa ja laitoksissa edelleen vannotaan Intelin nimiin. Korporaatiot eivät kovin herkästi näytä ostavan AMD rautaa työläisilleen työkaluiksi.

Ohessa vähän ennakoita 2018 tuloksista samalta puljulta.

AMD Desktop Unit Share

3Q16 – 9.1%

4Q16 – 9.9%

1Q17 – 11.4%

2Q17 – 11.1%

3Q17 – 10.9%

4Q17 – 12.0%

1Q18 – 12.2%

2Q18 – 12.3%

Nuo teittin lainaamat tilastot kuvaa tämän hetkisiä myyntimäärä, mikä selittää eron. Puhuttiin ristiin hieman eri asioista. Nämä taas laitekantaa.

Mindfactoryn kohdalla kyllä vaikuttanee kovasti se, että ostajat odottelevat jo Intelin uutta prosessorisukupolvea. Sama ilmiö näkyi myös viime ja toissa vuonna.

Toi sun linkkis vie Q4/17 GPU-tilastoihin

Jep… ei ollu suoraan vielä noitten kotisivuilla 2018 tilastoja. Ne siis vasta ensi kuussa. Nuo alkuvuoden 2018 tilastot on nettisivustoilta jotka sanovat käyttävänsä kyseisen puljun tietoja. Ovat ilmeisesti maksaneet, että näkevät ennakoita? ”Pricing for each research product is $9,495.00 USD.” Siksi pistin mieluummin linkin firman omille sivuille, jotta pääsee alkuperäiseen lähteeseen. Ristiin lukemalla ainakin nuo 2017 tiedot oli kurantteja, joten uskoisin myös 2018 tietojen olevan kutakuinkin kohillaan. Mutta siitä varmuus vasta ensi kuussa kun julkaisevat kokonaisraportit sivuillaan.