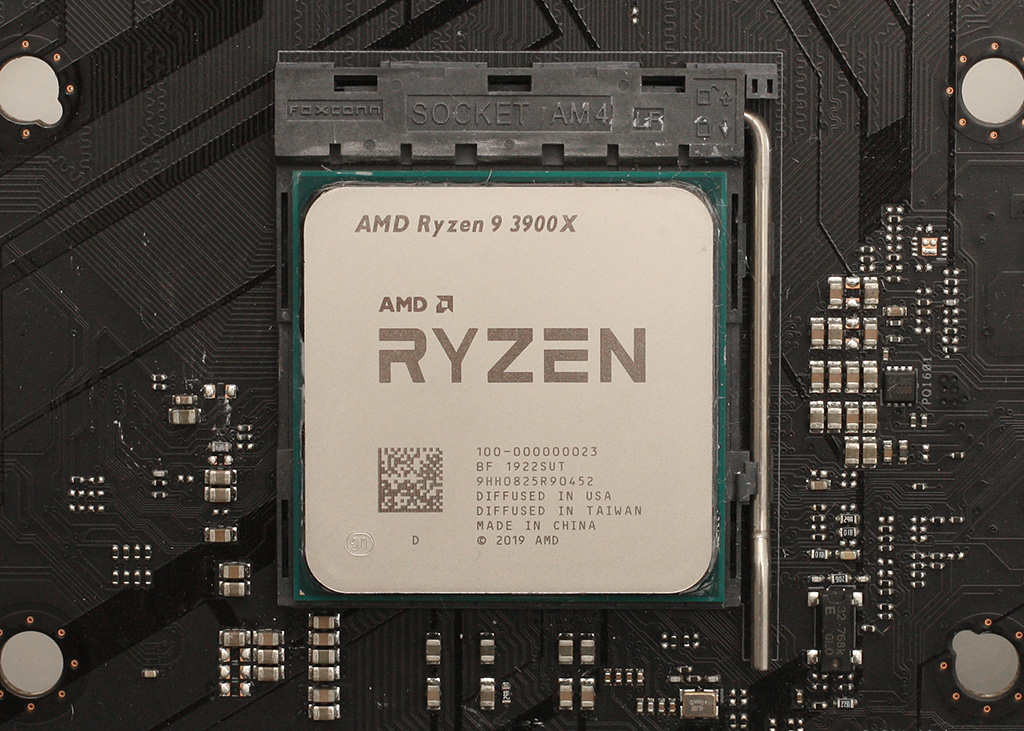

Testissä AMD:n uusista 3. sukupolven Ryzen-prosessoreista 12-ytiminen Ryzen 9 3900X ja 8-ytiminen Ryzen 7 3700X.

Saimme io-techin testiin heti tuoreeeltaan 12-ytimisen Ryzen 9 3900X:n ja 65 watin TDP-arvolla varustetun 8-ytimisen Ryzen 7 3700X:n. Tutustumme artikkelissa prosessoreiden ominaisuuksiin ja perinteisten prosessori ja 1080p-pelitestien lisäksi tutkimme suorituskykyä myös korkeammilla resoluutioilla ja testasimme muistinopeuden vaikutusta suorituskykyyn aina DDR4-4200-nopeudelle asti. Mukana on myös tehonkulutus- ja lämpötilamittaukset sekä ylikellotustestit.

Lue artikkeli: Testissä AMD Ryzen 9 3900X & Ryzen 7 3700X (Matisse)

Pelikäytössä 16gb ihan fine, hyötykäytössä riippuen sovelluksista 32gb tai 64gb tarpeellista. Pelikäyttöön tuskin ostetaan 3900x, vaan jotain max 8 ytimisä kiviä, kun taas 3900x ja 3950x menee suurimmalta osin hyötykäyttöön -> esim. 3600x tai 3700x testaus peleissä 16gb:llä muistia ihan fine, mutta paremmat kivet kuten 3900x ja 3950x testaisin ainakin itse vähintään 32gb:llä muistia, sillä kalleimmissa koneissa sitä tuppaa olemaan enemmän.

Jälleen kerran palaan tähän näytönohjain vertaukseen, nykyään testit tehdään aina mahdollisimman hyvällä näyttiksellä, jotta se ei jää pullonkaulaksi. Vaikka testattaisiin 4 ytimisiä prossuja, niissä on kiinni 2080Ti. Miksi siis testattaisiin pienellä määrällä keskusmuistia, jos isommasta on joissain tilanteissa selvää hyötyä? "Mutta ei peruskäyttäjä käytä 32gb ramia!!!!!" on huono argumentti, sillä "Ei peruskäyttäjä käytä 2080Ti näytönohjainta.".

En usko että kyse on niinkään boostitaajuudesta, vaan siitä että 3900X + Radeon vs 9900K + Radeon tarjoaa korkeampaa fpsää AMD:n prossulla, joka sitten kallistaa prossun nopeuden vaakakuppia riippuen minkän valmistajan näytönohjain on koneessa.

Level1Techsin youtube 5700 XT reviewissä näytti myös oleman sama trendi, esim. 3700X olikin yhtäkkiä ihan yhtä hyvä/hiukan nopeampi mitä 9900K vaikka siinä Shadow of the Tomb Raiderissa.

@Sampsa kiitoksia taas loistavasta artikkelista ja kaikesta jälkipipertämisestä ja lisä testailuista.

Mielenkiintoista tuosa 16 vs 32 GB AIDA testissä on, että CPU on boostaillu eri kellotaajuuksille. Ei näimä ainakaan perus PB / PBO päällä ole helppoa tuo testailu kun boostikellot hyppii eritasoilla samassa testissäkin.

Rupesin aluksi ihmettelemään, että miksi nuo cachejen luvut vaihtelee, mutta sitten honasin eri kellotaajuuden.

Alkuperäisen argumentin maalitolppien siirtely itseään puolustaessa on ainakin hallussa.

Näytönohjainvertailu on ihan ok, paitsi että näytönohjainta vaihtamalla parempaan ne testitulokset oikeasti muuttuvat dramaattisesti.

Jos sampsa ajaisi nuo samat testit 16gb sijasta 32gb, muutos on nollasta muutamaan prosenttiin (kuten edellisellä sivulla näet hänen itse asian todistavan) ja ainoastaan harvoissa valikoiduissa testeissä, mikä ei silti muuta sitä totuutta että tulokset ovat edelleen toisiinsa täysin vertailukelpoiset. Jos kasvatettu muistimäärä muuttaisi oikeasti tuloksia, niin että ne toimisi ns pullonkaulana, niin eiköhän ole melko turvallista olettaa että Sampsa sen ihan varmasti itsekin huomaisi?

Eiköhän pysytä siinä alkuperäisessä argumentissa, eikä siirrellä niitä tolppia sivujen edetessä oman mieltymyksen saavuttamiseksi.

Riippuu testistä. Näytönohjain tuskin auttaa muistitesteissä, tai hyötykäytössä, ellei testi osa GPUta hyödyntää. Vastaavasti muistin lisääminen tuskin auttaa peleissä, jos kaikki muisti ei ole käytössä.

Eli suomeksi, riippuu mitä tekee.

Maalitolppia en koe siirtäneeni, sillä vastasin viestiin, jossa puhuttiin 9900K vs 3900x kellotustesteistä. Nuo ovat täysin hyötykäyttökiviä, tai johonkin striimaamiseen, jolloin yli 16gb muistia on täysin perusteltua. Toki noita voi puhtaaseen pelaamiseenkin ostaa, mutta niin voi vaikka 64gb ramia.

Sulla sen sijaan tuntuu olevan joku ongelma ymmärtää, että jotkin sovellukset Ihan Oikeasti tarvitsevat yli 16gb ramia, tai ihan perus pelailu jos pagefileä ei käytä. Hienoa toki että pärjäät pienemmällä muistilla, jos ei muuta niin vähintään tulee halvemmaksi.

En ole missään kohtaa sanonut ettei kukaan tarvitse yli 16gb rammia. Quotee tekstini jossa sanon niin, älä syötä sanoja. En ole myöskään sanonut ettei missään tapauksessa tarvitse, tai edes lähimaillakaan siihen suuntaan. Ainoastaan että en itse ole tarvinnut, mutta minun mieltymyksethän eivät liity tämän testin tuloksiin mitenkään, eihän?

Kerro minulle, mikä artikkelin testeistä selkeästi hyötyisi yli 16gb rammista niin voin lakata vääntämästä tästä.

En osaa sanoa mikä testi hyötyisi merkittävästi, sen takia kysyin, onko mahdollista tätä testata. Jos tietäisin, tuskin kysyisin? Juuri sanoit, että jotkut tarvitsevat yli 16gb ramia, joten miksi tätä ei testattaisi hyötykäyttöön suunnatuilla kivillä, kuten ehdotin? Se että itse et tarvitse, ei tarkoita, etteikö sitä voisi testata. Testien idea on nimenomaan osoittaa jokin asia todeksi/vääräksi.

Omalla kohdalla voin sanoa, että omassa käytössä Premiere hyötyisi 32gigasta ramia, sillä muistinkäyttö hipoo 100% suurimman osan ajasta. Se, että testataanko juuri sitä skenaariota näissä testeissä, tuskin, siksi annoin yhden esimerkin mitä voitaisiin testata aiemmassa viestissäni – jos olisit sen vaivautunut lukemaan.

Jos kuitenkin tiedostat, että jossain asioissa 32gb ramia on tarpeen, voit varmaan lopettaa vänkäämisen 16gb riittävyydestä. Sinullehhan silloin on täysin yhdentekevää, ajetaanko testit millä määrällä muistia. Itse koen hyötyväni tiedosta, kannattaako missä kaikissa skenaarioissa muistia lisätä.

Aluksi se on tuo ja nyt se on kysymys ja.. Jeps, tämä jatkuisi sivukaupalla ilman että siinä olisi hitusenkaan järkeä, koska muistikapasiteetin lisäämistä eri sovelluksien suorituskyvyn parantamiseksi olisi taas täysin eri kuin uusien prosessoreiden suorituskykyartikkeli.

Seison vaikka nyt korjattuna, jatkossa kaikki artikkelit 64gb muistilla että videon pakkaaminen ja counter strike sujuisi mahdollisimman sutjakkaasti. Kiitos.

Asioiden irrottaminen kontekstista on toki kivaa, siinä tunnut olevan mestari. Tässä alkuperäinen lainaus:

katso liitettä 248209

Puhuttiin kärkiprossuista (3900x ja 9900k), johon vastasin että niitä ei käytetä 16gb muistilla. Toki tämä vähän kärjistettyä, mutta fakta kuitenkin se, että suurin osa noista menee hyötykäyttöön, ja hyötykäytössä monesti 32gb tai enemmän ramia on ihan perusteltua. Minulle kelpaisi loistavasti, että kaikki testit ajettaisiin vain 32gb tai 64gb muistia, olisi ainakin selvä mikä prossu oikeasti on paras, potentiaalinen riski muistin loppumiselle saataisiin poistettua yhtälöstä.

Pelitestit toki voidaan ajaa 16 gigalla muistia, ei ole minulta pois. Mutta jos nyt edes nämä hyötykäyttökivet testattaisiin oikeasti kunnon määrällä muistia.

Jätetään tämä mieluusti tähän, Sampsa voi testata komponentit kuten haluaa, itse lähinnä esitin toivomuksen.

Arvelen että muistiasia on nyt jo käsitelty tarpeeksi hyvin, kun alkaa tulla jo toistoa.

Ihan mielenkiintoinen asia selvittää miten vaikuttaa mihinkin. Uskon että @Sampsa nyt tiedostaa asian ja tekee johtopäätökset mitä kannattaa jatkossa testata. Jotta tulokset olisivat vertailukelpoisia, niin luulisin että testipenkki pysyy vakiona johonkin päivämäärään asti ja muistimäärän tarve arvioidaan uudelleen kun ajetaan seuraavat referenssit uusien testien pohjaksi. Ettei vaan tulisi uusien tuotteiden mittauksiin 3,7% parempia tuloksia pelkästään muistimäärän takia (Handbrake), joutuisi ajamaan vanhalla raudalla vertauskelpoiset tulokset. Sitähän monet kaipaa, tietoa kannattaako päivittää.

Esimerkillistä toimintaa kyllä io-techiltä reagoida käyttäjien palautteeseen ja hypoteeseihin, ajella extra testejä eri biosseila, muisticonffeilla jne. Siinä kuitenkin menee melko paljon työaikaa käydä foorumia läpi ja sitten sätää testipenkin kanssa. 🙂

Vahva tämä, ja siitä suuri kiitos toimituksen suuntaan.

Toisaalta yllä mainitsemasi asiat ovat tämän tämän sivun olemassa olon tarkoitus ja kuuluu työnkuvaamme 🙂

Ovatko nuo DDR4-3200 CL14-muistit tosiaan noin kalliita? Sikäli kun pikaisesti vilkaisin, niin Jimmsillä DDR4-3200 CL14 16GB ja DDR4-3200 CL16 32GB ovat lähes samoissa hinnoissa.

OT: Niiden valmistus on lopetettu, että hinnat todennäköisesti ei ainakaan alaspäin mene..

32GB testi oli mukava lisä, näkee ainakin, ettei muistiohjain kyykkää täysin kun Ryzeneiden kanssa on puhuttu niin paljon muistien merkitsevyydestä suorituskyvyn suhteen.

Se mikä oikeastaan kiinnostaisi on tuo 4×8 kamman (vaikka noiden flarex) käyttö x470 emolla.

Ei tosin taida olla ihan ajantasalla vielä kun biosit kuten crosshair VII:n kohdalla on niin raakile, että voikohan sitten 3000-sarjan ryzenillä ns. maksimoida muistin myös neljällä kammalla (eli tuonne 3600+ cl14 viritys). Lähinnä tietäisi että kannattaako tuohon 2 kampaa tulevaisuuden varalle ostaa, vaiko kuitenkin haaveilla 2x16gb moduuleista sitten tulevaisuudessa.

Itse ainakin pyrin eliminoimaan/disabloimaan swappauksen kokonaan suorituskykysyistä. Kun siirryn pelistä selaimeen ja takaisin niin siinä ei saa olla latailua välissä. Linuxiin en ole viimeisen kolmen diston asennuksessa luonut swap osiota ollenkaan koska ei ole pakko.

Itselle käytänönläheinen esimerkki olisi 4k Drone videon renderöinti esimerkiksi Sony Vegasilla (varmasti muukin vastaava käy) youtube 4k rajoituksien sisään. Semmoiseen menee itsellä paljon aikaa, kun samoja klippejä tulee hierottua moneen otteeseen ja vaatii prosessoria. Uuden Mavic pro 2 raaka videot voisi olla hyvä kohde bittivirran puolesta ja käytännön läheinen monelle tänäpäivänä ja plussa vähän sinun videota isompi bittivirta (60 vs 100Mbps).

Täältä saisi joitakin DJI Mavic 2 Pron raakoja pätkiä ladattua. Näistä yhdistelemällä saisi muutaman minuutin hyvän testi clipin, että pääsisi prosessori kunnolla töihin (harvoin tulee alle minuutin pätkiä renderöityä).

Eli jos tuolta lataisi noita 4k @100Mbps clippejä, yhdistäisi muutaman ja renderöisi ne youtube rajoituksien/suositusten mukaan 45Mbps 4k formaattiin yhtenäiseksi clipiksi, testinkannalta tietenkin miten parhaaksi näkee (youtube suositus 4k 24/30fps videolle = 35-45 Mbps). Omien kokemuksien mukaan korkeampi lopullinen bittivirta myös matalampaa raskaampi renderöidä.

Väite taisi olla että nvidian kanssa ei boostaa yhtä korkealle ja aiheuttaa WHEA virheitä.

Siis ihan yleisesti et miten käyttäytyy mädin kanssa

Ja tää

Samsung B-die valmistus lienee lopetettu, mutta Samsung M-Die pohjaisia kampoja on tulossa 3600CL14, 3200CL14, joten kun nyt kanavassa lojuvat B-die -pohjaiset poistuvat , niin M-die (ja tietysti Hynix/Micron) korvaavat. Hinnat elävät nyt varmaan enemmän kysynnän/tuotannon funktiona ja kyllä tuotanto on vieläkin kasvussa, joten hintojen ennustetaan laskevan (lähde. DRAMeXchange).

Tokihan jos jotain hyötysoftia aletaan todenteolla testaamaan niin tottakai aletaa löytämään eroja muistimääriltä. En vain tiedä onko kyseessä enään puhdas prosessoritesti. Esimerkkinä unreal enginen compile, jossa ilmeisesti muistitarvi on noin 1GT/thread. Tosin tälläisiä ohjelmia työökseen ajavat todennäköisesti omistavat HEDT platformin.

Olisi ison muistimäärän testissä (ja sen käyttävässä softassa) ehkä ideaakin. Sellainen rääkkää muistiohjainta ja cachea vähän eri tavalla, mitä muut testit. Itse kyllä tyytyisin johonkin 10Gb projektiin 16Gb rammilla. 32Gb ja isompiin muistimääriin mennessä joudutaan usein tiputtamaan muistien nopeutta. Joten sitten joko heikennetään muita testituloksia, tai on oltava erillinen konffi yhtä testiä varten.

Ajatustasolla kiva, mutta tuota pitäisi vähän testailla tekin labrassa, eli saako sillä eroja syntymään, vai onko testin hyötyarvo lähellä nollaa.

Ennen testattiin piirisarjojen eroja, north bridge, south bridge, muut piirit. Osasi olla suuria eroja paljonko joku väylä rasitti prosessoritehoa. Esim. joku halpa usb3-lisäkortti saattoi hidastaa konetta merkittävästi, sama integroitujen kanssa. Nyt tietysti osa on integroitu prosessoriin ja emolevyillä osat alkaa olla aika standardikamaa, liekkö enää tarvetta testata eri skenaarioita muuten kuin löytääkseen heikkouksia ja vahvuuksia Intel vs. AMD?

Jos teesi pitää paikkansa ja todetaan vartavasten tehdyillä testeillä, niin lähtisi kyllä iotech leviämään ympäri nettiä 😀

Näin tokkiinsa on, mutta ei ole 2,5v riittänyt vielä kadottamaan muistista Muron lopunaikojen "Otava lamaa" joten lämmittää mieltä. Varsinkin kun saan vähintään viikoittain ihmetellä ja kiroilla töissä noiden penniä venyttävien ekselimiesten touhua.. ei ihan harvoin ole kun säästetään juuri siitä mitä olisi prkl tarkoitus asiakkaalle tarjota ja mistä ei voi säästää suututtamatta asiakasta. :facepalm:

Mitäs tuo boldattu kohta oikein käytännössä tarkoittaa? Itse ainakin ajelen muisteja bios:n asetuksissa juuri sillä luvulla, jolla ne olen ostanut.

Sitä että emolevyllä voi toimia esim. 2x8gb 4600Mhz CL17-18 kammat, mutta jos lyö kaks lisempää niin ei saa enää kuin jotain 3600-3900Mhz irti, riippuu emolevyn muistisignaloinnista ja muistikanavien johdotukseta t-topology vs. daisychain.

Tai sitten jos ostaa 16gb dual-rank kampoja niin muistinopeudet on pienempiä tai "katto matalemmalla" jos ryhtyy niitä muistejaan kellottamaan ja vertaa singlerank kampoihin.

16gb (dual rank) kammat on raskaampia muistiohjaimelle, mitä singlerank, joten kellot jää alhaisemmiksi. Neljä kampaa on myös muistiohjaimelle kahta raskaampi ja useammat emolevyt alkaa olla daisy chain muistiratkaisulla (singlalointi pääslotille ja siitä hyppy toiseen slotiin. Harvinaisemmassa T-topologiassa kaikki slotit on yhtä hyviä, mutta yleisemmän kahden kamman toimivuus on suhteessa huonompi), jolloin ne toimii parhaiten 2 kamman konffilla.

Käytännössä jos haluaa vetää muistikellot ja asetukset maksimiin, on käytettävä kahta single rank muistikampaa. Eli 2x8Gb konffia. Esim 1-2Gen ryzeneillä 3466-3600mhz oli saavutettavissa kahdella kammalla, mutta muilla konffeilla alettiin olla 3200-3333mhz maksimeissa. Sama intelilläkin, kellotaajuudet on vain korkeammalla.

Aijaa, kaikenlaista sitä onkin. Olen ihan tyytyväisenä ajellut 4:ää kampaa 3600mhz:lla jolla ne ostinkin. Ei tullut pieneen mieleenkään, että se voisi aiheuttaa jotain ongelmaa. Hwinfo tosin väittää taajuudeksi 1800mhz. Onko siinä nyt tuo ilmiö sitten kyseessä? Luulin sen olevan vain idle-käytön seurausta.

Tuo 1800mhz on muistin oikea taajuus. DDR (double data rate), eli muistia käsitellään kellopulssin nousevalla ja laskevalla laidalla. Joten käytännön nopeus on 2x fyysinen kellotaajuus. Joten 1800mhz on käytännössä 3600mhz.

Millä tuollaisen single rank muistin oikein tunnistaa, kun sitä ei hirveästi näköjään huudella myyntiesitteissä?

Nykyään käytännössä lähes kaikki 8Gb muistikammat on singlerank. Ihan ddr4:n alkuvaiheessa tehdyt 8Gb kammat voi olla dual rankkia. 16Gb kammat on lähes aina dual rank.

Ok, mutta jos siis nyt haluan löytää sellaisia 16gb kampoja, niin miten löydän ne?

Kannattaa muistaa, että suuremmalla rankkien määrällä rammi voi potkia todella hyvin, vaikka MHz ja CL olisivatkin huonommat: Benchmark Results & Final Analysis – G.Skill Ripjaws V DDR4-3200 C16 16GB Dual-Channel Kit Review: Gray-Area Memory

Argh, fine. Mennään takaisin aiheeseen. Tyydyn näihin kunnes tulee aika ostaa amd:tä nykyisen koneen tilalle ja katsotaan tilanne silloin uudelleen.

Googlella. Noita on keräilty sinne tänne. Esim tässä, b-die finder.

Varmasti suurin osa näistä "toimii huonosti NVIDIA ohjaimen kanssa" viesteistä perustuu redditin AMD ryhmään.

Siellä kun oli posti ensiksi että NVIDIAn näytönohjain heittää WHEA erroria (Windows Hardware Error Architecture) HwInfo64 ohjelman mukaan X570 alustalla, kun käytössä on PCI-E 4, mutta ei X470 alustalla PCI-E 3:sen kanssa, ja että tämä voisi aiheuttaa hidastelua, ja heikompia tuloksia. Espanjalainen sivusto Xanxo Gaming törmäsi tähän kun Pcmark 8 ohjelma ei suostunut rullaamaan läpi, ja alkoivat katsomaan läpi error logeja.

Tämän lisäksi heidän prossu ei päässyt boost kelloihinsa. Eli sitten vedettiin johtopäätöksiä että tässä on ehkä yksi, tai kaksi eri, ongelmaa.

Sitten tämän jälkeen joku kokosi redittiin hieman kyseenalaisen Tomb Raider graafin mikä "näyttää" että NVIDIA näytönohjaimet saisivat paljon huonompia tuloksia Ryzenilla.

AMDn edustaja on kommentoinut tuota Tomb Raider graafia redditissä seuraavasti:

This chart combines three different sources into a single chart. The three reviewers may or may not have used the same settings or scene(s). We're going to look into this out of an abundance of caution, but I would preemptively warn that this data and/or thesis may not be valid. Let's not get ahead of ourselves.

Joten tuskinpa tuossa mitään testattavaa on, mutta jos haluaa kaikkia mielyttää niin kyseessä on siis kahdesta eri "ajatuksesta". NVIDIA ja Ryzen on hidas PCI-E 4 erroreiden takia (esim. koska NVIDIAn ajurit eivät toimi oikein PCI-E Gen4 alustalla, mutta AMDn kyllä, tai jotain muuta vastaavaa), ja toinen on että boost kellot eivät toimisi.

Tämä vielä offtopiccina. Dual rank on nopeampaa, kuin samalle taajuudelle kellotettu single rank, johtuen tästä: "Multi-rank modules allow several open DRAM pages (row) in each rank (typically eight pages per rank). This increases the possibility of getting a hit on an already open row address. The performance gain that can be achieved is highly dependent on the application and the memory controller's ability to take advantage of open pages."

Ne eivät vain kulje yhtä kovaa, kuin single rank muistit. Joten molemmat huippuunsa viilattuna singlerank on nopeampi.

Pelikäytössä varsinkin Windowsissa lienee ihan perusteltua kytkeä pois swap. Linuxissa swappiin menee oletusarvoisella swappiness-määrällä aika rajallisesti tavaraa. Pitää olla lähemmäs 16 gigaa käytössä, että swappiin menee tuntuvasti aktiivisen pelin dataa. Myös jos swappiin on mennyt jotain taustaprosessien sivuja, eivät ne sieltä itsekseen palaudu kesken pelin. Eli jotain nykimistä voi ilmetä pelin aikana, mutta se saattaa loppua pelin oltua käynnissä. Yksi vaihtoehto on myös lz4-pakattu zram. Linuxissa on se huono puoli, että jos muisti loppuu kesken, systeemi hirttää kiinni todella pahasti. Joten pitää olla hyvin varma, että fyysinen muisti ei missään kohtaa ylity, käyttää swappia tai valmistautuu OOM Killerin aktivoitumiseen. Linuxissa on sekin hyvä, että jossain Steam OS -tyylisessä käytössä se varsinainen käyttis ja launcheri ei kuluta kuin ehkä 300 MB muistia, jolloin pelille jää aika hyvin. Siitä 300 megasta voi pelin aikana ison osan pistää swappiinkin, jos tarvii levy-cachea varten tilaa. Jostain syystä steam os kyllä ilmoittaa linux-pelien vievän jopa enemmän resursseja, mutta minusta heillä on aika pessimistinen tapa arvioida noita.

Njaa sen verran kauan kun viimeeksi käyttänyt toosaa, etten tiedä miten asianlaita nykyään on. Mutta siis ennen muinoin oli toosassa softia, jotka eivät edes toimineet ellei koneella ollut sivutusosiota. *nix puolella taas swappi on sama olla jonkin kokoisena. Määrittelee vain swappiness arvon niin pieneksi, ettei sitä juuri koskaan käytetä ennen kuin on viho viimeinen pakko.

Fyysisesti helpoin tuntomerkki on se, että muistipiirejä on vain toisella puolella kapulaa. Tosin jos niitä on yhdellä puolella kahdessa rivissä niin menee coinflipiksi. Eli edelleen parastapa valmistajan nimi + mallinumero googleen ja specislapusta katsoo.

Valitettavasti joitakin softia ja pelejä ovat jotka saattavat levähtää käsiin wintendon swapin puuttumisesta. Tosin jos sitä sallii esim 1-2G swappia ja rammia on oikeast iriittävästi niin wintendo on aika konservatiivinen sen swapin käytön suhteen, jos sinne nyt yhtään mitään päätyy niiin se on varmasti jotain kauan taustalla idlannutta skeidaa. Jos nyt ei HDD:n päällä aja käyttistä/swap osiota niin ei huomaa mitään, yleensä se käyttää sitä sitten 0-200MB sille taustaroskalle.

Joku voisi joskus antaa esimerkin yhdestä softasta joka leviää käsiin jos swappia ei ole (olettaen että muistia on reilusti).

Ohjelmathan eivät sitä swappia käytä (ellei photoshopin scratch-diskejä jne. lasketa), vaan ne ainoastaan pyytävät käyttöjärjestelmältä muistia ja se sitä niille tarjoaa.

Vanhemmat PRO/Engineer cad softat ei suostu käynnistymään jos swappi ei ole käytössä ja sitä ei ole riittävästi, riippumatta siitä paljonko keskusmuistia koneessa on. Hauskoja juttuja kun lisenssien kalliuden vuoksi ei ihan joka vuosi(kymmen) voi työkaluja uusia.

jatketaan OT:ta.

Mikä siitä swapista tekee niin ikävän, että sen kanssa pitää kikkailla?

Ei jatketa enää, tästä voi perustaa keskusteluketjun rauta-alueelle mutta tässä kommenttiosiossa keskitytään jatkossa näihin prosessoreihin ja niiden testituloksiin.

Tämä ketju on ollut testitulosten julkaisun jälkeen suurimmalta osin pelkkää ihmisten keskenään painimista. Kuka on oikeassa, kuka on mitä mieltä, missä on vika, kun ei miellytä joku asia itseä jne. Eihän tälläsiä vänkäämisiä tarttis tähän kyseiseen ketjuun enää yhtään lisää. Menee ketjun alkuperäinen tarkoitus aivan hukkaan, kun 12 sivusta 6 sivua on kaikkea muuta meuhkaa joka suuntaan. Ei ole mielenkiintoa seurata vääntöjä missä jokaisella on omansa.

Tämä seuraava on sitten oma mielipide. Itse ainakin odotin tuloksia, niitä myös sain. Kiitos @Sampsa @kumppanit jotka testiä oli tekemässä, koska pitää arvostaa sitä työmäärää mitä tälläisen projektin testaaminen vie aikaa. Tilanne on se mikä on tällä hetkellä. Tulevaisuus näyttää, että missä kohtaa voi tulla korjauksia niin, että alkaa esim. Boost kellot olemaan siellä mitä AMD on esittänyt. Maltti on valttia toivottavasti. Olen silti yllättynyt miten hyvin jaksaa vetää noillakin kelloilla millä on testit saatu ajettua läpi.

Reddit päivitystä:

Update: Manuel and the Nvidia driver team notified us that they were able to reproduce the problem and are looking into it, so no need to send anymroe information their way.

Tässä siis kyse WHEA erroreista kun käytössä PCI-E Gen4, mutta jotkut raportoivat että samoja löytyy myös AMDn näytönohjaimilla,

eli tuskinpa aiheuttaa suorituskykyongelmia, mutta jos niin sattuisi olemaan, niin ainakin NVIDIA on asiasta tietoinen ja tutkii asiaa.