Intelin 10 nanometrin valmistusprosessi on matkannut ongelmasta toiseen ja on nyt jo yli kaksi vuotta jäljessä alkuperäisestä aikataulustaan. Viime aikoina yhtiön roadmapeissa on pyörinyt Ice Lake -koodinimellinen prosessori, jonka on vihdoin tarkoitus tuoda 10 nanometrin valmistusprosessi massatuotantoon.

Intelin aiempien roadmappien mukaan Ice Lake -arkkitehtuuriin perustuvien prosessoreiden piti tulla työpöytä- ja palvelinpuolelle vuoden 2020 aikana. Vuoden aloittaneilla CES-messuilla yhtiö puolestaan kertoi tuovansa Ice Lake -arkkitehtuuriin perustuvat U-sarjan prosessorit myyntiin vielä tämän vuoden puolella.

Nyt Tweakers-sivusto on saanut käsiinsä kaksi roadmappia, jotka heittävät kylmää vettä 10 nanometrin odotukselle. Roadmapit ovat tulleet kahden eri lähteen kautta, mutta ne ovat peräisin samasta Dellin diapaketista.

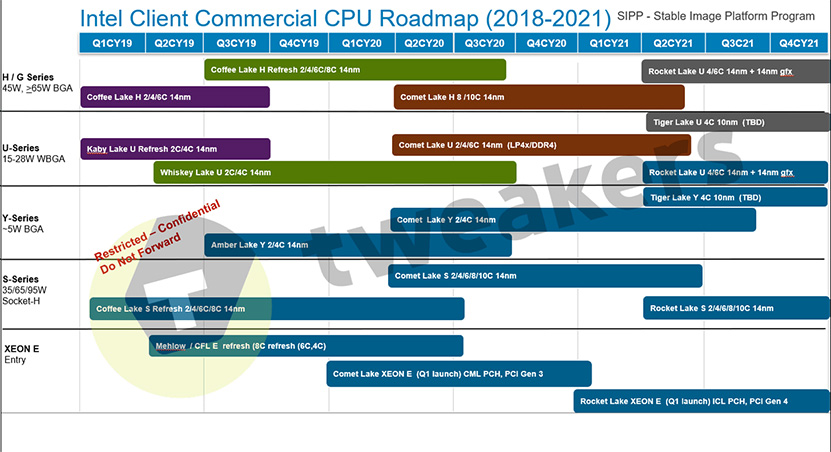

Vuotaneiden roadmappien mukaan 10 nanometrin valmistusprosessi ei ole tulossa työpöytäpuolelle lainkaan ennen vuotta 2022. Roadmapin mukaan S-sarjaan eli työpöytäpuolelle on seuraavaksi luvassa 14 nanometrin Comet Lake, joka julkaistaisiin ensi vuoden vuosineljänneksen aikana, jonka jälkeen vuorossa olisi vuotta myöhemmin julkaistava Rocket Lake niin ikään 14 nanometrin prosessilla valmistettuna. Sekä Comet Lake että Rocket Lake tulevat sisältämään parhaimmillaan 10 ydintä. Xeon E -sarja noudattaa työpöytäpuolen mallia noin neljänneksen aikaistetulla aikataululla. Ainakin Xeon E -sarja tulee saamaan PCI Express 4.0 -tuen Rocket Laken myötä vuonna 2021.

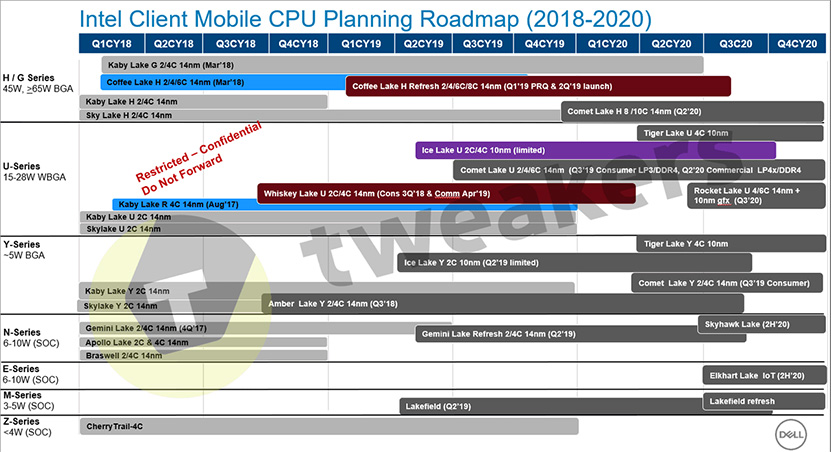

Kannettavien puolella tilanne näyttää vähän paremmalta. Roadmapin mukaan Intel tulee todellakin julkaisemaan U- ja Y-sarjojen vähävirtaiset Ice Lake -prosessorit tänä vuonna ja jopa selvästi ilmoitettua aiemmin eli kuluvan neljänneksen aikana. Samassa roadmapissa ainakin osa palkeista alkaa siitä, kun valmistaja saa prosessorit tuotantokäyttöön, joten on mahdollista että varsinaiset Ice Lake -kannettavat tulevat saataville vasta vuoden loppupuolella, kuten Intel totesi CES-messuilla. 10 nanometrin tilanteen kannalta sekä Ice Lake-U että -Y tulevat saataville vain rajoitetusti. Toistaiseksi ei ole varmuutta, puhutaanko Cannon Lake -katastrofin kaltaisesta rajoitetusta saatavuudesta, vai jostain lievemmästä. Ice Lake-Y -prosessorit ovat tuplaytimisillä kun -U-prosessorit tulevat saataville 2- ja 4-ytimisinä.

Ensimmäiset täydellä volyymillä markkinoille saapuvat 10 nanometrin prosessorit Intelin vuotaneissa roadmapeissa ovat Tiger Lake-U ja Tiger Laky-Y, jotka tulevat saataville näillä näkymin vuoden 2020 toisella neljänneksellä toisen roadmapin mukaan, mutta tässä lienee jälleen kyse ajankohdasta jolloin valmistajat saavat prosessorit käsiinsä, sillä kaupallisen puolen roadmapin mukaan samat prosessorit tulevat saataville vasta vuotta myöhemmin, tosin epävarmuutta viittaavalla ”TBD”-merkinnällä (To Be Decided/Determined).

Yksi mielenkiintoinen yksityiskohta kaupallisen puolen roadmapissa on Rocket Lake-U -prosessorit, joiden perään on merkitty erikseen 14 nanometrin 4- – 6-ytimisten prosessoreiden rinnalle 14 nanometrin grafiikkaohjain. Ratkaisu voisi viitata Intelin siirtävän Xe-arkkitehtuurin myötä ainakin osan integroiduista grafiikkaohjaimista erilliselle pikkusirulle, joka voitaisiin valmistaa tarvittaessa eri prosessilla kuin itse prosessori.

Lähde: Tweakers

Uskon että halvalla niitä tullaan myymään ja siten pyritään parantamaan markkina-asemaa.

Konsolipuolilla kehitys on kumminkin se, että aletaan iskeä 8 ytimisiä prossuja konsoleihin. Eiköhän aika pian aleta näkemään pelejä mitkä osaavat hyödyntää yli neljää ydintä.

Konsoleissa on ollut 8-ytimiset prosessorit vuodesta 2013 lähtien :kahvi:

Jep. 'Laitteisto AMD Fusion ”Jaguar” 8-ytiminen x86-64 AMD APU'

PlayStation 4 – Wikipedia

Että siihen nähden ei ole tapahtunut hirveän nopeasti mitään…

Jospa playstation 5 muuttaisi asiaa koska 'These are our current spec predictions based on rumors and what was revealed by Mark Cerny – CPU: 8 core/16 threads at 3.2Ghz with a Zen2 architecture'

PS5 Specs – CPU, GPU, Memory & The Future of Gaming

(Pätkin hitusen tuota sushukka:n postauksen lainausta.. pysynee oma teksti vähän tiiviimpänä)

Näitä sensaatioita juu on, kun monissa perus serverisovelluksissa ARM toimii varsin energiatehokkaasti (esim perus webserverit) ja opensource vipattimet varsinkin on jo käännetty ARM:lle. ARMilta puuttuu hostaus ekosysteemi joka hidastaa adoptiota. Ylläpito tarvitsee hyvät etähallinta työkalut ja ne pitäisi vielä saada integroitua nykyisiin, on tympeää puljata n+1 työkalulla. AWS liene tehnyt omat, kun nyt myyvät ARM palvelimia.

Tuossa on tärkeä pointti, moni softa lisenssoidaan per vuosi per core, jos ARM ei saa jotain lisenssointi hyvitystä, ei varmasti yleisty. Jos taas saa hyvitystä, niin tulee lisenssointi sotku, koska myös ARM on tuomassa raskaampia coreja saataville jotta pääsevät sinne saliin…

Kuten tuossa mainitsin, monet perus jutut voi kääntää ARM:lle (tai yleensä löytyy esikäännettynä ihan distron mukana). Vaan sen lisäksi että tiettyjä softia pitäisi portata tai ainakin optiomoida ARM:lle joka vaatii töitä, niin veikkaampa että Intel / IBM saralta saatetaan hieman painostaa, että mitäpä jos ette alkaisi moiseen. 🙂

Paljon saa tapahtua, että ARM syrjäyttää x86 tai muuten vain valtaa salia, koska myös Power on nykyisin avoin kehitykselle, ja sille on valmista infraa, hallintatyökaluja ja softaa. Toinen mielenkiintoinen vastapaine tähän on Intelin suunitelma luoda oma big.LITTLE tyyppinen heterogeeninen core rakenne, se päätyykö se ikinä saliin on toinen juttu.

Kuten tuossa jo todettiin niin on niissä ollut jo aika kauan. Ei se varsinaisesti siitä ole kiinni etteikö sitä rautaa olisi ollut, enemmänkin siitä että niiden lisäytimien järkevä/tehokas hyödyntäminen on vaikeaa.

Kyllä se on ihan täysiverinen 8-ydin, ei ole mitään bulldozerin kaltaista. L3-välimuisti vaan on jaettu neljän ytimen kesken kuten zenissäkin.

Kannattaa katsoa Nvidialta, miten rahastukset hoidetaan.

Ensimmäisissä julkaisuissa on "Founder's Fee", jolla otetaan rahat pois ennakkotilaajilta, ym. Sitä vaan naamioidaan paremmin nykyään.

Myös siinä ensimmäisessä julkaisussa julkaistaan vain pari huippumallia. Niistä sitten maksimivoitot ja vasta myöhemmin tiputellaan niitä keskiluokan malleja markkinoille, joilla on se parempi hinta/laatu-suhde.

Näin saadaan julkaisuaikataulu pidettyä + fanit tyytyväisenä. Sitten ne huippumallien hinnanalennukset (normaalitasolle) voi tehdä kauniisti sitten, kun kilpailijat saavat jotain ulos. Jos eivät saa, niin hinnan voi jättää korkealla ja ottaa hyvät katteet.

Joo mutta ei SMT tukea joka nyt olisi tulossa huhujen mukaan myös konsoleihin. Lisäksi noissa konsoleissa peli ei saa käyttöön kuin maksimissaan 6 ydintä, yksi varattu kokonaan OS:lle ja toinen muun sonnan pyörittämiseen.

Pitää tarttua tähän sen verran että riippuunee pitkälti minkälaisesta serveritoiminnasta puhutaan, varmasti totta monen "enterprise" palvelun kohdalla.

Mutta jos puhutaan esim. perus webipalvelimesta, softapuolella ajetaan vieläkin paljon apassia ja nginx:iä liimaksin päällä ja nuo kyllä on löytynyt arm-käännöksinä "aina", kuten varmaan valtaosa muistakin liimaks-softista.

Juu nvidian hinnoittelu ja julkaisupolitiikka on oikein hyvä esimerkki ylihinnoittelusta, kun ei ole kilpailua.

Voisin veikata ettei tämä Intelin säätö tässä vaiheessa vielä kauheasti vaikuta MAD hinnoitteluun, mutta jos sama jatkuisi vuosia niin toki. AMD haluaa kuitenkin kaapata Intelin markkina-asemaa ja saada itselleen taas leiman "hyvänä ja varteenotettavana" vaihtoehtona. Siitä on vielä pitkä matka ensisijaiseksi tuotteeksi, johon kilpailijaa verrattaisiin.

Eli ei tuolla Intelin 10nm sekoilulla vielä tässä vaiheessa ole niin järkyttäviä seurauksia. Jos firma olisi samassa jamassa kuin AMD oli pari vuotta sitten niin olisi suoraan konkka edessä. Intelillä on rahaa millä jatkaa. Lähinnä tuo käy pahasti imagon päälle kun ei ollakkaan enää "paras mitä tarjolla" vaan kilpailija menee ohi. Se on "uusi" asetelma Intelin nykyisille henkilöille. Edellisestä kerrasta on pitkä aika ja enää ei voi pelata ihan niin törkeää peliä esim serveripuolella. 🙂

Luepa uudestaan. Vertasin Intelin 10nm:ää (uutisen aihe) muiden 7nm:ään, ei 7nm vs toinen 7nm..

PS3:ssa oli jo 2006 yli 8 ydintä. SPE-apuprosessorit ovat ihan itsenäisiä ytimiä ohjelmalaskureineen ja rekistereineen toisin kuin esim. 'CUDA-coret', jotka ajavat samaa käskyä. Tämä nyt menee sitten hiusten halkomiseksi, jos jollain on tarkempi määritelmä ytimelle, joka kattaa vain x86:t ja vastaavat.

Kyllä. Intelin 10nm ei voi verrata muiden 7nm sen prosessin "vaikeudessa", koska Intelillä oli huomattavasti kunnianhimoisempi tavoite. Nyt vain näyttää siltä että yrittivät haukata kerralla liian ison palasen.

Eli muiden 7nm on paljon helpompi saada valmiiksi kuin Intelin 10nm, vaikka tiheydeltään ovatkin lähellä toisiaan. (tämä siis "nykytiedon" valossa, eli aika huteralla faktapohjalla)

Tuskin vaikuttaa. AMD:lle on nyt tärkeintä saada näkyvyyttä ja markkinaosuutta eikä sitä saada hintoja nostamalla.

En löytäny uutista asiasta, mutta mielenkiintoista jos Samsung aikoo tosissan panostaa piirivalmistukseen.

Tarkoittaako tuo jotain arm tyylistä prosessoria vai mitä, aika näyttää.

Samsung plans $116 billion investment in non-memory chips to challenge TSMC, Qualcomm – Reuters

Niin no johan kuiske käy kovasti että Intteli valmistaisi dGPU:t simsungilla. Lähteny liikkeelle tästä

Samsung on ollut jo pitkään tuotantoprosessin osalta aivan terävintä kärkeä.

Osaavat kyllä valmistaa kun Apple/Qualcomm/muu lyö arkkitehtuurin eteen että "saatteko tehtyä"? Ei Exynokset nyt mitään huonoja ole, mutta ehkä 6kk usein perässä kärkeä.

No näinpä. Isoilla softatoimittajilla osalla nyt tuppaa olemaan kertoimet eri prosessorimalleille, mutta ei niistäkään kovin monisyisiä voi tehdä tai muuten niitä ei tulkitse enää kukaan ja ostohousut voi jäädä senkin takia kaappiin.

Kuten myös itse totesit, niin suuri osa palvelimista pyörii nykyään jonkun virtualisointikerroksen päällä ja siihen kerrokseen on vaikea alkaa eri arkkitehtuureja sotkemaan. Senpä takia sitten yritetään luoda erilaisia päällystakkeja, joilla voitaisiin keskitetysti hallita eri arkkitehtuureja. Omana polkunaan sitten vielä mikropalvelut, mutta niilläkin tahtoo olla vielä hankaluuksia siirrettävyyden kanssa eri arkkitehtuurien välillä. Niin tai näin, kyllä noista sekametelisoppa syntyy eikä ARM:lla tunnu olevan vielä mitään selvää kilpailuetua millä kangeta nykyisiä toimijoita pois paikaltaan. Virransäästö on kiva, mutta ei sillä yksistään vielä pitkälle pötkitä.

Juu, mutta miksi käyttää ARMia näiden samojen perussoftien pyörittämiseen? Hinta, virrankulutus, joku muu? Kapasiteetin ostajaa harvemmin kiinnostaa muu kuin hinta ja jos nyt jostain peruswebbipalvelimesta puhutaan, niin ei siinä paljoa säästöä tule ajaa sitten vaikka vohveliraudalla.

Totta tämäkin. Samsung kuitenkin tehnyt yhteistyötä myös GF:n ja IBM:n kanssa, joilla myös jonkunlaista osaamista alueelta. Varsinkin IBM:llä tuntuisi aina olleen aika pätevää porukkaa tällä rintamalla ja nyt ymmärtääkseni jatkavat Samsungin kanssa yhteistyötä prosessien kehittämisessä kun GF ilmoitti hyppäävänsä pois nanometrikilpailusta.

Niinno, ehkä se on sitten vain kuusi ydintä, mutta eikös samaa tehdä myös PC:llä? Winkkari ei ehkä vie yhtä corea, mutta varmasti osansa + se muu sonta jota luulisi PC:ssä suhisevan vielä enemmän kuin konsolissa (virustorjunnat, selaimet, geforce experiencet, emon/hiiren/näppiksen "apuohjelmat", twitchit, skypet…onpas noita tässäkin koneessa… :(). Mutta joo, pointtina varmaan että pelintekijät ovat voineet olla varmoja tällä rajavedolla että heillä on se kuusi corea oikeasti käytettävissä koko ajan. Olisikin hauska nähdä core-utilisaatiokäppyrät PS4:n ajaessa vaikka bäfää. Onko se yhden coren tapissa menevä viiva vai onko tasaisempaa sahalaitaa kaikkien ytimien välillä?

No oikeastaan ajattelin ihan bare servereillä kikkailua, eli esim deployataan kone default linux imagella ja tiputetaan sovellukset "jollain", olkoot se nyt ansible, docker tai mikä tahansa virveli joka hoitaa palvelimen + oman softan + dependencyjen + conffien laiton paikalleen.

Itse en ainakaan ARM raudalla mitään virtualisointikerrosta ajaisi (jos ees kunnon sellaista on), syö x86:llakin ihan stanasti välistä. (Powerilla taas ei voida oikeastaan puhua virtualisoinnista kun se on lähempänä partitiointia.)

Jos siis palataan siihen ihan raudan hallinointiin se on rasite jos sulla on Intelin servereiden hallinointi järjestelmässä A joka toimii jotenkin. AMD pannuston järjestelmässä B joka toimii myös ja sitten otat siihen ARM pannut joiden etähallinta järjestelmä C toimii tai sitten ei toimi.. tai on raakile. Monesti myös Intel ja AMD käkättimet saa samaan järjestelmään.

Ylläpidolla menee hankalaksi jos on näitä järjestelmiä n+1 koska sitten johonkin pitää itse pitää kirjanpitoa että mistä järjestelmästä mikäkin hosti löytyy. Mitäs niätä nyt oli, hp:lla on ILO käkätin jonka kautta pääsee hard-resettaa vaikka sen koko ESX hostin raudan, muilla muita. ( Nyt on vähän hataraa speksiä, en tee rautaylläpitoa, kolleegat tekee ja välistä on tutkittu ongelmia porukalla, jotain infoa aina jää hihaan kun eri alojen kaverit säätää keskenään saman ongelman parissa. )

Eniveis äkkiä palataan siihen karuun todellisuuteen että rauta ja sähkö on tosi halpaa verrattuna työtunteihin. 🙂

Intel kertoi juuri 10 nm saantien olevan odotettua paremmat ja Ice Laken tulevan servereille ensi vuonna.

Intel Starts Qualification of Ice Lake CPUs, Raises 10nm Volume Expectation for 2019

Jos tämä vuoto pitäisi myös paikkaansa, niin sen voisi tulkita Intelin yrityksenä torjua EPYC kuluttajapuolen kustannuksella.

Niin tuossa ei ole mitään ristiriitaa uutisen kanssa. En tosin usko että saavat kovin paljoa serveripiirejä valmiiksi. Eli tuotantokapasiteetti ei varmasti riitä. Toki se että "on tarjota" on paljon parempi kuin "ei ole". Serveripuolella riittää että voi luvata massaerien tulevan vaikka 12kk eteenpäin ekoista sampleista.

Kuluttajapuolella hintakisa tulee olemaan liian kovaa ja Ghz vaatimukset voi olla liikaa 10nm:lle. Sehän voi olla että työpöydällä Intel haluaa taktisesti pitää kiinni 5Ghz valtikastaan, ja 10nm kanssa joutuisivat tyytymään lähemmäs 4Ghz taajuuksiin. Eli tarvitaan 10nm++(+++) että saadaan riittävät kellot kuluttajille. Selittäisi nuo roadmapit. Kannettavat ja serverit toimii alemmilla kelloilla ja perf/w tärkein. Kuluttajapuolella Ghz merkkaa enemmän.

Mutta eikö se Jaguar core itsessää ole köykäisempi kuin Bulldoserin puolikas ts siis tehoiltaan.

Senpuoleen Bulldoserin kaltainen toteutus konsolissa ei olisi lähellekkään yhtä epäonnistunut kuin normi PC:ssä kun siinä konsolissa pelit suunniteltaisiin ottaen huomioon sen Doserin rajoitukset.

Oletko ihan oikeasti sitämieltä että GTX 1650 mallieilla on parempi hinta/laatu-suhde?

Intelillä ja AMD:llä sentään hinnat jotenkin vastaa tuotteen tehoa/laatua jota ne Nvidialla ei todellakaan tee

(nykyään Nvidia laittaa tuottelle niin tökerön hinnan kuin kehtaa ja katsoo että onko sen asiakkaat tarpeeksi tyhmiä maksamaan sen).

Mitään merkitystä kun keskustelun aiheena oli nimenomaan onko ne konsolien ydinmäärä vaikuttanut 7 vuoden aikana pelien hyödyntämien ydinten määrään. Eipä juuri.

Tuossa ei mielestäni painotettu yhtä mallia vaan yleisesti kaikkia uusia julkaisuja ja ihan oikeassa hsalonen oli.

Rtx2080Ti ja Rtx2080 tarjoaa heikompaa Hinta/Perf kuin Rtx2070

Rtx2070 tarjoaa heikompaa Hinta/Perf kuin Rtx2060/Gtx1660/Ti

Gtx1650 sijoittuu jonnekki tuonne 1660 ja 1660Ti väliin.

Miten intel liittyy dGpu ohjaimiin?

Energiatehokkuus kertoo myös kortin laadusta eikä Amd nyt varsinaisesti tarjoa ainakaan laadukkaampia ohjaimia kuin Nvidia.

Eli voisit puhua ennemmin teho/hinta suhteesta kuin Teho/laatu suhteesta.

Onko ne "tarpeeksi tyhmän asiakkaan" eurot pienempiä Vega VII 750e ostaessa kuin Rtx2080 ostaessa? :vihellys:

Konsoleissa on hyödynnetty koko käytettävissä oleva ydinmäärä mutta kun ne pelit on käännetty PC:lle on oltu osittain laskoja ja osittain otettu huomioon se että keskiverto pelikoneessa oli vain 2 ydinta tai 2 ydintä+HT käytettävissä ts pelit on käännetty keskiverto peli PC:iden mukaan ei niiden parhaiden peli PC:iden mukaan.

Eli ne pelit oli alunperin suunniteltu hyödyntämään suurempi ydinmäärä kuin mitä ne PC käännöksinä hyödyntää eli konsolit auttoi pelinkehityksessä suuremmalle ydimäärälle sitä apua ei vain hyödynnetty.

Sanoin "tuotteen" en dGpu opettele lukemaan.

Kun puhutaan tuoteiden hinnoista suhtessa siitä tuotteesta saatuun hyötyyn voidaaan ihan hyvin verrata erilaisia tuotteita.

Sitäpaitsi koko tämä ketju pohjautuu uutiseen Intelien Prosessorejen aikatauluista ts Nvidia Gpu:t ja dGpu:t on ne jotka ei suoraan liity aiheeseen.

Silti halusit mutuilla ja kyseenalaistaa @hsalonen kommentin jossa kiteytettiin Nvidian hinnoittelu täysin oikein, vaikka se ei suoranaisesti liittynytkään aiheeseen.

Intelillä ei ole dGpu ohjaimia joita verrata Nvidian hinnoitteluun.

Amd.lla on Intelillä ei.

Heitä toki lähdettä. Mitään järkeä tuossa ei ole gimpata peliä sen jälkeen kun se on konsoleille tehty ja portataan (ellei vaihdeta pelimoottoria ja tehdä peliä ns. uusiksi).

No esim. siltä PS3 konsolilta käänettäessä muutos ei ollut niin pieni.

Sitten on se että ne konsolikäännöksen annetaan monesti alkuperöisen pelifirman sijasta kolmannentahon nyrkkipajalle joka oikoo niin paljon kuin mahdollista.

Otahuomioon että kun peli käännetään kolsoleila PC:lle se tuo lisämyyntiä vain muutaman kymmenen prosenttia joten pelitaloila ei ole erityistä intressiä panostaa siihen hirveää rahasummaa.

Vähän mittailin die shotteja niin nuo 8 jagge-ydintä välimuisteineen vie vähemmän tilaa kuin kaksi steamroller moduulia(4 "ydintä") välimuisteineen Kaveri-piirissä. Molemmat siis 28nm nodella tuotettuja. 8-ydin BD olisi paisuttanut konsolipiiriä aivan liikaa hyötyihin nähden, siksi se ei kelvannut.

No tavallaan PC:llä tapahtuu tämä myös mutta erona on se että konsolissa pelillä on jatkuvasti se tietty tehoreseervi käytettävissä kun taas PC:llä se vaihtelee sen mukaan että millaista sontaa siellä koneella sattuu juri milläkin hetkellä pyörähtämään ajoon ja kuinka intensiivisesti se alkaa kuormittaa.

Itte olen miettinyt että eikö PC puolelle kannattaisi tuoda toteutus jossa olisi käyttöjärjestelmälle ja taustaprosesseille jokunen lussu core joilla ei siis rullattaisi mitään oikeasti raskaita kuormia vaan niille olisi omat corensa. Sopivasti kun sontaa pyörähtää nyt ajoon taustalla niin kyllä se voi alkaa jossain sinkohipassa näkymään.

Ihan hyvä idea, mutta kyllä se yksikin core saa muutaman millisekunnin aikana jo niin paljon aikaiseksi ettei tuossa lussucoressa ole muuta etua kuin juurikin virransäästössä ARM-tyyliin mobiilipuolella. Toisin sanoen jos sen winkkarin on pakko tehdä jotain raskasta taustalla niin ajamalla sitä jollain mopocorella varmasti jumittaa sen pelinkin joka kumminkin pyörii sen winkkarin päällä. Jos viittaat sonnalla noihin kaiken maailman alanurkan apuohjelmiin, niin ne voi kyllä priorisoida maan rakoon ellei winkkari sitä jo pelien aikana teekin.

Mutta noi konsoleiden dedikoidut coret ovat sinänsä mielenkiintoinen kysymys. Sen takia utelinkin jo viime viestissäni että olisi hemmetin kiinnostavaa nähdä joku prossu-utilisaatiokäppyrä vaikka PS4:sta kun sillä luukutetaan oikein raskasta peliä. Toisaalta onhan se pelinkehittäjille selkeämpää näin ja käyttäjät saavat nopsan palautteen kun hyppivät pelistä konsolin valikkoon tms. Sitten PS4:lla vielä tehdään videokaappausta pelistä jatkuvasti ja viimeiset 15min on aina saatavilla. Ilmeisesti tuota hoitaa oma rautapiiri/moduuli joten vaikea sanoa kuinka paljon tuo rasittaa itse CPU:ta. Joka tapauksessa mitä nyt pleikkarin kanssa leikkinyt, niin ihan sujuvasti tuo latailee ja päivittelee juttuja taustalla vaikka siinä jotain pelaileekin eli kai ne pari dedikoitua corea myös jollain käytöllä on.

Intel esitteli äskettäin hybridiprosessorinsa, jossa on yksi Ice Laken ydin ja neljä Atomia, mikä on kustomoitu jollekin asiakkaalle, joka ilmeisesti halusi samassa paketissa suorituskykyä ja virtapihiyttä.

katso liitettä 221001

Tiedä sitten tullaanko tuota jatkokehittämään, mutta ainakin konseptina kiinnostava viritys.

Siitä tuli Lakefield ja tulee ihan myyntiin (OEM-valmistajille)

Intelin Foveros-prototyypistä tuli Lakefield – io-tech.fi

Kyse ei ollut PS3. Se oli aivan eri järkäle Cellin prosessorinsa kanssa kuin nykyajan x86 pohjaiset konsolit.

Oikoo, mutta jos sinne on tehty säikeistys alunperin niin ei se sieltä lähde ellei munata aivan täysin. Monesti nuo porttien huonoudet johtuu muista asioista jotka liittyy enemmänkin gpu rautaan.

Se on toki täysin totta jos tehdään peli pelkästään pc ehdoilla niin tottakai järkevää tehdä se sellaiseksi että tukee mahdollisimman laajalla rintamalla pc komponentteja jotka sillä hetkellä käytössä. Mutta, puhuit nimenomaan siitä että se peli yhtäkkiä gimpataan porttaus vaiheessa siihen että ei tukisi yhtä montaa säiettä kuin konsoliversio. Saa aika tuuhio olla jos tuohon päätyy (siis sen lisäksi jos peli tehdään suurimmaksi osaksi uusiksi esimerkiksi eri pelimoottorilla). Se säikeistys tehdään niin että se skaalautuu saatavilla olevien säikeiden mukaan, ihan tyhjänpäiväistä sitä on siis muuttaa kyseisessä skenaariossa. Eikä se suorituskyky sillä parane että siihen lyötäisiin joku rajoitus säikeille.

Näinpä, en nyt varsinaisesti pelikoodari ole, mutta keskutelussa pitää kuitenkin erottaa säikeet ja ytimet toisistaan. Säikeitä voidaan ajaa ja ajetaan vaikka kuinka paljon näennäisen rinnakkain yhdellä ytimellä. Suoritusnopeus on vain sen verran kova, että ihmisen rajalliset aistit kokevat asioiden tapahtuvan samanaikaisesti.

Rinnakkaistus on haastavaa ja resursseja syövää hommaa. Resursseja harvoin peliprojekteissa taas on liikaa eli säikeistäminen on sellainen pakollinen paha millä saada lisää nopeutta…varsinkin nyt kun yhden ytimen suorituskyky ei kasva enää samaan malliin ja prossuvalmistajat lisäävät kapasiteettia ytimiä lisäämällä. Tuki pitää löytyä myös muista kehityksen komponenteista eritoten käytetyistä apeista ja niitä käyttävistä pelimoottoreista. DX12 ja Vulkan noin konseptuaalisestikin jo ajavat tähän suuntaan, mutta mitä nyt olen keskusteluja seurannut niin vaikeammaksi se koodailu kuitenkin käy.

Eli jos peli on koodattu alusta lähtien monelle toisistaan mahdollisimman vähän riippumattomalle säikeelle, niin silloin niitä ajellaan joko iloisesti yhdellä ytimellä tai vaikka 16:lla jos sen verran löytyy. Toki ei ole järkeä säikeistää mitään järjettömiä määriä, koska joka säikeestä tulee kuitenkin omat overheadinsa prossulle ja käyttikselle eli siinä mielessä osaksi totta lienee se, että Intelin vuosia jatkunut 4/8-rahastus on vaikuttanut pelien rinnakkaisohjelmoinnin kehitykseen hidastavasti.

Muistaa täytyy että näytönohjain itsessään on jo järjettömän kokoinen rinnakkaismoottori, jossa voidaan ajella myös muutakin kuormaa kuin jotain rasterointia tai varjostuksia. Joka tapauksessa uskoisin että lähitulevaisuudessa nykyinen "pääsäie+muut"-konsepti tulee muuttumaan tai ainakin tasoittumaan niin että sen entisen pääsäikeenkin kuormaa aletaan ripottelemaan muille säikeille ja GPU:n roolia kasvatetaan entisestään. Paljon muuta vaihtoehtoa ei kai olekaan kun viimeistenkin uutisten valossa tuo 5GHz näyttäisi olevan vielä pitkään sellainen haamuraja jonka yli harvoin mennään.

Mitä ihmettä höpiset? GTX 1650:n piiri on käytännössä samankokoinen kuin Ryzenien käyttämä, mukana on 4 GB muistia joka maksaa suunnilleen saman verran kuin piirin valmistus, kortin valmistus maksaa paljon enemmän kuin prossun paketointi, ja AIB-kumppani ottaa myyntihinnasta osansa. Oikea hinta GTX 1650:lle olisi 3x Ryzenien hinta tai toisin sanoen joidenkin halpana pitämien Ryzenien tulisi maksaa kolmasosa siitä, mitä GTX 1650 maksaa.

AMD:n ja Nvidia keskinäisen kilpailun ansiosta näytönohjaimet ovat "aina" tarjonneet hyvää hinta-laatusuhdetta niissä tuoteluokissa, joissa kilpailua on ollut. Intelin vuosikymmenen jatkunut lähes monopoli on näköjään tuudittanut jotkut siihen harhaan, että prossujen tulisi oikeasti maksaa kolminumeroisia summia nykyaikana. No, onneksi tähän on tulossa muutos lähitulevaisuudessa, kun AMD tuo lisää kilpailua ja saa lisää kapasiteettia TSMC:ltä ja Intel kasvattaa 14 nm kapasiteettia 25 %.

Ja jotta tulee sanottua jotain itse keskustelunaiheeseen, Intelin virhe oli sitoa arkkitehtuurit valmistusprosessiin. Ice Lake työpöytäkayttäjille alkasi varmaan olla näihin aikoihin kaupoissa, jollei olisi sidottu 10 nm prosessiin. 14 nm mahdollistaisi piipinta-alan käytön puolesta helposti järeämmät ytimet tai ydinmäärän kasvattamisen, jota toki on tehtykin ja ilmeisesti näin jatkuukin.

Ihan tosi sinä ostat CPU:t ja näytönohjeimet silläperusteella kuinka iso niiden piiri on fyysisesti … ts puhut täysin asian vierestä kun puhe on teho vs hinta … sillä kuinka iso piiri on ei ole mitään merkitystä.

Oletat virheelisesti että ne eivät olisi mitenkään sidoksissa toisiinsa … päinvastoin on täysinmahdollista että Ice Lakea ei voisi järkevästi tehdä 14nm prosessilla tai vaika sen voisi tehdä lopputulos ei olisi tehon puolesta järkevä.

Niin aikaisemmin Intelin arkkitehtuurit oli sidottu valmistusprosesseihin, mutta 10 nm ongelmien vuoksi Intel on joutunut muuttamaan käytäntöään. Pikaisen googlauksen perusteella Sunny Cove on ensimmäinen uusi mikroarkkitehtuuri, jota voidaan käyttää usealla noodilla, joten saattaa olla että oli väärin sanoa, että Ice Lake on sidottu 10 nm:iin.

Sellaista höpistiin Intelin arkkitehtuuripäivillä, joista sinäkin uutisoit. En ole varma mitä kohtaa viestissäni kyseenalaistat erityisesti, mutta muistaakseni aiheeseen tarttui monikin saitti, alla esimerkkinä lainaus Tom's Hardwarelta:

Niin no, Intelin Tick-Tockin jok'ikinen Tick oli vanhan arkkitehtuurin siirto uudelle prosessille. Ilman osittaista uudelleensuunnittelua se ei kuitenkaan onnistu, kun eri prosesseilla on eri suunnittelusäännöt ja yleensä eri kirjastot (esim GloFon 12nm tarjoaa 14nm:n 9T-kirjastotkin edelleen ja AMD käyttää niitä 12nm-piireissään jolloin ei juuri mitään jos mitään uudelleensuunnittelua ei tarvittu, mutta 12nm on käytännössä vähän paranneltu 14nm, joka kilpailun vuoksi uudelleennimettiin 12nm:ksi kesken kehityksen. AMD:n vanhoissa dioissakin siihen viitattiin "14nm+":na)

Logiikkakirjastoista löytyy tietyt peruskomponentit (logiikkaportit, valmiit kiikut ja rekisterit jne).

Laitteistonkuvauskielen kääntäjä siten syntetisoi laitteistonkuvauskielen näiksi.

Tietyt asiat (esim. jotkut rekisterifileet, joihin pitää pystyä tekemään todella monta lukua ja kirjoitusta todella nopeasti) on kuitenkin standardisoluista koottuna hitaita, ja näistä saadaan nopeampia kun niistä suunnitellaan "käsin" juuri sille varmistusprosessille optimoitu versio, jossa jokaisen transistorin tyyppi ja paikka on tarkkaan mietitty.

Intelin, AMDn ja IBMn prosessoreissa on tyypillisesti ollut tällaisiä "käsin" juuri sille valmistustekniikalle tehtyjä lohkoja. Bobcat taisi olla ensimmäinen AMDn CPU missä näitä ei ollut (koska se suunniteltiin alunperin nimenomaan ajatuksella että sitä tullaan valmistamaan useilla eri valmistusprosessilla mm. pelikonsoleihin ja halpoihin tabletteihin jne), eikä sen tarvitse saavuttaa maksimaalista kellotaajuutta, mutta veikkaisin, että Zenissä näitä taas on.

Intelin jokaisen "tick"n myötä piti "käsin" suunnitella uudelle valmistustekniikalle uudet versiot näistä custom-logiikkapalasista, mikä oli työlästä.

Ööh, siis ajatellaanko nyt että piirin suunnitteluun käytetyt resurssit olisivat kaikilla samat? Samoin voittomarginaalit, valmistusmäärät, kiinteät kulut jne? Jos myytäisiin jotain tietyt kriteerit täyttävää rautaputkea niin materiaalikulut varmasti näyttelevät pääosaa, mutta ei jotain prosessoreja voi alkaa vertailla noin.