Testasimme pelisuorituskykyä AMD:n ja Intelin prosessoreilla eri näyttöresoluutioilla.

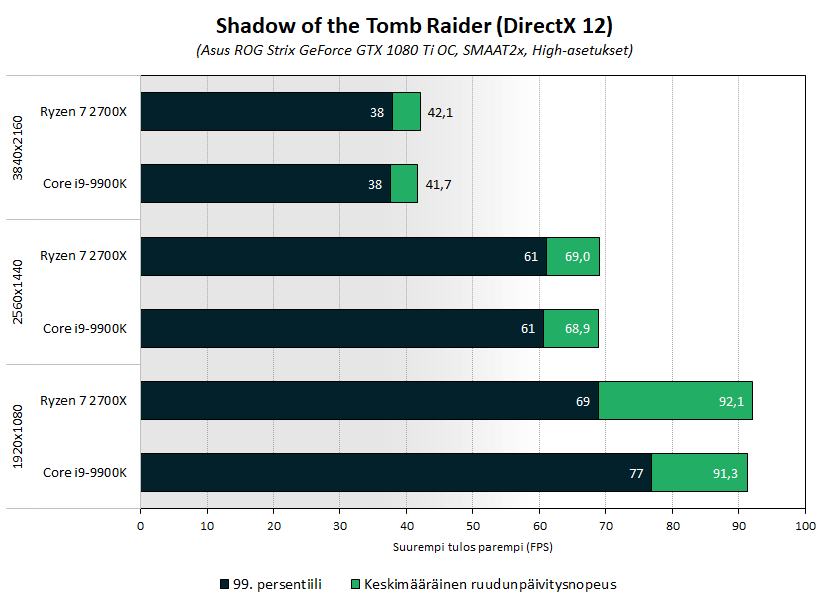

Testasimme Intelin ja AMD:n suorituskykyimmillä työpöytäprosessoreilla eli 8-ytimisillä Core i9-9900K:lla ja Ryzen 7 2700X:llä pelisuorituskykyä kolmella pelillä ja kolmella yleisimmällä resoluutiolla (Full HD, 1440p & 4k).

Testaamme, minkälaiset erot syntyvät kun peli on hyvin näytönohjain- tai prosessoririippuvainen ja miten suurempi näyttöresoluutio vaikuttaa suorituskykyyn. Mukana peleistä on Shadow of the Tomb Raider, Battlefield 1 ja The Witcher 3.

Lue artikkeli: Intel vs AMD: Pelisuorituskyky eri näyttöresoluutoilla

Siellä saattoi hyvin olla myös useampi 20 ja 100 FPS runi tai useita 21 ja 99 jne jne.

Se on vain asia mikä pitäisi hyväksyä, että täysin tarkkaa kuvaa ei voida saada liian merkittävän satunnaisuuden vuoksi ja ainakin omasta mielestäni (ja useiden sivustojen perusteella myös usean muun mielestä) 99. persentiili on sopiva kompromissi tarkkuuden ja luotettavuuden suhteen

Sana "satunnainen" tarkoittaa, että tilastollinen laki on olemassa.

Hyväksyminen, että tarkkaa kuvaa ei voi saada, on hankalaa, jos ei ensin tosissaan yritä.

Meidän ei tarvitse mutta joku muu voi vielä joskus tehdä niin.

Ongelmahan on se, että noita on jo testattu ja tultu siihen lopputulokseen, että antavat epämääräisiä tuloksia. Jos taas käydään nypläämään ja laskemaan, niin menee turhan työlääksi, saavutettuun hyötyyn nähden.

Eli unohtakaamme avg. tulokset kokonaan ja Cpu/Gpu/Ram testeissä katsoo vain 1% tuloksia koska se kertoo kuinka sulavaa päivitettävyyttä on odotettavissa huonoissa olosuhteissa (game engine).

1% persentiili on uusi 'average' jota pitää tuijotella. 😉

Eli unohtakaamme avg. tulokset kokonaan ja Cpu/Gpu/Ram testeissä katsoo vain 1% tuloksia koska se kertoo kuinka sulavaa päivitettävyyttä on odotettavissa huonoissa olosuhteissa (hw tai game engine pullonkaula).

1% persentiili on uusi 'average' jota pitää tuijotella. 😉

Öö, ei eikä kukaan ole niin väittänytkään? Tässä keskustellaan siitä mikä on se pienin oleellinen arvo tuloksissa, totta kai sen päälle averaget ja miksei maksimitkin

Itse ainakin katson min, 1%, avg ja max.

Minimi kertoo minne on tippunut (eli töksähtääkö jossain)

1% kertoo sen sulavuuden raskaimmillaan ja avg keskimäärin sulavuuden. Max sitten kertoo sen miten hyvin parhaimmillaan on pyörinyt, tottakai nämät kaikki tietää. 😀 Kyllä itse haluan ainakin kaikki nuot tietää jos jotain olen ostamassa.

9700K tulokset olisi hyvä lisä testeihin. Jos se yltää 9900K:n tasolle 99. persentiilissä niin tuon 24% paremman tuloksen myötä sen hankinta olisi kenties jopa suositeltavampaa kuin 2700X:n.

Gamernexus ajaa 9600K:lla n. 4200 framen mittaista testiä jolle he ilmoittavat avg fps:ksi 150fps. Se on 28 sekuntia.

Sori jos vastaan vähän myöhään, mutta vertailin nimeomaan unlockked vs freesync. V-Syncillä viive on selkeä, etenkin näissä 60 fps nopeuksissa.

Ehkä me aloitettiinkin juttu väärästä päästä: ehkä fps minimi kuvaa ongelmaa huonosti, jos minimit on tyyliin 10 sekunnin välein.

Jos mittaisikin fps minimien sijaan ne latenssipiikit, jotka ylittää jonkun halutun kriteerin (esim. 16,6 ms / 60 Hz), ja niiden määrän esim. minuutissa. Lisäksi joku luku joka kuvaa miten paha (pitkä) latenssipiikki on.

Kokoonpanojahan voi olla todella paljon erilaisia ja kaikkia ei voi testata, mutta silti olisi joskus hauska nähdä miten esim. 1080 ei ti versio pelaa 2700x tai 9900k kanssa.

Joo, ei töksähtele jos fps = hz. Sen allehan se töksähtelee ihan todistettavasti, suoraan frametimestä luettavissa. Jos et tätä havaitse niin OK, mutta faktuaalista se on.

Keskustelu alkaa olla tän aiheen tiimoilta paikoin vähän häröä 😀

Teoria ja käytäntö on kaksi eri asiaa, jos 60 FPS keskimääräisellä ruudunpäivitysnopeudella joukossa on YKSI selvästi hitaammin renderöity ruutu joka näkyisi frametime graafissa tai 0,1% low taulukossa niin onko se tosielämässä havaittavissa? Teoriassa kyllä hyvin selvästi, mutta käytännössä? Jos se on ihan jatkuvaa 0,5-2 sekunnin välein tapahtuvaa säännöllistä niin varmasti mutta pitkällä testijaksolla yksittäinen hitaampi ruutu?

Ehkä hyvä kysymys lienee myös, että mikä optimaalisessa ja siivotussa koneessa tipahtaa yksi ruutu, niin montako ruutua tippuu sitten sellaisessa vastaavassa koneessa, joka ei ole optimaalinen ja siivottu. Mitä tapahtuu, kun taustalla soi Youtube-video toisessa näytössä, mitä tapahtuu jos edes pelkkä selain on idlenä taustalla? Tässä on reippaastikkin itsellä kokemusta siitä, kuinka isompien prossujen ylimääräiset ytimet ovat paljon vähemmän ylimääräisiä sitten, kun konetta aletaan oikeasti käyttämään.

Se voi hyvin olla, että nämä yksittäiset piikit ovat kaikkea muuta kuin yksittäisiä, kun kone otetaan oikeaan käyttöön laboratorio-olosuhteiden sijaan. Itse toivoisin joskus testiä, että millaiseksi suorituskyky muuttuu, jos toisella näytöllä ajetaan koko testin ajan IO-techin tekniikkakatsausta tubesta. Jotain sellaista siis, josta koneeni joutuu selviämään joka perjantai. 😉

Nuissa 1% tai 0,1% low hommissahan pitää sitten kans huomioida se, että miten ne huonoimmat framet sijoittuu sinne aikajanalle ja suhteessa toisiinsa. Jos keskimäärin pyörii siellä 60fps tuntumassa (16ms/frame) ja otetaan vaikka minuutin testijaso (3600 framea) ja siellä on seassa 4kpl 50ms frameja (eli 0,1% on se 50ms), niin mikäli nuita on harvakseltaan vaikka 10 sekunnin välein 1kpl, niin se ei haittaa hirveästi pelikokemusta, mutta jos ne kaikki hitaat framet on peräkkäin (eli 0,2 sekuntia menee harakoille), niin siinä on jo vaarana että menettää nopeatempoisessa pelissä henkensä. Ja jos joka minuutin jaksolla on tommonen 0,2 sekunnin töksähdys niin kyllähän se vituttaa.

Itse en omissa testeissä ja analyyseissä katso mitään yksittäistä arvoa, vaan keskimääräisen, 99. persentiilin ja käytännön kokemani perusteella teen arvioita.

Tästä syystä esim. karsastan TechPowerUpin tai Anandtechin käyttämää automatisoitua testirutiinia eli painetaan "Start", poistutaan koneelta ja palataan takaisin muutaman tunnin kuluttua ja "testit" on ajettu. Aika usein testien aikana/jälkeen nousee esille asioita, joita on pakko selvitellä ja tarkistaa. Tästä syystä Anandtechilla on esim. prosessoritestit menneet ns. **tuiksi aika monta kertaa viimeisen parin vuoden aikana, kun kerran mitään ei testata käytännön tasolla, vaan katsellaan vaan valmiita tuloksia.

Testaukseen on tietysti monta lähestymistapaa, itse pyrin mahdollisimman käyttäjäläheiseen.

Hyvä asia on kuitenkin, että tästä aiheesta keskustellaan :tup:

Olisi kiva jos testattaisiin muitakin pelejä kuin mitä löytyy joka ainoasta testistä netissä, esim. Kingdom Come: Deliverance, minkä pitäisi olla kohtuu raskas prossulle.

En sanoisi, että 10 sekunnin välein on harvakseltaan, se on erittäin usein. Korkean fps:n refleksi-intensiivisissä peleissä jo tuo 50 ms:n töksähdys voi aiheuttaa tarpeettomaan viikatemiehen visiitiin. 🙁 144 Hz:n näytöllä 50 ms tarkoittaa, että näytetään vanha frame 7 kertaa peräkkäin, eikä sellainen ole puhtaasti käyttökokemuksenkaan kannalta ok.

Tälläinen graafi, mutta paremmalla vaaka-akselin mittausjaolla kertoisi minusta paljon enemmän kuin palkki jossa on kaksi arvoa:

![[IMG]](https://techreport.com/r.x/2018_10_25_Checking_in_on_Intel_s_Core_i7_5775C_for_gaming_in_2018/Crysis_3_frametime_percentile.png)

Käytännössä tuo graafi joko

a) logaritmisella vaaka-asteikolla

b) 90-99.9% väliltä frametimet näyttävänä niin, että 99% – 99.9% on vielä selkeästi eroteltavissa.

Ja sen jälkeen sitten tietysti frametime-dataa pitäisi kerätä niin pitkältä mittausjaksolta, että mahdollinen mittausdatan kohina keskiarvoistuu pois sieltä 99.9% frametimeistäkin.

Tämä on hyvä lähtökohta ja ainakin itse luen tälläistä mieluummin kuin esim. arvostelua missä todetaan "jokaista kokoonpanoa testattiin 10 kertaa, Intelin 9900K prosessorilla ja 2080TI näytönohjaimella 1 kerran tuli sähkökatko joten koko kone kaatui" => jengi vetää pahimmillaan johtopäätöstä "10% mahdollisuudella 9900K ja / tai 2080TI ei edes toimi / kaatuu kesken".

Tuo siis kärjistäen. Jos testaaja itse on paikalla, huomaa että esim. testin aikana (sanotaan nyt vaikka tunti) kerran hänelle itselleen tuntemattomasta syystä CS testissä (aivan sama puhutaanko Half-Lifen [1998] modista vai oikeasta [2000 julkaistu] pelistä) FPS käy nauhojen mukaan kerran 50, muuten pysyy 240 päällä keskimäärin noin 300, eikä onnistu toistamaan tapahtumaa on parempi ettei sitä edes mainita kuin että kirjoitetaan "muuten hyvä mutta välillä tipahtaa päälle 80% keskimääräisestä nopeudesta" tjsp.

Toki on totta että jollekin kilpapelaajalle tuollaisella voi olla merkitystä ja maailman huipulle mentäessä se korostuu. Mutta kuinka moni pelaa elääkseen jotain peliä ja hakee tietonsa tältä foorumilta (mitä ostaa seuraavaksi pelikoneeseensa) on asia erikseen. Uskallan väittää että suurelle osalle lukijoista se työ mitä Sampsa ja kumppanit tekevät on enemmän kuin tarpeeksi hyvää. :kippis:

Nää testit on kyllä hyviä. Tässä raudanhimon keskellä jotain järkeäkin päähän. Jotenkin silti tekisi mieli päivittää 1600 8700k:hon ja sitten uutta näyttistä jossain vaiheessa. Mitään järkeä ei tossa oikein ole koska 1070 meinaa tukehtua 165hz 1440p näytölle:vihellys:.

Eipä tässä aina järjellä mennäkkään. Kiitos kuitenkin artikkelista.

DX12 pelin ajaminen Nvidia kortilla ja AMD prossulla antaa ihan väärän kuvan kun nvidialla on ihan hirveet dx12 ajurit siihen verrattuna AMD. AMD prossu saa paljon paremmat tulokset DX12 peleissä AMD näyttiksellä kun niissä on kunnon tuet multithreadille. Nähty jo kauan sitten rise of the tombraiderissa. Ryzen ja nvidia kortti dx12 oli ihan kauhee fps, ja sittenkun vaihdettiin amd kortti sinne nii DX12 tulokset parani AMD ja intelin prossuilla.

Varmaan sitten koneessa tai asetuksissa vikaa tai olit pelannut tyyliin ensin Gtx960 ja päivittänyt Amd R9 390 ja todennut että paremmin pyörii.

Vai mistä ohjaimista oli kyse?

Dx12 peleissä ei ole Nvidian korteilla ongelmia,ellei jotain vanhempia yksittäisiä ole joita en nyt muista.

Ei mitään ihmeellisiä eroja mielestäni.

![[IMG]](https://images.anandtech.com/graphs/graph12725/97931.png)

The AMD 2nd Gen Ryzen Deep Dive: The 2700X, 2700, 2600X, and 2600 Tested

i7 8700k

![[IMG]](https://tpucdn.com/reviews/Zotac/GeForce_RTX_2070_AMP_Extreme/images/rise-of-the-romb-raider_2560-1440.png)

Nyt kun tuli Doomia pelattua, niin huomasi hyvin kun peli rajoitti fps:n 60:een normaalin 165:n sijasta (Doom tekee tätä silloin kun juonta käydään läpi). Ja kyllä se viimeinen taistelu näytti helvetin smoothilta. Ei ole yli 60 fps hukkaan heitettyä.

Muistaakseni ongelma oli Nvidian ajureiden toiminnassa eikä varsinaisesti prossussa. Amd näyttis teki rautapuolella sen minkä Nvidia suorittaa ajureilla, jonka prosessori sitten joutuu laskemaan.

IMO tässä on nimenomaan yksi ongelma, joka on frametime vs. FPS muunnoksessa jäänyt vähemmälle huomiolle. Ennen kuin frametimeista ja micro stutterista alettiin puhua yleisimmin, niin käsittääksen minimi FPS:llä tarkoitettiin useinmiten nimenomaan sitä heikointa sekunttia pelin aikana, joka kuvasti lähinnä sitä jaksaako kokoonpano raskaaatkin kohdat pelissä.

Nyt taas (ilmeisesti. ml. Io-techin tulkinta) varsinaista sekunnissa renderöityijen ruutujen minimia tai 99% persentiiliä ei oikein edes raportoida missään, vaan puhutaan frametimeista, jotka eivät välttämättä kerro väännöstä raskaimmassa kohdassa vaan voivat vaan kertoa siitä microstutterista FPS:n (merkityksessä piirrettyjä ruutuja sekunnissa) ollessa vaikka lähestulkoon maksimissa.

Nuohan on kuitenkin kaksi täysin eri ongelmaa, autovertauksin toinen kertoo riittääkö tehot ylämäessä, toinen kertoo nykiikö moottori. Itse vieroksunFPS yksikköä frametimen kuvaukseen ihan samalla tavalla kuin vieroksuisin km/h yksikköä auton nykimisen mittaukseen . Minusta olisikin parempi, että jos noita frametimeja halutaan samalla graaffille FPS:ien niin käytetääisiin kahta asteikkoa (ms ja FPS) ja puhuttaisiin frametimeista aina FPS:nä. Olisi minusta paljon loogisempaa, ja jos jollekin vaikka 16 ms ei sano mitään niin eihän mikään estäisi katsomasta sitä väärää asteikkoa jos nyt haluaa sitetää mitä FPS nopeutta tasainen 16 ms frametime vastaa.

Sinänsähän se kuitenkaan muutu mitenkään että aina voi olla joku omituinen ongelma joka ei perustilastoissa näy, ja siksi onkin hienoa että näitä ihan testaa ja sitten tarvittaessa pohtii miten havaittuja omituisuuksia kuvataan tai dokumentoidaan.

Kyse on siitä, että lasketaanko FPS frametimejen käänteislukuna vai keskiarvoistettuna lukemana joltain aikayksiköltä.

Jos peli pyörii minuuttitolkulla niin, että puolessa sekunnissa piirretään 99 framea ja engine jumittaa aivan täysin sen jälkeen puoli sekuntia piirtäen yhtä framea jatkaen tätä nykivää looppia, niin keskiarvo-fps on 100 ja 99% persentiili kertoisi pelin pyörivän 200fps(!) vauhtia 99% ajasta…

On vaikea tuottaa sellaista tilastollista numeroa joka oikeasti takaisi, että hommat pyörivät hyvin.

Ehkä joku frametimejen mediaani, standardipoikkeama ja jakaumafraami…?

Yli 16,7 ms latenssipiikkien yhteenlaskettu (16,7 ms ylittävän osan) kesto on käytössä joissain testeissä.

Where minimum-FPS figures mislead, frame-time analysis shines

Kyllä tuo frametime aikajana jostain raskaasta kohdasta peliä on kaikkein kuvaavin miten peli pyörii. Jos on paljon ja pitkiä piikkejä tai "käyrä" kulkee kovin korkealla niin se on paras visualisointi siitä miten peli pyörii. Toki vertailu on sitten vaikeampaa mutta jos erot ovat niin pieniä että frametime kulkevat kahdella kortilla melkein päällekkäin niin onko tuolla väliä.

Toki noissa palkkikuvaajissa täytyy olla todella tarkkana mitä skaalaa on käytetty ettei käy niin että 1ms ero näyttää valtavalta erolta graafissa.

Frametime trendi olisi paras. Siitä näkee selvästi, että kuinka tasaisesti testattava peli pyörii ja jokainen voi sitten tehdä itse päätelmät mikä on riittävä suorituskyky. Tässä on taas jotain esimerkkejä joista voi ottaa mallia, mutta ei tarvitse suinkaan kopioida täysin.

Benchmarks: FPS, Frame Time & Smoothness – Wolfenstein II: The New Colossus Performance Review

Tässä on juttua ilmeisesti nykyään käytössä olevasta mittaustavasta:

PresentMon: Performance In DirectX, OpenGL, And Vulkan

Toisen sivuston järjestelmä:

An introduction to FCAT benchmarking

Ei ole helppoa 🙂

kattelin kans että Steve käyttäny hitaan olosia muisteja.

Testit ois voinu tehdä low asetuksilla, ettei gpu bottleneckistä ois kiinni tulokset.

Testit tehtiin sellaisilla asetuksilla joita joku käyttääkin.

Miksi ihmeessä? Mitä tuolla tuloksella tekee? ”Jo tämä hitaampi prosessori X pyörittää peliä erittäin sulavasti, mutta prosessorilla Y saamme selvästi suuremman FPS-lukeman, jolla emme tosin tee yhtään mitään.”

Kuka oikeasti ajaa tahallaan tarpeettoman alhaisilla grafiikka-asetuksilla pelejä? Jo tuo 1080 Ti käyttäminen Full HD -resoluutiolla on hieman kyseenalaista (koska ne, jotka pelaavat tuolla resoluutiolla käyttävät yleensä selvästi halvempia näytönohjaimia)?

Se perustelu ”varautumisesta tuleviin raskaampiin peleihin” ei sitten toimi, koska kuten jo aikaisemmin on nähty, nykyinen kilpailijaa parempi suorituskyky ei takaa samaa eroa tulevissa peleissä. (Esim. kaksiydin-Intelit veivät 6–0 niitä vanhoja 8-ydin AMD:itä, mutta nykypeleissä ensimmäisillä ei aina saa edes peliä käyntiin pelaamisesta puhumattakaan. Jälkimmäiset puolestaan ovat saavuttaneet oman aikakautensa neliydin-Intelit suorituskyvyssä uudemmissa peleissa.)

Niin tai vaihtoehtoisesti, jos ois ollut se rtx2080ti käytössä.

Uusi testi päivitettynä 2080 Ti:llä on tulossa piakkoin.

Ideana oli, että näkisi selvemmin eron prosessoreiden välillä. Esimerkiksi jos joku haluaa ostaa rtx2080/2080ti:n, mutta sitten ryzeni onkin bottleneckinä näytönohjaimelle.

Miksi ei voi vaan sanoa pullonkaulana? Ja näkeehän tuosta nykyisestäkin sen, että (poislukien tuo alin resoluutio ja The Witcher 3) tehokkaampi näytönohjain tulee antamaan selvästi lisää ruudunpäivitysnopeutta. Jos siellä olisi prosessori pullonkaulana, niin resoluution nosto ei juurikaan tosiaan pudottaisi lukemia…

Eli, riippu mitä ja miten pelaa (ja toki myös siitä tyytyykö tuohon tämän testin pullonkaulatason ~80 FPS minimiin Ryzenille huonoimmassa pelissä).

Edelleenkään se tässä testissä (synteettisesti grafiikka-asetukset pahoinpitelemällä) mahdollisesti näkyviin saatava iso ero ruudunpäivitysnopeudessa ei siitä yleisty kovin hyvin oikeaan pelikäyttöön (muuta kuin niille, jotka pelaavat alimmalla resoluutiolla ja ilman silmäkarkkia).

Saman perustelun voi kait kääntää niin päin, että "varautuminen tuleviin raskaampiin peleihin" toimii niin kauan kuin ytimet ei lopu kesken.

720p perinteisesti jonkun verran kiinnostanut, koska uskon että osaan tulkita mitä tulos tarkoittaa. 2080 ti, 1080p varmaan nykyisin ajaa saman asian. Paitsi ehkä jossain pelissä jota oikein mikään näyttis ei jaksa kaikilla detaljeilla.

Suurinta osaa käyttäjistä kiinnostaa lähes poikkeuksetta juuri "se" näytönohjain mikä heillä itsellään sattuu juuri silloin olemaan käytössä. Sama resoluution suhteen.

TOSIN myös se markkinoiden ns. "tehokkain" kortti kiinnostaa, ainakin jos sen hinta on suunnilleen järkevällä tasolla (itselleni järkevä on alle 400€ mutta sanotaan nyt noin 600-800€ millä hintaa jotkut vielä niitä ostavat) perimmäisenä ajatuksena juuri täälläkin mainittu "tulevaisuuden pelit / käyttö".

Tai oikeammin "kun myöhemmin hinnat laskevat niin ostan vastaavan tehoisen kortin sillä summalla mikä itsestäni on sopivin / kun juuri kyseinen kortti tulee esim. Jimm's:lle tarjoukseen siihen 399€ tai alle hintaan".

En sano etteikö olisi järkevää tehdä kolmella yleisimmin tuetulla resoluutiolla (1080p, 1440p ja 4K) testit koska moni myös hiljakseen päivittää näyttöjään ja silloin siitä 1080p (tai mikä nyt sattuu olemaan käytössä) noustaan helposti niin tuumakoossa kuin resoluutiossakin jolloin tulee katsottua vanhempiakin testejä ja miten näytönohjain tulisi riittämään sillä uudella resoluutiolla.

Mutta oikeasti aika harva pelaa mitään enää 640×480 tai 800×600 resoluutiolla. Teoriassa joku ehkä vielä 1024×768 (tai 1920×1200) mutta suurella osalla on juurikin 16:9 näyttö (tai tykki) ja nuo kolme ylempänä mainittua resoluutiota. Lisäksi 16:10 tekee sen verran vähän eroa että (mielestäni) ei kannata tehdä erillistä testiä sitä varten (vaan esim. 1080p riittää myös 1200p näytön omaavalle noin ideana, samaten 1440p => 1600p).

Täytyy kuitenkin myös muistaa että Sampsa ja kumppanit tekevät tätä työkseen ja kunnon testaamiseen kuluu aikaa (mikä työssä tarkoittaa suoraan rahaa). En ainakaan itse olisi halukas maksamaan esim. 10€ enempää että saisin lukea "premium" version artikkelista missä on myös testattuina: 640×480, 800×600, 1024×768, 1920×1200, 2560×1600 ja (teoriassa, en tiedä onko kukaan edes tehnyt 4K 16:10 näyttöjä? en jaksa etsiä) 3840×2400 resoluutiot.

Puhuinkin oikeastaan eri asiasta: siitä mikä itseä kiinnostaa, omasta puolesta vaan. Ei se velvoita tekemään niitä testejä.

Siksi en osannut hahmottaa, mikä sinua itseä kiinnostaa.

Kun aletaan arvaamaan, mikä juttu jotain tiettyä ryhmää oletettavasti kiinnostaa, siitä ei oikein saa selvää ja voi mennä "ryhmäajatteluksi", mutta sopii siitäkin aiheesta jutella.

Tässä testissä ei koeajettu pelejä joita olisi järkeä ajaa pienemmillä asetuksilla, mutta semmoisia kyllä on olemassa.

Jos pelaat voittaaksesi esim. PUBG/CSGO, et aja kys. peliä kaikki karkit tapissa, vaan omista preferensseistä riippuen low/med asetuksilla.

Aika montakin "tarpeettoman" alhaisilla asetuksilla pelaavaa kyllä löytyy. Monet kilpailuhenkiset pelit hyötyvät helposti 200+ fps:stä (miellään vielä >99 % min) vaikka olisi vain 144 Hz-näyttö, saati jos on 240 Hz…

120 Hz on ei-kilpailuhenkisissäkin peleissä hyvän pelikokemuksen edellytys itselleni, pl. strategiapelit, eli asetusten tipauttelu on todellisuutta monen pelin kohdalla.

GTX 2080 ja FHD. :cigar:

Se on täysin höpöä että FPS ja Hz tulisi olla synkassa millään tapaa.

144Hz ja 60fps on aina miellyttävämpi kuin 60Hz ja 144fps.