AMD esitteli tänään kauan odotetun RDNA2-arkkitehtuurin ja siihen perustuvat Radeon RX 6000 -sarjan näytönohjaimet. NVIDIAn tapaan AMD esitteli aluksi kolme mallia uuteen näytönohjainsarjaansa: RX 6800, RX 6800 XT ja RX 6900 XT.

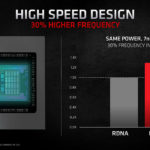

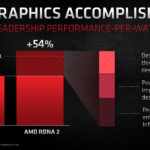

RDNA2-arkkitehtuurin tavoitteena oli 50 parempi suorituskyky wattia kohden verrattuna edeltävään RDNA-arkkitehtuuriin, mutta Navi 21:llä saavutetaan AMD:n mukaan yleisesti 54 ja RX 6900 XT:n tapauksessa parhaimmillaan jopa 65 % parempi suorituskyky per watti. Parannukset on saavutettu uusilla Compute Unit -yksiköillä, jotka toimivat 30 % aiempaa nopeammin samalla tehonkulutuksella, yleisillä arkkitehtuurin parannuksilla sekä uudella Infinity Cache -välimuistilla. Tulemme tutustumaan Infinity Cacheen ja muihin artikkelissa mainittuihin uudistuksiin tarkemmin tulevassa RDNA2-artikkelissa sekä muussa uutisoinnissa.

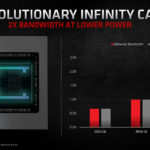

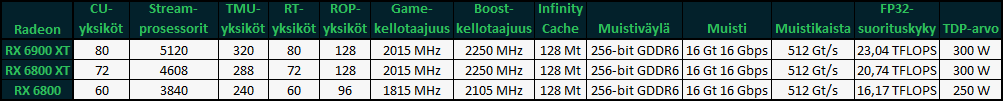

Koko nyt esitelty Radeon RX 6000 -kolmikko perustuu yhteen ja samaan Navi 21- eli ”Big Navi” -grafiikkapiiriin. 26,8 miljardista transistorista rakennettu grafiikkapiiri valmistetaan TSMC:n 7 nanometrin valmistusprosessilla ja se rakentuu yhteensä 80 Compute Unit -yksiköstä ja 256-bittisestä muistiväylästä, jonka jatkeena on 16 gigatavua 16 Gbps:n GDDR6-muistia. Näytönohjaimen verrattain kapeaa 512 Gt/s:n muistikaistaa on kompensoitu 128 Mt:n Infinity Cache -välimuistilla, jonka avulla efektiivinen muistikaista olisi teoriassa peräti 1664 Gt/s. Löydät kunkin mallin oleellisimmat tekniset yksityiskohdat yllä olevasta taulukosta.

RDNA2-arkkitehtuuri ja siihen perustuvat näytönohjaimet tukevat täysin Microsoftin DirectX 12 Ultimate -rajapintaa ja sen uusia ominaisuuksia, kuten säteenseurannan kiihdytys, Variable Rate Shading -teknologia, Mesh-varjostimet sekä Sampler Feedback -teknologia. Useat DX12U-rajapinnan ominaisuuksista on jaettu sisäisesti eri tasoihin, mutta AMD:n uutuuksien osalta nämä tasot varmistuvat vasta myöhemmin. Säteenseurannan osalta AMD on varmistanut jo aiemmin Microsoftin kautta, että tuettuna on vähintään DXR:n tällä hetkellä korkein 1.1 -taso. Myös DirectStorage-rajapinta on luonnollisesti tuettujen ominaisuuksien listassa.

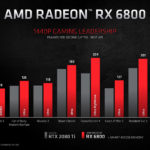

AMD on asemoinut Radeon RX 6900 XT:n NVIDIAn GeForce RTX 3090:n kilpailijaksi, RX 6800 XT:n RTX 3080:n kilpailijaksi ja lopulta RX 6800:n RTX 3070:n kilpailijaksi. Yhtiön omien suorituskykydiojen mukaan Radeon RX 6900 XT peittoaa GeForce RTX 3090:n 4K-resoluutiolla viidessä pelistä kymmenestä ja yhden pelin mennessä tasan, kun käytössä on Rageksi ristitty automaattinen ylikellotustoiminto ja alustana on Ryzen 5000 -sarja, mikä mahdollistaa Smart Access Memory -teknologian hyödyntämisen. RX 6900 XT:n TDP on 50 wattia matalampi, mutta Rage-mode päällä näytönohjain ei välttämättä kunnioita sitä.

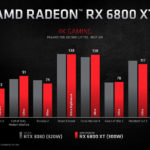

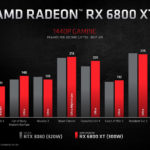

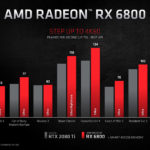

Radeon RX 6800 XT peittoaa AMD:n 4K-testeissä GeForce RTX 3080:n niin ikään viidessä pelissä kymmenestä, mutta tällä kertaa tasan meneviä pelejä on kaksi, eikä käytössä ole Rage-ylikellotustilaa tai Smart Access Memoryä. 1440p-resoluutiolla 6800 XT vie nimiinsä peräti kahdeksan peliä kymmenestä. Rage-ylikellotustilan ja Smart Access Memoryn kerrotaan parantavan 6800 XT:n suorituskykyä 4K-resoluutiolla seitsemän pelin valikoimalla 2 – 13 %. Radeon RX 6800:n verrokkina oli vielä NVIDIAn viime sukupolven RTX 2080 Ti, jonka se peittosi kaikissa kymmenessä testipelissä sekä 1440p- että 4K-resoluutiolla Smart Access Memory käytössä.

Radeon RX 6800 ja RX 6800 XT saapuvat myyntiin 18. marraskuuta. Niiden verottomat suositushinnat ovat 579 ja 649 dollaria. Radeon RX 6900 XT saapuu myyntiin 8. joulukuuta 999 dollarin verottomaan suositushintaan.

Bäfässä ei ole vakioitua sisäistä benchmarkkia. Suhteellinenkin ero vaihtelee sen mukaan missä kohti peliä testi on suoritettu(korttien ominaisuudet ja ajurit vaikuttaa) ja harvoin on niin pitkä että keskiarvo tasoittuisi. Kellään ei ole niin paljon aikaa yhden pelin testaamiseen yhdellä kortilla. Se että suhteelliset erot eivät ole samat eri testien välillä ei tarkoita että yksi niistä on oikeassa ja loput väärässä.

Menee jo vähän tän aiheen ohitse, mutta tälläiset DLSS sitä ja tätä jutut on siitä naurettavia, että vaikka ja kuinka maailma kehittyy ja nämä tekniikat kehittyy, niin skaalaaminen on (loputuloksesta huolimatta) skaalaamista. Vaikka se mitenkä hienosti tehtäisiin supertietokoneita avuksi käyttäen. Se vääristää touhua. Nyt puhutaan PC:istä eli sieltä missä on kaikista kovimmat hinnat ja kaikista kovimmat tehot. Noi skaalaamiset ymmärtää alustoilla mitkä on aina samanlaisia ja tehoa on se rajattu määrä. Tuo tie, että aletaan vertailemaan seuraavaksi, että kuka skaalaa parhaiten tekee vertailemisesta aivan mahdotonta, joten käytännössä on pakko pysyä siellä kovassa rautamaailmassa missä ei kikkailla.

Skaalausta on AMD harrastanut jo pitkän tovin, ainakin xbox360 ajoilta asti (rendausreso harvoin oli se, mitä pistettiin töllölle), eli kyllä siitä pitäisi olla ihan riittävissä määrin kokemusta myös AMD:llä. Ylipäätään. tuo DLSS/super resolution on ihan jepa keino saada juttuja pyörimään näytön natiiviresolle, jos se ei sillä ennestään jo pyöri. Onhan sitä ennenkin säädetty nuppeja pienemmälle/muutettu kuvanlaatuasetuksia, jos jokin peli ei pyöri riittävän hyvin ja tuo vaikuttaisi olevan ihan jepa keino toteuttaa se kuvanlaadun paljoakaan kärsimättä. Arvosteluihin se tuonee vain yhden sliden lisää, itse vertailun uskon tehtävän yhä natiiviresolla. Eiköhän sitä varsinaisissa arvosteluissa nähdä vaikutukset sekä laatuun että nopeuteen super resolution päällä ja pois, vastaavasti miten näitä DLSS-vaikutuksia on päässyt vertailemaan. 6xxx revikoita odotellessa siis. (se että jokin peli xyz näyttää jopa paremmalta dlss päällä kun natiiviresolla jättänen hieman vielä kyseenalaiseksi, onhan moni peli paaljon paremman näköinen kun blurreja, doffia ja vaikka ambient occlusionia nappaa pykäliä paria pienemmälle, jolloin kuitekaan ei olla siellä "kaikki kaakossa" asennossa)

3090 onkin sitten selkeä poikkeus, hintansa takia ei oikein suositeltava. Eiköhän sitäkin tosin viilata kun 6900xt:täkin alkaa löytyä hyllystä.

Loistavaa aikaa viimein pelaajille

On skaalausta tehty tosiaan ennenkin. Mutta tämä suuntaus ja sen hyväksyminen on sama kuin alettaisiin antamaan formuloissa tai juoksukisoissa tyylipisteitä. Että nopein ei enää voitakkaan jos ei juokse määrätyllä tyylillä. Se on sitten loputon suo ja vertailtavuus laskee luokattomaksi. Se, että otat asetuksia pienemmäksi tekee saman joka laitteella, se miten se skaalaus menee ei taas toimi samalla tavalla, kun sille ei ole olemassa yhtä standardia vaan porukka kilpailee keskenään. Siksi tuo koko DLSS/Super Sampling minkä nimen se ja tää keksiikään seuraavaksi pitäisi käyttäjien heittää romukoppaan, koska tuolle tielle me kuluttajina emme halua lähteä.

Ja kun seuraavaksi joku sanoo, että sitten ei 4k voi sitä ja 8k tätä, niin tiedän, se on se hinta siitä annatko paholaiselle sen pikkusormen ja menee koko käsi, vai teetkö juurikin sen mitä ne myyjät eivät halua, eli et suostu niiden toimintaan. Tuolla tiellä tullaan näkemään päivä kun ne DLSS:t yms. on se perus juttu ja silloin kuluttaja hävisi ja firma(t) voitti. Tähän asti tilanne on ollut helppoa kun DLSS kin oli huono toiminnaltaan. DLSS 2.0 on jo niin hyvä, että houkutus vastustaa kiusausta vain on suunnattoman suuri ja loppukädessä kuluttaja häviää, vaikka hetken se onkin juhlallista kun kaikki toimii hyvin.

edit: Ja pointti siis oli että olisi hienoa jos nopeusvertailu saataisiin tehtyä niin että jokainen ruutu on rendattu ns. täydellisesti, että jokainen pikseli olisi jokaisella kortilla identtinen. Sitten jos se "referenssilaadun" vauhti on liian kankeaa niin pelaajat voisivat itse ruuvata "suttuasetukset" kehiin.

Onneksi nämäkin huijaukset paljastui ja ne keskittyi lähinnä kusettamiseen jossain yksittäisissä testiohjelmissa. Tästähän nimen omaan päästiin eroon sillä, että kuluttajat nosti haloon ja firmojen oli taivuttava kuluttajien tahtoon ja rehellisyyteen.

Toisaalta kaikki dx pelit on standardi dxr apin päällä. Vulkan api:lle ei vielä ole standardia säteenseurantaan. Toki pelienginet on todennäköisesti optimoitu toimimaan hyvin nvidian dxr toteutuksen kanssa. AMD:lla/Pelintekijöillä lienee työtä tehtävänä, että dxr saadaan optimoitua.

Tämä on hyvä diasetti. Näkee hyvin miten paljon engineissä kikkaillaan, että saadaan dxr suorituskykyä ylöspäin

https://www.activision.com/cdn/research/Raytraced_Shadows_in_Call_of_Duty_Modern_Warfare.pdf

Siinä vielä suora linkki siihen diasettiin.

https://www.amd.com/en/technologies/rdna-2

Eli DXR SDK:n testiohjelmalla on saatu 471 FPS, alla olevan tweetin mukaan 6800XT:llä (vaikka sitähän tuossa ei kyllä suoraan sanota enkä löydä ainakaan tuolta sivulta mitään vihjettä mistä näin voisi päätellä). Kyseinen esimerkkiohjelma on vapaasti saatavilla (löytyy githubista) joten luonnollisesti sitä on ajettu muillakin korteilla. 3080 TUF täräyttää 630 fps lukeman ja 2080 ilmeisesti yltää 308 fps:ään.

Setupit on tietysti muuten täysin tuntemattomat, AMD:n testit ajettu jo pari kuukautta sitten eli optimointeja on voitu tehdä, kortista ei ole varmuutta, testi on erittäin simppeli (softallakin yli 30fps) eli ei kuvaa juuri pelisuorituskykyä eikä varsinkaan kerro mitään siitä miten AMD:n arkkitehtuuri tasapainoilee RT-kuorman ja "muun" kuorman kanssa.

Mutta jos lukemat antaa yhtään suuntaa niin a) ei ihme ettei juuri meuhkattu julkkiksessa RT:stä kun ollaan reilusti jäljessä Amperea b) suorituskyky on itse asiassa hiukan parempi kuin itse pelkäsin, varsinkin jos se vielä tuosta skaalautuu ylöspäin.

Se, että nvidia veti tuonkin asian vihkoon tässä julkaisussa ei automaattisesti tarkoita, että AMD:n luvut olisivat samanlaista liiottelua. Vain testit sen sitten kertoo vasta.

AMD:llä on ko asian kanssa pieleen menosta GPU puolella varsinkin jo perinteet, joten kannattaa nyt vain odottaa niitä kolmansien osapuolten kattavia testejä ennen hehkutteluja ja mopojen keulimisia..

Asian pitäisi kyllä selvitä parissa kuukaudessa..

Sitä juuri sanoin, että ei voi tietää ennen testejä onko liioteltu suorituskykyä, kuten nvidia teki vai onko linjassaan. Tuskin kuitenkaan näytetty liian pieniä suorituskykylukemia.

Tuo on aika hyvä veikkaus, lähempänä varmaan tuota kymmentä vuotta. High-hertz 4K tuli mahdolliseksi nyt julkistetuilla korteilla ja 8K samoilla hertseillä tarvitsee nelinkertaiset tehot.

Toisaalta GN oli kysellyt AMD:ltä mitkä dxr/rt-pelit toimisivat launchissa ja sieltä ei oikein luvattu yhtään mitään, eli jää nähtäväksi miten helposti tuo menee.

Mä epäilen, että worst case ne pelit toimisivat, mutta jos suorituskyky on optimoimaton niin amd estää niiden toimimisen siihen asti, että suorituskyky on kohdallaan. Tuolla keinoin välttää isot lööpit, jos perffi on nyt sikahuono, mutta 6kk päästä kohdallaan.

imho. jos amd ei saa toimimaan cyberpunk2077:sta launch:ssa ray tracen kanssa niin se ei ole kovin miellyttävää high end kortin ostajan mielestä. Toki osa ei siitä välitä, mutta kai high end kortin ostaja haluaa kaikki ominaisuudet päälle. Ainakin mun silmään cyberpunkin promopätkissä säteenseuranta on näyttänyt namilta. Eli amd:n kengissä jos olisin niin satsaisin säteenseurantapaukut cyberpunk:iin ja muut pelit myöhemmin, jos on pakko tehdä kompromissia.

No höpsönlöpsön ole mitään "perinteitä" mistään pieleenmenosta. Parissa julkaisussa ovat turvautuneet normaalista poikkeaviin asetuksiin optimisuorituskyvyn löytämiseksi, mutta nekin luvut olivat toistettavissa.

Muutoin kyse on ollut lähinnä cherrypickaamisesta mitä tekee jok’ikinen valmistaja.

Ihan vertailun vuoksi niin GTX 1070 (oma) saa tuossa 104FPS.

Skaalaus on joko pikselien monistamista tai verrattavissa lähinnä anti-aliasointiin. Ei mikään algoritmi osaa keksiä puuttuvaa informaatiota takaisin.

Itse taas muistelisin että AMD on nimenomaan kunnostautunut siinä että ei ole enää lapinlisää tuloksissa. Ja kun noita testituloksia katselee niin sinne olisi varmaan voitu myös poimia kirsikoina kaikki sellaisia pelejä joissa mennään ohi, mutta nyt vaikuttaa siltä että ihan rehdisti näytetään myös niitä heikompia tuloksia jossa kaveri vie.

Ja lavalla esim. Lisan sanat oli tarkasti harkittuja. Zen 3 julkkarissa suoraan rummutettiin että maailman paras peliprossu koska tietäävät että se on totta. RX6000 julkkarissa näin röyhkeästi ei sanottu, vaan sanottiin leading edge performance.

Koska rasteroinnissa voidaan vaikka ollakin käressä, mutta se on jo nyt varmaa että RT puolella ei pärjätä niin jos olisi kehuttu maailman parhaaksi niin se olisi kostautunut hirmusena paskamyrskynä interwebissä.

Mutta toisille kun mikään ei ole hyvä, ainoastaan välttävä.

Koita nyt päättää mitä pidät tärkeänä 8k pelaamista, vai jokin aika sitten rummuttamaasi 1080p low-settings 360 hz pelaamista.

Alkaa tuntua että aihe vaihtuu sen mukaan miten suosikkivalmistajasi: NVIDIA ja intel pärjää.

Jos laittaa 55" 4k ja 8k töllön vierekkäin niin näkeekö mitään eroa kuvassa joltain järkevältä etäisyydeltä?

Jotenkin tuntuu että vaatisi isomman ruudun ja ne isommat ruudut maksaa (70"+)

Jos teet sellaista työtä, jossa käsitellään isoja kuvia (esimerkiksi satelliittikuvia) tai vaikka karttoja/karttadataa, suuremmasta resoluutiosta on aina hyötyä. Ja eron kyllä näkee selvästi.

Pelaamisasioihin ja muuhun viihdekäyttöön en halua kommentoida mitään.

FoV 110 astetta ja oot optimissa tolle resoluutiolle. Tietokonenäytölle tyypillisellä etäisyydellä hyvä, toihan vastaa vaan neljän 27 tuumaisen 4k näytön setuppia. Telkkariksi auttamattoman pieni, ei olkkarissa ole moisesta mitään hyötyä.

Eikö tuo ole jo liian iso? 43" on havaintojeni mukaan optimi työpöytäkäytössä käsivarren mitan päästä. Mutta ehkä siihen tottuu, kunhan saa näytön tarpeeksi alas. Tuo 43" 4K on neljä 24" FullHD:ta, minulle aika passeli.

VR laseissakin toi 110 asteen FoV yhdistettynä tarkkaan kuvaan on kuulemma se graalin malja immersiivisyyden kannalta. Miksi työpöydällä tilanne olisi eri?

Henkilökohtaisesti en moista tässä vaiheessa haaveile matalista hertsiluvuista johtuen. Lisäksi noi nykymallit on joko todella kalliita tai hohkaa lämpöä aika paljon.

Koska VR-lasit on suunniteltu kattamaan koko ihmisen näkökenttä (tai mahdollisimman suuri osa sitä) "luonnollisesti", näet vain sen, et ympäröivää oikeaa maailmaa. Näytöt sen sijaan ovat "tauluja" joita katselet keskellä muuta maailmaa, jolloin tilanne muuttuu ainakin IMO merkittävästi.

Ei niitä oikein voi verrata silmän kannalta toisiinsa.

Toki tästäkin saa olla montaa mieltä, mutta itse en kaipaa takaisin postimerkkinäyttöjen maailmaan vaan suunta on selvästi isompaan päin. Eihän toi ole kuin kaksi sampan G9 näyttöä päällekkäin, ei kuulosta kovin dramaattiselta.

Ja oli asiasta mitä mieltä tahansa, niin noi 8k resoluution setit on lähtökohtaisesti suunniteltu tuota 110 asteen FoVia silmälläpitäen, sillä pienempänä et pahemmin hyödy kasvavasta tarkkuudesta.

Silmien terveyden kannalta onkin tärkeää että näyttö on mahdollisimman kaukana, siinä mielessä toi 8k 55 tuumaisena on aika järjetön. 110 tuumainen toimisi paremmin tuplaetäisyydeltä.

Samaa mieltä, ja tästä voisi mielellään jutella enemmän. Kuinka kaukana on kaukana, jne.

Pelkästään ahkera kirjojen lukeminen, monella lailla hyvä asia, voi tehdä kasvuikäisestä likinäköisen, tai lisätä sitä riskiä.

Sillä lailla olen mutuillut pitkän aikaa mutta en ole aiheeseen perehtynyt.

Likinäköiseksi tuleminen ei ole kivaa, mutta se otetaan annettuna, ettei ole mahdollista järjestää kirjojen ja ruutujen lukemista eri lailla kuin nykyjään.

Onhan se iso juttu jos kokonaiset sukupolvet osaksi turhaan hankkii silmälaseja.

VR-laseilla silmät tarkentuvat sille etäisyydelle, jolla VR-lasien näyttö on silmästä. Eli johonkin 10 senttimetrin päähän.

Tämä tuli hiljattain todennettua, kun kokeilin pelata poikani Oculus VR-laseilla Alyxia. Kun tuota ikänäköä on jo, piti laittaa lukulasit päähän jotta näkisin kuvan tarkasti. Ilman lukulaseja oli auttamattoman sumeaa.

Näen kauas tarkasti ilman silmälaseja (silmät leikattu 2,5 vuotta sitten – suosittelen muuten, jos joku haluaa päästä silmälaseista (likinäkö) eroon).

Tämän ikänäön vuoksi suosinkin itse suuria näyttöjä: ne voi laittaa niin kauas (nyt 40-tuumainen 4K n. 80 cm päässä), että voi katsella ilman lukulaseja tai näyttöpäätelaseja (lukulasit toimivat minulla n. 10-40 cm, näyttöpäätelasit n. 30-80 cm, tarkka näkö ilman laseja n. 70 sentistä alkaen).

Mutta tämä on sellaista pappojen jorinaa. Nuorilla silmillä tilanne on varmaan vähän toinen.

VR-lasien immersiivisyys syntyy eri syistä. Testasin tuota virtuaaliselta näytöltä pelaten FS2020 VR-laseilla (Reverb G1), ei tule samaa tunnelmaa kuin VR:llä vaikka olisi trackIR käytössä. Työpöydällä liian isolla näytöllä työskennellessä voi tulla niska- ja hartiavaivoja jo 43" jos näyttö on liian korkealla. Ei 55" kuitenkaan välttämättä mahdoton ole jos kuvan alareunan saa tarpeeksi alas. Minulla näkyvän kuvan alareuna on kuitenkin 10 cm korkeudella pöydän pinnasta mitattuna, joten varaa olisi. En kuitenkaan ottaisi ainakaan isompaa kuin 55" ellei tosiaan laita näyttöä kauemmaksi.

Jos näyttö taas ei ole pöydällä niin silloin tilanne on eri. Taikka lentosimuissa TrackIR:n kanssa tuollainen iso näyttö on varmasti parempi kuin 43", itse puhuin lähinnä hyötykäytöstä. Peleissä jos ei tarvitse usein katsoa reunoja niin ei se silloin niin rasita niskaa ja immersio lienee parempi. Etuina VR:ään on että ulkoiset ohjaimet, mittarit yms näkyvät ja kuva on huomattavasti tarkempi kuin VR:llä eikä vaadi niin paljoa tehoja. Immersio ei vain ole mielestäni lähellekään samaa ellei ole kotiohjaamoa. VR antaa syvyysnäköä joka helpottaa huomattavasti esimerkiksi helikopterilla lentämistä.

VR lasien tarkennus vastaa jotain 3 metrin etäisyyttä. Jos kyse olisi 10 cm niin en pystyisi tarkentamaan laseilla ollenkaan vaan toimisi ilman laseja paremmin.

VR lasien tarkennusetäisyys on täysin mallikohtaista ja on pääsääntöisesti jotain välillä n. 1.5 metristä äärettömyyteen.

Jep, ja tästä syystä johtuen 8k on monella tapaa järjetön ajatus. Järkevää hyötyä saa vasta kun heittää ergonomialla vesilintua.

Uutisessa luki, että: "AMD täytti ainakin omien testiensä mukaan lupauksensa ja taistelee nyt tasaväkisesti näytönohjainmarkkinoiden tehokkaimman näytönohjaimen tittelistä."

niin tulkitsin tämän, että uutisessa sanottiin että AMD on omien testiensä perusteella täyttänyt lupauksensa ja sitten uutisen kirjoittajan päätelmä olisi ollut sen perusteella: "taistelee nyt tasaväkisesti näytönohjainmarkkinoiden tehokkaimman näytönohjaimen tittelistä".

Ehkä ymmärsin sitten väärin mitä tuolla yritettiin sanoa, mutta kyllä tuon tekstin voi noinkin tulkita (piti ihan äidinkielen opettaja kaverilta tarkistaa).

Ja mielestäni en ole täällä kirjoittanut yhtään sen negatiivisemmin AMD:stä mitä suurin osa kirjoittaa Intelistä ja Nvidiasta, pikemminkin olen pyrkinyt heidän kirjoitusasua kopioimaan, mutta vaihtamaan kohteen vain AMD:ksi ja katsomaan miten väki siihen reagoi. Ainakin nopeasti näyttää siltä, että Nvidiasta ja Intelistä saa sanoa mitä tahansa, mutta jos samoin sanoo AMD:stä niin se on heti negatiivista tekstiä siihen tapaan mitä ei saisi täällä foorumilla sanoa. Se kummastuttaa kun en ole huomannut että kun Inteliä tai Nvidia kuvaillaan samoin monien toimesta niin siihen ei puututa.

Siitä olen aidosti tyytyväinen että AMD tuo kilpailua, mutta koen että minulla on myös oikeus esiittää kritiikkiäkin jos sille on paikkansa.

Vie vähän pohjaa muutenkin omituiselta vaatimukselta että pitäisi olla "puhdas" AMD systeemi alla jos kyse tosiaan on vain siitä PCIe-speksin ominaisuudesta (eikä edes liity PCIe4:ään). AMD:n toteutus toki voi tehdä lisätaikoja, mutta rajoitus omalle alustalle vaikuttaa nyt hieman kotiinpäin vedolta.

Edit: Tosin sitten herää kysymys että miksi vain Ampere, mutta ehkä siinä voi olla ihan oikea rautarajoitus. Tai sitten ei haluta enää antaa suorituskykyä 2080Ti:lle. Kukapa tietää.

Sulla jäi toi toinen twiitti puuttumaan;

Varsinkin toi "Doesn’t look like it’ll be ready before RX 6000 launch, but we’ll keep an eye on development" hieman hymyilytti.

Edit. Hymyilytti siis sen takia, että jos Nvidia oli tuota suunnitellut jo pidempään (kuten oletettavasti tuotekehityksen kannalta vaatii), niin miksi siitä huudeltiin jälkijunassa vasta siinä vaiheessa, kun AMD oli omansa esitellyt?

Vaikuttaa hieman samalta, kuin "ei meillä ole mitään ongelmia tuotannossa" selittelyltä.

nVidian SAM Tuki tulee vain Amperelle siksi, että muut nVidian näytönohjaimet eivät tue PCIe gen4 -standardia.

Ja miksi AMD:n SAM-toteutus ei tue Inteliä? Varmaan siksi, että intelillä ei ole tarjolla PCIe gen 4 -emolevyjä/prosessoreita.

GN:n mukaan ei vaadi PCIe Gen4:ää;

Sinänsä mielenkiintoista että tämä on näköjään mahdollista jo pci-e 3, ei vaadi 4. Kai tuossa täytyy olla raudan rajoituksista kyse, muuten olisi aika outoa ettei sitä olisi enabloitu jo aikaa sitten kun näyttää antavan ihan hyvin suorituskykyä.

Tuonne toisaalle jo vastasinkin, että nopeushyöty hitaammalla PCIe -versiolla voi olla aika marginaalista, jolloin AMD ei ole nähnyt tarpeelliseksi sen tukemista (etenkin, kun AMD on toimittanut PCIe gen4 –näytönohjaimia jo pidempään). Varmaan teknisesti saadaan toimimaan PCIe gen3:n kanssakin.

Eiköhän tuossa ole takana ihan 3 syytä:

1) Saadaan uusista tuotteista paremmin rahaa ja tämä myy niitä paremmin.

2) Vanhemman raudan tukeminen vaatii tukea ja validointia, eli kuluttaa rahaa.

3) Featuren aktivoiminen vanhoille korteille ilman validointia voi aiheuttaa ongelmia ja tahraa mainetta enemmän, mitä tuen puuttuminen.

Linuxissahan tuo on ollut jo pitkään, mutta jos siellä tulee ongelmia, niin porukka ei valita foorumilla, paskaa rautaa/paskat ajurit postauksilla.

Ja tämä on varmaan syy miksi AMD on validoinut sitä vain omalle raudalleen, ei intelille, koska rahankulutus pitää jotenkin puoltaa oman raudan myyntiin. Nvidialla taas ei ole prossa-affiliteettiä niin, niin heidän validointi voi lähteä yleensä versus prossuihin. Saattaa olla että AMD enabloi tuota kilpailutilanteen takia myös intelin prossiin, ai hitsi, kilpailu on tässäkin hyvästä!